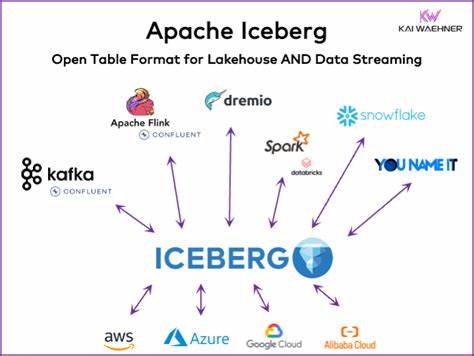

随着大数据生态系统的快速发展,实时数据流处理和大规模分析需求日益增长。Apache Kafka作为领先的流数据平台,凭借卓越的可扩展性和高吞吐能力,成为各类应用场景中的核心数据中枢。然而,将Kafka中的流数据高效地整合进分析仓库一直是数据工程领域的痛点。Apache Iceberg以其先进的表格式设计和对大数据湖场景的优化,为大规模分析场景提供了理想解决方案。结合这两者的优势,如何实现Kafka数据无需传统连接器,直接写入Iceberg表成为了业界关注的热点。传统架构中,从Kafka流式数据写入分析存储通常依赖于复杂的ETL管道或连接器组件,如Kafka Connect。

这些方案虽然可行,却带来了额外的运维复杂度、数据复制和延迟问题。Iceberg Topics技术,通过利用Kafka的远程存储管理(Remote Storage Manager, RSM)插件架构,实现了Kafka数据流直接落地Iceberg格式,极大简化了数据流向分析层的路径。Iceberg作为一种开源的高性能表格式,支持ACID事务、时间旅行、灵活的模式演进和隐藏分区管理,具备显著优势,特别适合批流结合的分析场景。它能够保证数据一致性和查询的灵活性,同时高效存储结构亦助力显著降低存储成本与查询延迟。通过将Kafka Topic配置为Iceberg Topics,Kafka的生产者依然使用标准API进行消息生产和消费,后台的RSM插件同步将这些流数据转换为分区明确、模式一致的Iceberg数据文件,并写入兼容的对象存储服务中,如MinIO或AWS S3。采用该方案,Kafka不仅是实时流处理的引擎,同时成为统一数据湖的入口,实现流与分析的无缝对接。

想要在本地实验这一技术,可通过Docker环境搭建包括Kafka Broker、Karapace Schema Registry、MinIO对象存储、Iceberg REST Catalog以及Spark查询引擎的完整生态。用户只需构建Aiven远程存储管理插件,并启动对应容器,即可完成从数据生产到Iceberg表自动生成的全流程体验。在演示中,创建具备Iceberg集成的Kafka Topic,以Avro格式定义消息结构,并生产模拟人员数据。RSM插件负责信息捕捉和转换,自动推送生成时间戳分区的Iceberg数据文件。随后使用Spark SQL在笔记本界面直接查询这些实时数据,实现毫秒级别数据可视化分析,无需传统的批处理等待时间。此外,用户可以通过MinIO管理界面直观浏览Iceberg表的底层数据文件和元数据,更透彻理解数据存储结构与变更历史。

这一架构的最大亮点在于极大简化了数据工程工作流。无需维护额外的ETL管道,也不必担心数据一致性或者延迟引发的分析准确性问题。开发团队可以继续依赖熟悉的Kafka API,分析师则获得实时且一致的数据视图,支持多样化的交互式分析场景。从企业角度看,融合Iceberg的Kafka Topics能够显著降低基础设施成本,避免重复存储和冗余计算资源。同时还提供了灵活的架构升级空间,支持未来基于云原生技术的扩展与自动化管理。面对不断增长的数据规模与多变的业务需求,采用无连接器的Kafka至Iceberg数据写入方案,不仅提升了数据的实时性和准确度,还推动了数据平台从传统单一系统向融合、智能的综合体系转变。

无论是物联网实时监测、金融风控、还是用户行为分析,这种解决方案都展现出强大的适用性和潜力。未来,随着Kafka和Iceberg生态的持续演进,期待更多集成创新不断涌现,加速数据驱动的智能决策进程。开发者和数据工程师可借助开源社区资源,结合自身业务特点进行灵活部署与优化,共同推动大数据技术的边界不断扩展。总之,实现Kafka数据无连接器直写Iceberg,是流数据处理和分析融合的重大突破。它不仅优化了数据管道流程,还提升了分析性能与管理效率。把握这一技术趋势,将有助于打造更加高效、智能、稳定的数据平台,助力企业实现数字化转型和价值最大化。

。