随着人工智能技术的不断进步,大语言模型(LLM)在软件开发中的应用日益普及,尤其是在代码生成、自动调试和辅助开发方面展现出强大的能力。然而,在实际使用过程中,开发者往往会面对一个棘手的问题 - - 调试时大量无用信息涌入LLM,导致Token浪费严重,调试效率低下。如何优化LLM的Token使用,成为提升开发体验和生产力的关键所在。调试是软件开发中不可避免的一环,尤其是在复杂的多语言、多技术栈环境中,构建、测试、运行各种命令会产生海量日志输出。这些日志中虽然包含错误信息,但通常被大量的编译过程信息、依赖下载进度、缓存信息所淹没。以React项目的npm构建为例,终端满屏的webpack配置、浏览器兼容性警告和构建进度日志让LLM必须处理大量无关Token,然而帮助调试的关键往往仅是几行错误提示。

这种现象不仅存在于JavaScript生态,Python、.NET、Java、Docker、Rust等各领域都面临同样问题。每次调用LLM时,都是冗余Token的消耗,增加了API调用成本和响应时延,严重影响用户体验。传统上,许多开发者尝试利用grep、findstr等命令过滤输出,只提取带有"error"、"fail"等关键词的日志。但依赖LLM自行编写过滤命令存在诸多弊端。LLM可能会忘记加入过滤条件,或因正则表达式不精准导致关键信息被忽略或杂音依旧存在。此外,不同语言、不同工具的错误格式千差万别,需要维护大量复杂的正则表达式模式。

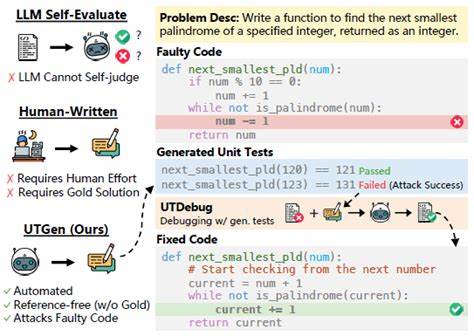

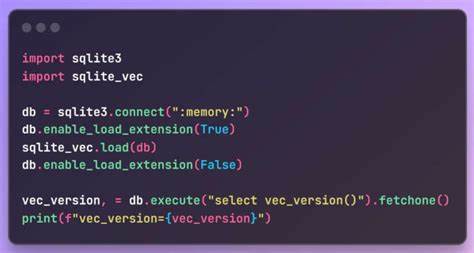

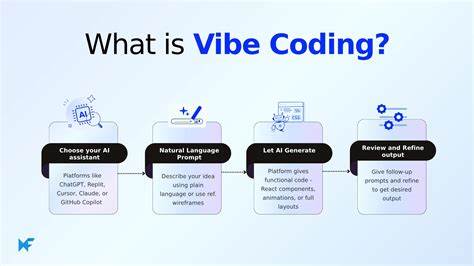

更何况深夜调试时频繁调整过滤条件令人身心俱疲。为了根本解决这一问题,出现了一种创新思路:开发专门面向LLM调试场景的命令执行和日志过滤工具 - - 例如Apparatus.Exec。此类工具的核心理念是让命令只输出LLM真正需要的错误信息,剔除所有无意义的构建和运行噪音。用户可以通过配置文件定义"快捷方式"和"过滤器",将复杂命令封装为简洁调用,后台自动执行并由正则表达式过滤信息流,只传递匹配错误信息的日志行给LLM。这种设计解放了用户和LLM的交互负担,让调试过程变得更加精准和简洁。Apparatus.Exec通过提供预设错误匹配模板,支持React编译错误、TypeScript类型错误、测试失败信息、模块缺失提示等多种场景,让用户快速上手。

每个快捷方式可指定工作目录,适应多语言、多子项目的单仓库结构。通过参数开关,还能切换"无过滤模式",便于用户检查完整日志,灵活完善正则表达式。不仅如此,因为实际上传递给LLM的Token大幅减少,调试对话变得更为高效和经济。每日数次的构建调试环节,Token消耗从成千上万锐减至几百,大幅降低云端模型调用费用。更重要的是,由于LLM面对的是高浓缩的错误信息,它的理解和推断准确率自然提高,调试建议更具针对性,开发者无需在海量输出中费时查找关键信息。这对于使用Claude Code、Cursor等LLM辅助开发平台的用户而言极为实用,也为未来LLM与开发者协同工作模式注入全新可能。

尽管这类工具有诸多优势,依然存在一定局限。复杂的shell特性如管道、重定向、环境变量不被支持,交互式命令无法使用,实时流水线日志也难以展示。用户仍需在终端保留传统调试能力。然而对于大多数日常调试场景,特别是重复执行的构建与测试任务,使用过滤工具极大提升了工作效率和成本效益。从更广阔视角来看,这种以用户需求为导向的LLM使用优化策略,将构建更智能、更高效的开发者助手生态。一方面令AI服务商降低模型负载,另一方面帮助开发者将注意力集中于核心问题,减少因环境噪音引发的认知负担。

展望未来,结合人工智能技术的不断演进和开发者社区的共建,类似Apparatus.Exec的工具将不断完善,支持更多语言和框架,甚至实现智能动态过滤和错误聚合分析,为开发流程自动化注入新动能。同时,更多定制化的Token优化方案和交互优化手段,也会推动整个软件开发行业迈入新时代。总之,提升LLM Token使用效率不仅是技术细节上的革新,更是推动AI赋能软件开发的重要一步。借助智能命令执行与过滤工具,开发者可以享受精简而精准的调试体验,降低成本,提升响应速度。未来随着更多协同工具涌现,开发者与AI的协作必将更加高效顺畅。掌握这一趋势,正是每个追求卓越开发效率从业者的必备技能。

。