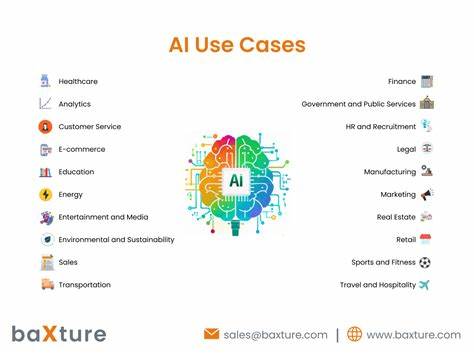

随着人工智能技术的飞速发展,越来越多领域开始依赖于自动化和智能化系统。然而,在众多赞誉声中,也存在针对人工智能的有力质疑,尤其是从神经科学和语言学的视角出发。这些质疑不仅对人工智能的当前能力提出挑战,更引发了对其未来潜力与伦理边界的深刻思考。本文将从神经科学和语言学两大领域的最新研究出发,探讨人工智能面临的核心问题,并结合相关学术成果提供系统性的分析。神经科学作为研究大脑功能的科学,为理解智能的本质提供了基础框架。人类大脑复杂的结构和动态的信息处理方式,是现今任何人工系统难以匹敌的。

尽管深度学习模型在某些任务中表现出惊人的能力,但它们依然缺乏大脑灵活适应能力和自主学习机制。神经科学研究揭示,脑内的神经元网络不仅仅进行简单的信息传递,更涉及复杂的情境理解、感知整合和情绪反馈等多维度交互。这种多层次、多模态的信息处理能力,当前人工智能难以全面模拟。此外,大脑在能耗与执行效率上的表现也远超现有的人工计算设备。语言学作为研究语言本质与结构的学科,对人工智能的自然语言处理能力提出了严格要求。语言不仅是沟通工具,更是思考的载体。

许多语言学家指出,现有AI系统在理解语境、隐喻、语义多义性及语用学方面依旧存在巨大缺陷。例如,语言的多义性和上下文依赖使得自然语言理解成为一个极其复杂的任务,而目前的AI往往依赖大量训练数据和模式匹配,缺乏真正的语言"理解"能力。通过对神经科学和语言学的深入研究,学界逐渐意识到人工智能的算法模型需要更贴近人类认知机制。传统的符号主义和统计学习方法虽有其价值,但在面对复杂认知任务时显得力不从心。有研究提出,融合神经科学启发的模型,如神经符号学习、动态神经网络等,有望突破现有瓶颈。然而,这些方法尚处于萌芽阶段,距离真正模拟人脑智能仍有较大差距。

从伦理和社会层面来讲,人工智能的过度依赖可能带来的风险也值得关注。神经科学强调大脑意识和自我认知的复杂性,而当今的人工智能尚未具备类似的自主意识,无法完全替代人类决策。随之而来的信息偏见、隐私泄露、就业替代等问题,也使得对人工智能的盲目推广充满隐忧。总体来看,神经科学与语言学领域的研究为我们提供了理解人工智能局限性的关键视角。人工智能虽然在某些特定任务中表现优异,但距离模拟甚至超越人类大脑的灵活和多样化智能仍有显著差距。未来的发展需要跨学科综合创新,不仅要优化算法,更要深入理解大脑和语言的本质机制,才能打造出真正具备强大适应性和普适性的智能系统。

与此同时,制定合理的伦理规范和政策框架,也是保障人工智能健康发展的必要条件。人工智能的发展是人类智慧的延伸,但唯有清醒认识其限制和潜在风险,才能引导技术朝着造福社会的方向稳步前行。随着对神经科学和语言学研究的不断深入,未来人工智能或许能够突破今日的瓶颈,实现从模拟到真正理解的飞跃。在此过程中,科技界、学术界与社会各界都应积极参与,共同塑造一个安全、公正且高效的智能时代。 。