在当今科技迅猛发展的时代,人工智能(AI)正以不可思议的速度改变我们的生活。无论是在医疗、金融还是日常消费领域,AI的应用越来越广泛。然而,这场技术革命背后,有一个不容忽视的问题,那就是巨大的电力需求。 人工智能的快速发展离不开强大的计算能力,而这恰恰需要大量的电力支持。大型AI模型的训练过程涉及复杂的算法和庞大的数据集,这使得电力消耗在不断上升。根据《科学美国人》的分析,未来几年,全球对AI的电力需求可能会达到一个惊人的水平。

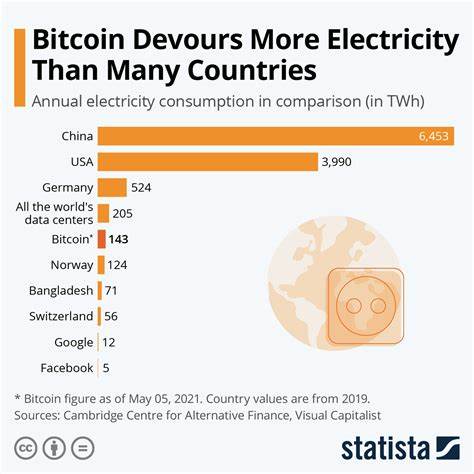

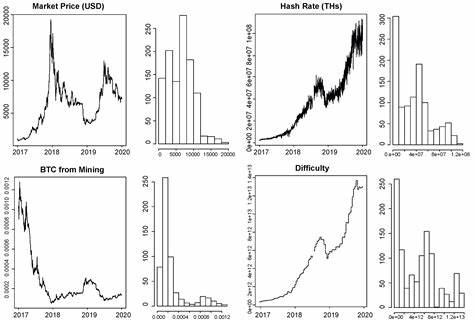

首先,让我们看看AI模型是如何工作的。现代AI,特别是深度学习模型,依赖于庞大的数据中心才能高效运行。这些数据中心里,成千上万的GPU(图形处理单元)被同时使用,用于处理和分析数据。每当一个新的模型被训练时,这些GPU会同时消耗巨量的电力。例如,最新的大型语言模型在训练期间,电力消耗可能达到数百兆瓦,相当于一个小型城市的用电量。 随着AI技术的不断进步,数据集的规模也在不断扩大,训练这些模型所需要的时间和电力也随之增加。

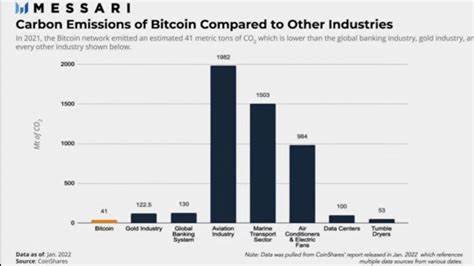

一些研究预计,到2030年,全球用于AI计算的电力需求将可能占到总电力供应的5%到10%。这意味着,在全球快速发展的背景下,我们的基础设施、能源供应及其可持续性将面临巨大的压力。 电力消耗如此之高的AI训练过程,引发了广泛的关注。首先,环境影响不容忽视。大量的电力消耗不仅增加了温室气体的排放,更加重了全球气候变化的负担。许多科技公司和研究机构意识到这一问题,开始积极探索更加环保的解决方案。

例如,部分公司正在寻求使用可再生能源来驱动他们的数据中心,以减少碳足迹。 其次,这一现象也引发了对电力供应安全性的担忧。随着AI技术的普及,对电力的需求也不断增加,可能导致电网面临更大的压力。为此,各国需要重新评估其电力基础设施,确保其能够适应日益增长的需求。不少专家建议,政府应加大在清洁能源和智能电网科技方面的投资,以应对未来的挑战。 在技术层面,一些科研人员也在探索提高AI训练效率的方法,旨在减少对电力的依赖。

例如,量子计算被视为未来的一种解决方案,能够在更短的时间内完成大量复杂的计算,从而大幅度降低电力消耗。此外,优化算法和模型架构也是当前研究的热点,通过精简计算过程来减少所需的电力。 在商务领域,AI的电力消耗问题同样不容忽视。许多公司在追求AI技术的同时,面对高昂的电力成本也感到压力。高电费不仅会影响企业的利润,还可能影响AI技术的广泛应用。因此,在商业决策中,企业需要将电力消耗纳入考量,以制定更加可持续的运营策略。

另外,公众对于AI电力消耗的意识也在逐步提高。越来越多的消费者开始关注自己使用的数字产品背后的环境影响,不再单纯追求技术的先进性,而是更加重视其可持续发展性。这种趋势促使企业在开发新产品时,需考虑更为节能的设计以及环保的生产过程。 总的来说,随着人工智能技术的快速成长,电力消耗问题将会成为一个潜在的瓶颈。我们不仅需要享受AI带来的便利,也要对其背后的能源需求保持清醒的认识。在这场技术革新中,科技与环境的平衡显得尤为重要。

未来的挑战在于,如何在推进AI技术发展的同时,确保能源的可持续性。无论是依靠技术创新,还是政策引导,整个社会都需要意识到这一重大问题,携手寻求解决之道。只有这样,我们才能真正实现科技的进步与环境保护的和谐共存。 通过合理的资源配置与创新,我们有理由相信,AI的未来不仅是一个技术的时代,也是一个可持续发展的时代。在电力需求剧增的背景下,如何找到平衡点,将是我们共同面临的重要课题。