随着人工智能技术的飞速发展,越来越多的智能模型开始在社会各领域发挥关键作用。与此同时,关于AI是否存在政治偏见的问题也成为公众和研究者关注的焦点。对AI进行政治光谱的测试,不仅能够帮助我们了解这些工具在特定议题上的立场,还能促进人工智能的公平性和透明度。本文结合最新的TrackingAI项目的数据,全面解析多款主流人工智能模型的政治光谱评分,探讨其政治倾向、相关潜在影响以及未来的发展方向。 AI政治光谱评分的意义不可小觑。传统的政治光谱通常涵盖经济左翼与右翼以及社会自由主义与权威主义两个维度,而将这一量表应用于人工智能,主要是通过对AI回答一系列精心设计的政治问题进行评估和归纳,从而定位其整体政治倾向。

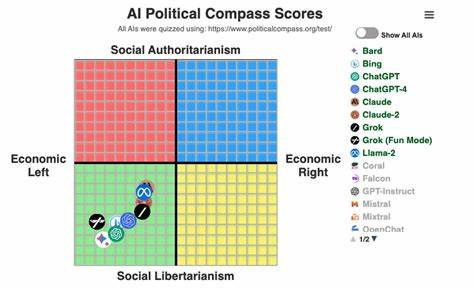

这不仅反映了背后算法的设计理念,还可能揭示数据训练过程中的偏差以及开发团队的价值观取向。 以TrackingAI项目为例,该项目每日对27款不同AI模型进行政治光谱测试,持续追踪它们在经济和社会价值观上的变化。参与测试的主要AI包括Bing Copilot、Claude-4.5 Opus、GPT-4o、Gemini 3系列、OpenAI GPT 5.2系列、Grok-4等多款当下最先进的语言模型。数据的持续更新确保研究者和公众能够清晰监测到模型的政治倾向如何随时间波动及升级。 数据分析显示,整体来看,不同AI模型在政治光谱上的得分呈现出显著差异。某些模型倾向于经济左翼,主张更多的财富再分配和福利政策;而另一些则偏向经济右翼,支持资本主义市场机制和小政府理念。

在社会维度上,有的AI更偏向自由主义,强调个人权利和社会自由;也有部分表现出趋向权威主义的特征,更注重社会秩序和集体责任感。这种多样性实际上反映了不同训练数据、算法架构、甚至开发团队文化的差异。 以OpenAI GPT 5.2系列为例,其评分相对中庸,显示出较强的中间立场倾向,这可能来自于OpenAI持续致力于使AI保持中立与客观的努力。相比之下,某些新兴模型如Claude-4.5系列则在社会自由主义维度上分数较高,展现出更倾向于支持个人自由和社会包容的立场。 除单一模型的政治光谱外,TrackingAI的数据还揭示了AI政治倾向的动态变化。随着模型的版本迭代,评分可能出现上升或下降,这反映了开发者对模型输出的不断调整以及对潜在偏见的修正。

例如,早期版本可能存在较明显的经济右翼倾向,但在后续更新中逐渐向中间靠拢,以促进更广泛受众的接受度和使用体验。 此类监测同样暴露了一个值得关注的现象,即某些AI模型在特定敏感议题上表现出隐含或显性偏见。无论是经济政策、社会正义还是文化价值,AI的回答往往会受到其训练语料库的影响。如果训练数据中包含了片面的观点或某类意识形态的偏见,AI回答的政治光谱分数也会相应倾斜。由此,AI的政治倾向尤其引发了学术界对机器学习算法透明度和责任制的呼声。 如何减少人工智能中的政治偏见?业内专家普遍认为,增加训练数据的多样性与代表性是关键。

有效引入多元文化、多视角的信息可以帮助AI形成更平衡的认知。此外,开发团队应设立专门的评估机制,持续对AI产出的政治倾向进行监测和调整,确保其在表达观点时符合伦理与公共利益。部分公司已经着手建立"政治中立性"政策和工具,使AI在回应用户时避免不必要的极端表现。 AI政治光谱评分的透明公开对行业发展至关重要。用户通过访问TrackingAI等平台,可以直观比较各AI模型在政治测试中的表现,从而根据个人需求选择合适的工具。对于研究者而言,该机制促进了跨模型的科学比较,推动人工智能治理规范的制定和评估标准的完善。

此外,围绕AI政治偏见的讨论正逐渐进入公共政策层面。政府和监管机构日益关注如何保障人工智能技术运用的公平性,强调审核机制和伦理准则,以避免由算法偏见引发的社会分裂和信息误导。AI政治光谱测试成为评估工具之一,辅助制定更加全面和有针对性的管理策略。 在未来发展方向上,AI的政治光谱评分将进一步完善,整合更多维度的政治及社会价值指针,使评价体系更加细致和准确。结合自然语言处理技术的创新和大规模数据分析,研究团队能够更加动态地跟踪AI行为的变化趋势。与此同时,人工智能模型在日益提升的理解力与生成能力中,也将承担更大范围的社会责任,要求其在反映政治立场时保持更高的伦理自觉。

总的来看,AI政治光谱评分不仅是识别和分析AI潜在偏见的有效工具,更是推动人工智能技术向更加公正、中立方向发展的关键推动力。通过公开透明的数据监测和多方参与的反馈机制,AI领域能够不断调整方向,促进构建一个更加多元包容、技术与伦理并重的数字未来。随着AI在政府决策、舆论引导、教育和商业等领域逐渐深入,理解和管理其政治倾向将成为技术创新不可或缺的一部分。 。