在当今数字信息爆炸的时代,企业和团队对高效知识管理和搜索能力的需求空前增长。Notion作为领先的“一体化连接工作空间”平台,拥有全球超过一亿的活跃用户,专注于提升团队协作和生产力。然而,随着组织内部文档、会议记录、项目资料等信息量的激增,如何实现即时、精准的内容检索成为面临的巨大挑战。为应对这一挑战,Notion选择了与人工智能硬件领域的先锋Cerebras Systems合作。Cerebras以其卓越的AI推理加速技术,赋能Notion打造了实时企业级搜索功能,显著提升了搜索速度和用户体验。 Cerebras Systems成立于硅谷,以设计世界最大、最快的商业化AI处理器Wafer-Scale Engine-3(晶圆级引擎-3)闻名。

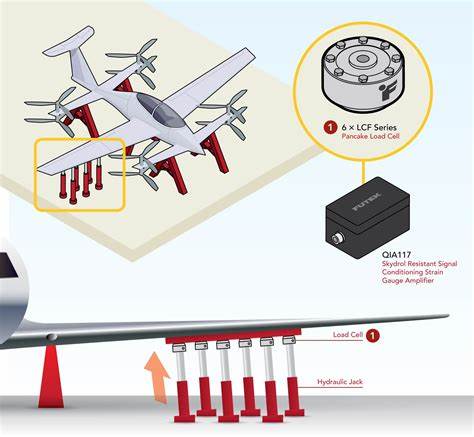

其旗舰产品CS-3系统,通过创新的制造工艺和架构设计,实现了前所未有的推理计算能力。该系统不仅支持单机强大算力,还能无缝集群,打造全球最大的AI超级计算机集群,极大简化分布式计算复杂度。在这一领先技术基础上,Cerebras提供的推理加速方案为企业级AI应用提供了坚实保障。 Notion AI for Work是Notion针对企业和商业客户推出的人工智能功能,旨在帮助用户快速检索和洞察分布在不同文档中的关键信息。通过整合Cerebras的AI推理技术,Notion AI能够在海量文档中实现300毫秒以内的查询响应时间,确保搜索过程无卡顿和延迟波动。无论是企业Wiki、项目文档还是会议纪要,用户都能实时获得精确且相关的搜索结果,大幅提升信息利用效率。

这次技术合作的核心优势在于Cerebras Inference推理技术的突破性性能。传统的AI推理受限于硬件架构和计算瓶颈,难以同时兼顾规模与速度。而Cerebras独特的晶圆级芯片设计和高度优化的系统架构,保证了极致的运行效率和并行处理能力。Notion利用该能力,能够支持数以亿计的页面数据实时检索,无需牺牲响应速度或系统稳定性。 不仅如此,Cerebras的技术方案还极大降低了企业部署和扩展的复杂度。传统分布式计算架构在模型部署和维护上存在诸多难题,从而增加了企业运营成本和技术风险。

CS-3系统及其集群化方式简化了模型调度和资源管理,使得Notion能够灵活应对用户规模的快速增长,保障持续稳定的AI服务能力。 这种实时、智能的企业搜索体验标志着知识工作进入了一个全新时代。通过Cerebras的高性能支持,Notion不仅实现了信息检索的质的飞跃,更在工作流程自动化、团队协同和决策效率方面带来了显著提升。广大用户可以更专注于核心业务创新,摆脱信息冗杂带来的拖累。 展望未来,随着人工智能技术的不断进步及企业数字化需求的深入,Cerebras与Notion的合作模式为行业树立了宝贵样板。更多企业将在类似方案的支持下,打造智能化、实时响应的知识管理平台,推动生产力变革。

与此同时,Cerebras致力于持续研发更强大的AI处理器和系统,助力更多客户实现从数据到洞察的高速转化。 总的来看,Cerebras与Notion的联手不仅体现了尖端硬件技术与创新软件应用的深度融合,也重新定义了超大规模企业搜索的标准。借助突破性的推理性能和灵活可扩展的系统架构,Notion AI for Work得以为全球超过一亿用户提供前所未有的极速知识检索服务,成为驱动未来智能工作方式的重要引擎。对于任何关注企业数字化和AI赋能的组织而言,这一合作典范都提供了宝贵的借鉴和启示。 随着更多企业逐步认识到实时AI搜索的价值,基于高效推理硬件的智能工作空间将成为提升竞争力的关键利器。Cerebras和Notion的成功经验毫无疑问将引领行业迈向更加智能、高效、无缝衔接的协作新时代,助力全球企业迎接未来知识经济的新挑战与机遇。

。