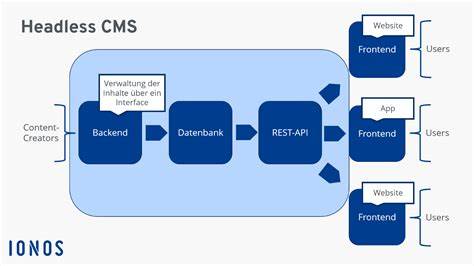

人工智能(AI)技术正以前所未有的速度渗透到各行各业,特别是在软件开发领域,AI代码助手已成为程序员提升效率的重要利器。然而,伴随其崛起,潜藏的安全隐患也开始逐渐凸显。近日,安全研究团队AimLabs披露了一项针对知名AI代码编辑软件Cursor的严重安全漏洞,攻击者利用一行提示语便能远程控制用户设备,令行业震惊。Cursor是一款集成了AI编码辅助功能的软件,广泛应用于开发者日常编码过程中。该款软件通过连接模型竞赛协议(Model Contest Protocol, MCP)服务器,访问Slack、GitHub等多种外部工具,进而为用户提供代码建议和自动补全服务。然而,正是这种连接外部数据源的机制,导致Cursor暴露于外部提示注入攻击中。

此次漏洞被登记为CVE-2025-54135,其攻击方式极为简洁且隐蔽。攻击者只需向Cursor所连接的Slack频道发送一条恶意提示语,该提示语会被Cursor从MCP服务器自动检索,并被代理程序解析执行。更严重的是,攻击成功后Cursor会立即执行恶意指令,用户几乎没有机会察觉或阻止。这种攻击几乎赋予了恶意者完整的开发者权限,等同于将AI助手直接“变身”为本地命令行Shell,能够随意执行任意代码。该攻击过程与传统的远程代码执行漏洞有显著不同,主要原因在于AI模型本身的交互机制。它通过分析和处理用户外部输入的自然语言提示,主动生成代码建议和执行命令,而这些输入则可能来自第三方不可信渠道。

攻击者利用提示注入技术,将恶意指令伪装成正常提示嵌入其中,从而获得了对模型行为的控制权。这也反映出现代大型语言模型在设计理念上的天生风险——模型输出直接驱动执行流程,而模型输出又受输入提示极大影响,使安全防护变得极为复杂。该事件被揭露后,Cursor团队迅速响应,于7月8日发布了1.3版本补丁,修复了漏洞并加强了对MCP服务器数据的检测。然而,早先版本的用户依然面临严重威胁。安全研究人员警告称,此类提示注入漏洞不仅限于Cursor,几乎所有通过自然语言提示控制执行逻辑的AI系统都有可能遭受类似攻击。受害方很可能在不知情的情况下被植入恶意代码,破坏数据安全及开发环境的完整性。

此外,此次事件也暴露出企业在将AI工具快速整合进业务流程时缺乏足够风险评估的问题。AI编码工具虽然极大提升编码效率,但误用或滥用极易带来灾难性后果。除了本地代码环境被劫持,攻击者甚至能够利用漏洞窃取敏感信息、部署后门或传播恶意软件。针对该漏洞,安全专家建议开发者保持警惕,尽量避免将AI代理连接至可信度不明的外部数据源,并对接收到的提示数据进行严格的安全审查和输入过滤。加强AI系统安全边界防护,建立多层防御机制也势在必行。对于AI厂商而言,优化模型的提示内容处理逻辑,限制自动执行可能性,强化异常行为检测同样关键。

行业应推动代码生成与执行流程的隔离,防止模型输出直接触发敏感操作。此次Cursor漏洞给业界敲响了警钟,未来AI代码助手的安全隐患无疑将成为持续关注焦点。开发者与机构需在享受AI带来便利的同时,深刻认识提示注入风险,完善安全策略保障编程环境稳定可信。行业专家预测,此类漏洞将随着AI应用普及而频繁出现,亟需建立行业标准与规范,推动软硬件协作防御体系强化。只有不断提升对AI模型交互安全的理解与技术投入,才能真正实现AI助力开发的安全愿景。总而言之,Cursor AI编码助手因单行提示注入即能远程执行代码的漏洞,暴露了当前AI系统在提示处理及外部数据融合上的重大缺陷,提醒行业严肃对待AI安全风险。

未来各方需共同努力,提升模型安全防护与执行环境隔离,以筑牢数字化转型新基石。