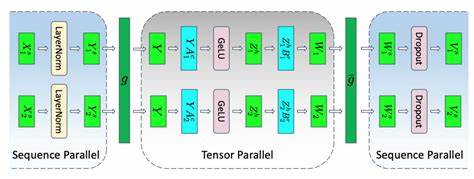

随着人工智能技术的迅速发展,专用的硬件加速器日益成为支持深度学习等复杂计算任务的关键支撑。张量加速器作为其中的重要组成,凭借其针对张量运算的高效设计,为神经网络模型提供了显著的性能和能效提升。然而,针对各种张量加速器编写高效软件代码一直是技术难点。传统的编译器和优化方法往往局限于通用硬件平台,并且需要大量专家经验和调优时间,对于新兴硬件平台更是缺乏有效支持。面对这些挑战,加州大学伯克利分校SLICE实验室的研究团队提出了Autocomp,一个基于大型语言模型(LLM)的自动代码优化系统,为张量加速器的编程和性能提升带来了革命性的突破。Autocomp并非简单地依赖零样本推理,而是通过将优化过程拆解为有序的规划与实现两个阶段,结合硬件反馈机制和多样化策略,智能搜索出高效的代码调度方案。

张量加速器通常支持固定大小的矩阵乘法等核心操作,且通过专门设计的内部存储结构(如scratchpad和累加器)来管理高速数据流。在此背景下,仅靠简单的循环重排或算术优化难以实现最佳性能。实际上,为了最大化硬件利用率,软件层面需要精细地管理数据搬运、指令调度及算力和带宽的协调,诸如软件流水线技术和双缓冲机制等复杂变换尤为关键。Autocomp的核心优势在于其结合了领域专属知识库和硬件性能反馈,使用预训练LLM通过提示工程灵活生成潜在的优化计划,并对每个计划进行代码实现。通过迭代的beam search搜索框架,Autocomp在保证代码正确性的同时,反复挑选性能最佳的候选代码进行进一步优化。这一策略使得产生的代码在多种矩阵乘法大小和形状的测试中表现优异,性能甚至超过了专家精心调整的手工代码。

除了性能提升,Autocomp生成的调度策略还蕴含着丰富的优化思路,能够迁移应用于相似任务,大幅减少后续优化的搜索空间和计算代价。面对有限的训练数据和多变的硬件架构,传统基于数据驱动的深度学习优化方法难以奏效。Autocomp通过引入优化菜单的dropout机制和LLM集成,提高了方案探索的多样性和鲁棒性。这种设计不仅防止模型陷入单一优化路径,也利于发现更具创新性的调度方案。同时,Autocomp可通过调整提示内容快速适配不同硬件指令集和编程模型,展现出极大的灵活性。Autocomp团队以开源硬件项目Gemmini为试验平台,验证了系统在真实张量加速器上的表现。

Gemmini具备高度可定制性和周期精确仿真能力,是评估底层系统性能的理想载体。对比基线包括Gemmini自带的软件库、未优化的DSL代码以及专家手写优化的Exo代码,Autocomp生成的代码普遍速度快数倍,且能稳定达到硬件设计利用率的85%以上,表现接近理论极限。这其中的秘诀在于Autocomp出色地利用了诸如软件流水线、循环切分和双缓冲的协同优化,有效重叠了计算与数据传输过程,减轻了内存带宽瓶颈。面对高昂的调用大型语言模型和硬件仿真资源成本,Autocomp也实现了方案复用策略。通过复用过去成功生成的调度计划,系统在针对新但类似尺寸的矩阵乘法任务时,能够快速收敛至高性能代码。这类似于传统BLAS库的手工调优经验积累和迁移,显著提升了采样效率和实际应用的经济性。

从更广泛的视角来看,Autocomp的成功揭示了LLM在低资源、专业领域代码生成里的巨大潜力。它表明,单纯依赖零样本生成难以满足复杂硬件编程需求,分阶段提示设计、专家知识嵌入及多样性探索是解决难题的关键路径。此外,通过硬件实际性能数据闭环反馈,优化过程不仅注重功能正确,更实现了性能的持续进化。这为未来张量加速器及其他专用加速硬件的软件开发提供了示范,降低了开发门槛,缩短了上市周期,更推动了AI技术在工业界和科研领域的深度融合。展望未来,Autocomp的框架也极具扩展性。可以想象,将更多维度的硬件指标引入反馈机制,结合更先进的多模型集成以及增量学习策略,将进一步提升代码优化的智能化水平。

同时,结合自动化验证和硬件内测工具,Autocomp有望成为定义下一代异构计算平台软件栈的重要基石。总的来说,Autocomp展示了LLM驱动的代码优化如何突破传统方法瓶颈,实现在低资源张量加速器上的高效自动调优。随着张量计算需求持续激增,这一技术路线无疑将在推动AI硬件生态繁荣与软件智能化发展中发挥核心作用。未来持续优化和开放合作,将助推包括深度学习、图形处理及科学计算等多领域高性能计算变革,开启智能硬件的新篇章。