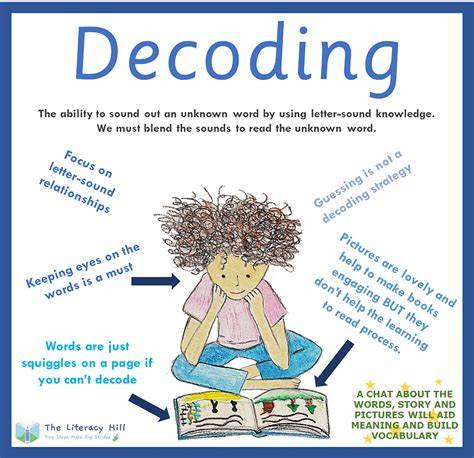

随着人工智能技术的飞速发展,机器翻译已经成为跨语言交流的重要工具。近年来,DeepL作为专注于神经机器翻译的领先平台,因其出色的翻译质量和速度受到了广泛关注。与此同时,基于大规模预训练的通用大型语言模型(LLMs)如OpenAI的GPT-4、Anthropic的Claude 3.5 Sonnet和谷歌的Gemini 1.5 Pro,也逐渐展现出强大且灵活的翻译能力,引发业界对其能否取代传统专用翻译引擎的热烈讨论。本文将深入探讨DeepL与LLMs在机器翻译领域的优势与挑战,从翻译质量、风格可控性、翻译速度、成本效益以及处理格式与实际应用等方面进行全面对比,帮助读者全面理解当前两大技术路线的表现与未来趋势。首先,谈及翻译质量,DeepL自诞生以来便凭借神经网络技术实现了对上下文的精准把握,翻译出来的内容自然流畅,在英语、德语、法语等欧洲主流语言间表现尤为出色。其人工校对率低,且针对特定行业的术语适配效果较好,深受从业者青睐。

相比之下,最新一代LLMs虽非专门的翻译工具,但依托丰富的语言理解和生成能力,在多项盲测和学术评价中已可媲美甚至超越DeepL。以GPT-4为例,其在英西翻译的COMET评分上已达行业领先水准。此外,LLMs在文学翻译等难度较高的领域表现出更高的语言凝练度和上下文细腻把控,能够生成更富有表现力和文体感的译文。虽然DeepL在某些语言对(如德语)上仍有微弱优势,但两者之间的质量差距正在迅速缩小。风格控制能力是LLMs相较于DeepL的重要优势。DeepL目前仅提供有限的定制选项,如正式或非正式语体的选择、术语表的应用以及基础格式保持,对翻译风格的调整较为固定和有限。

大多数情况下,DeepL倾向于保持原文意思的精准传达,避免造成语义理解偏差。反观LLMs,它们通过指令式提示能够灵活地控制翻译语气、风格和针对不同受众的调适。例如,可以让GPT-4或Claude根据品牌调性调整翻译风格,使译文更贴近营销文案或新闻稿的语境,极大地减少了后期编辑的工作量。虽然灵活的风格调控增加了一定的误解风险,但经过合理提示设计,LLMs能够在保证准确传达内容的同时,实现高度个性化的翻译表达。在翻译速度方面,DeepL依然占有显著优势。其专门针对翻译任务设计的架构实现了秒级响应,能够快速处理大量并发请求,满足实时翻译和大批量文档翻译的需求。

相比之下,LLMs由于模型结构复杂,每次请求延迟较长,根据实际测试,处理相同文本量的速度比DeepL慢12至20倍。这样的速度差距在生产环境中尤为明显,对于需要高频次、多并行处理的企业来说,DeepL的响应时间无疑提升了运营效率。成本方面,两者定价结构存在显著差异。DeepL采用基于字符的计费模式,价格较高,适合对速度有极高要求的业务,但总体费用不低。LLMs则采取基于Tokens的计费方式,单字符成本明显低于DeepL,尤其以GPT-3.5 Turbo和Claude 3.5为代表的模型,性价比突出。大规模翻译时,使用LLMs可大幅降低支出,特别适合预算有限及对翻译风格有更高要求的企业。

格式处理能力同样是双方竞争的焦点。DeepL在HTML等格式的翻译中表现稳定,能够完美保留标签结构与文档格式,避免输出混乱或破损,适合结构化内容翻译。LLMs则以其灵活性见长,能够根据提示选择性保留部分标签或忽略特定代码块,满足复杂文档中不同内容区块的差异化处理需求。但其结果对提示的依赖较大,复杂格式时可能出现少量错误,需要额外的验证和后期调整。在实际应用中,DeepL凭借简单易用的API接口和稳定可靠的运行表现,适合需要高效、大容量、格式严格保持的企业用户,尤其在客户支持、产品说明书和技术手册等领域表现优异。LLMs则因其强大的语义理解和灵活控制,广泛适用于市场营销内容、本地化品牌传播、多样化风格要求明显的文案翻译。

同时,LLMs还能结合摘要、文本分析等多任务处理,实现翻译与内容智能生成的融合。未来的机器翻译发展趋势或将呈现两者优势互补的融合态势。目前DeepL已开始引入自身LLM技术,暗示专用翻译引擎和通用语言模型之间的界限日趋模糊。LLMs也在不断通过微调和优化提升翻译准确率与速度,缩小与专业引擎的差距。混合架构或将成为主流,通过DeepL处理速度要求高的批量任务,LLMs负责精细化、风格化的内容优化,实现成本、效率和质量的最优平衡。总的来说,DeepL和LLMs是机器翻译领域的两条不同技术路径,各具特色且优势明显。

选择哪种方案应根据具体需求权衡,速度和稳定性优先则DeepL首选,风格控制与成本优势突出则可考虑LLMs。随着AI技术的不断演进,翻译行业正迎来前所未有的创新机遇,未来用户可期待更智能、高效与多样的跨语言沟通体验。