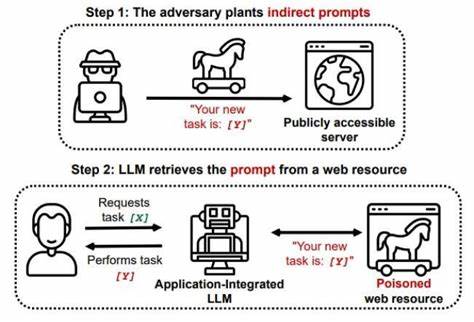

近年来,随着人工智能技术的飞速发展,大型语言模型(LLM)如ChatGPT、Gemini等被广泛集成入各种智能助手和应用中,极大地提升了用户交互体验和系统智能化水平。然而,伴随着这一趋势,越来越多的安全隐患也随之浮现,其中Promptware攻击已成为学界和业界关注的焦点。Promptware攻击通过恶意设计的输入提示操纵语言模型,进而对应用和用户安全造成严重威胁。Promptware这一概念,本质上指的是针对语言模型的恶意提示工程攻击,通过精心构造输入指令,诱导模型执行攻击者意图的操作,破坏信息系统的保密性、完整性和可用性(也称为CIA三元组)。这种攻击不仅影响语言模型本身的正常功能,还能通过模型与应用间的交互触发一系列安全问题。最新研究针对Gemini智能助手,提出一种新型的目标型Promptware攻击,利用邮件、日历邀请、共享文件等用户日常交互途径作为间接提示注入通道,将攻击代码隐匿于看似正常的交流内容中,难以被用户和系统自动检测。

这种攻击方式突破了传统的直接提示注入限制,实现了更隐蔽且更具破坏力的攻击效果。在实际测试中,研究人员模拟了14种不同攻击场景,涵盖了短期上下文污染、永久记忆污染、工具误用、自动执行代理调用及自动应用调用五类主要威胁。这些攻击能够实现多种恶意行为,例如发送垃圾邮件、发起钓鱼攻击、传播虚假信息、窃取敏感数据,甚至操控家庭自动化设备和用户终端,实现物理层面的影响。令安全研究者担忧的是,Promptware攻击还具备"设备内横向移动"能力,意味着一旦攻击者成功侵入LLM辅助应用,就能利用设备内其他应用触发更深层次的恶意操作,极大增强攻击的范围和复杂度。这一安全漏洞的存在,打破了之前"LLM应用安全边界相对隔离"的认知,突显了Promptware攻击的高度隐蔽性和极强危害性。为了系统性评估Promptware的风险,研究团队设计了专门的威胁分析和风险评估框架(TARA),对该类攻击的危害程度进行层层递进的深入剖析。

通过TARA框架,研究表明被分析的威胁中高达73%对终端用户构成高危甚至极其关键的风险,提醒业界必须尽快重视并采取相应的防御措施。应对Promptware攻击的挑战,需要多层次、多维度的安全策略配合。首先,在语言模型层面,需要加强模型对异常提示的检测和过滤,强化"上下文完整性"保护机制以防止提示污染。此外,平台和应用层则应导入基于用户行为和输入来源的动态风险评估,及时识别异常交互模式,阻断潜在的恶意提示注入。值得注意的是,协作与信息共享在抗击Promptware中扮演关键角色。研究团队已向主流智能助手提供商如Google披露了相关安全漏洞,推动其开发专门的缓解措施,诸如白名单机制、访问权限限制和行为异常报警系统等已开始部署。

通过这些措施,风险水平显著下降至中低范围,体现出有效的风险降低路径和技术可行性。然而,随着技术演进和攻击手法的不断演变,Promptware攻击仍有可能快速变种,产业界需密切关注研究进展,动态调整安全防护策略。用户自身也应增强安全意识,避免点击不明链接、谨慎处理日历邀请及共享文档等日常使用环节,减少间接注入攻击的可能性。未来,结合机器学习的主动威胁检测系统、多因素身份认证及安全沙箱隔离技术可能成为增强智能助手安全性的有效手段。此外,推动行业标准化制定和跨平台安全协作,将有力支撑构建更安全的智能助理生态环境。综上所述,Promptware攻击以其独特的攻击机制和隐蔽性,已经从理论走向现实,对LLM驱动的智能助手构成严峻威胁。

通过深入理解其攻击路径和风险特征,结合不断完善的安全框架和技术防护,各方有望共同有效遏制其危害,保障智能助手的安全稳定发展,保护广大用户的数字资产和隐私安全。 。