近年来,随着社交媒体的迅猛发展,巨头企业不断优化其内容抓取技术,以提升内容分发效率和用户体验。其中,Facebook的爬虫技术尤为引人注目。所谓Facebook爬虫,是指Facebook为了获取网页内容而设计的自动化程序,它不断扫描互联网,收集发布在各个平台上的信息。近期,有大量报告指出,这一爬虫程序正以惊人的频率"敲击"着全球互联网,形成了显著的流量峰值,给网站服务器带来巨大压力。Facebook爬虫的工作机制主要是通过发起大量请求,访问网站上的公共内容,以获取最新的新闻、文章、图片和视频链接,随后将这些数据整合到Facebook平台上,供用户更便捷地浏览和分享。这种数据收集方式使得Facebook能够实时更新动态资讯,保持信息的新鲜度和互动性,同时也为广告投放和个性化推荐提供强大支持。

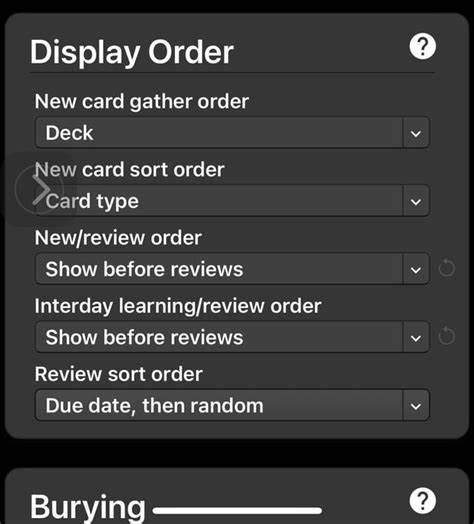

然而,随着爬虫访问量的激增,许多网站不得不面对服务器响应缓慢甚至崩溃的风险,尤其是那些资源有限的小型网站。网站管理员开始意识到,理解并优化针对Facebook爬虫访问的策略成为当务之急。这其中,合理设置robots.txt文件限制无效或过度频繁的爬虫访问成为常见做法。除此之外,网站也可以通过调整服务器配置、增加缓存机制以及部署内容分发网络(CDN)来缓解爬虫访问带来的压力。值得注意的是,Facebook爬虫频繁访问网络内容不仅带来了挑战,同时也促进了互联网的活跃度升级。爬虫带来的频繁访问促使网站不断更新内容,提高网站设计的安全性和稳定性。

同时,这种高速的数据流动推动了SEO优化技术的演进,促使网站更加注重内容的原创性和结构化,从而更容易被搜索引擎和社交平台识别与收录。为了更好地应对爬虫的影响,内容创作者和站长们应关注爬虫的行为特点,分析访问日志和数据流量变化,从中获得优化方向。例如,识别高访问频率的时间段,合理安排服务器维护计划,以及调整内容发布时间,使网站资源能够得到最大化利用。此外,链接结构的科学设计和网页加载速度的优化也是提升网站整体抗压能力的关键所在。另一个重要层面是用户体验的提升。随着爬虫技术的不断进步和应用场景的拓展,用户对社交平台上内容的获取将更加快捷和精准。

Facebook通过爬虫获取并整合的信息能够在用户动态流中实时呈现,从而帮助用户第一时间了解热点事件、朋友动态和相关话题。这不仅增加了平台的粘性,也为内容生产者带来了更多流量和曝光机会。尽管Facebook爬虫带来了众多好处,但仍需警惕潜在的隐私和版权问题。大量自动化抓取可能涉及未经授权的数据收集,这在某些国家和地区面临法律法规的限制。因此,Facebook和网站运营者都需加强合规意识,确保内容爬取和分发过程符合当地的相关规定,以避免因违规操作引发法律纠纷。技术层面上,Facebook爬虫还在不断进化。

随着人工智能和机器学习技术的融合,爬虫不仅能识别更多类型的内容,还能更智能地筛选和分类信息。这使得信息检索更加高效,同时也加大了对服务器稳定性和内容安全性的挑战。因此,企业和网站除了技术性防护之外,更应关注内容质量和合法合规性的提升。总结来看,Facebook爬虫在互联网生态中扮演着不可或缺的角色。它以强大的访问能力和智能化的数据处理手段,不断推动着信息传播的广度和深度。与此同时,爬虫的频繁访问对网络结构、服务器承载力和内容管理提出了更高要求。

通过科学合理的优化和管理,网站和内容制作者能够从中获益,实现流量和曝光的双重提升。未来,随着技术的进步和规则的完善,Facebook爬虫的应用将更加规范和高效,助力构建更加开放、互联互通的信息共享环境。 。