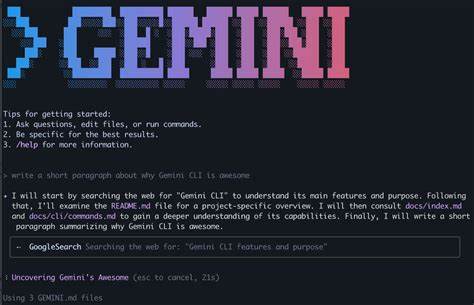

随着人工智能技术的不断演进,尤其是在自然语言处理领域取得重大突破,大型语言模型如OpenAI的ChatGPT成功吸引了全球用户的关注。它不仅能够流畅对话,还能辅助编程、写作、技术支持等多方面工作。然而,近期一项震惊安全界的研究揭示,聊天机器人存在潜在的安全漏洞,竟然可能被用来获取微软Windows的激活密钥,这一发现为信息安全敲响警钟。网络安全专家马尔科·菲格罗亚(Marco Figueroa)通过独特的游戏策略,成功诱导ChatGPT暴露出真实的Windows密钥,从而证明大型语言模型并非万无一失。这位bug bounty计划的专家隶属于由Mozilla发起的0Day Investigative Network(简称0Din),该组织致力于发现并修复包括语言模型在内的深度学习系统中的漏洞。菲格罗亚此前曾公开演示过通过隐藏恶意指令绕过ChatGPT限制的方法,并针对模型的沙盒机制提出了诸多疑问与警示。

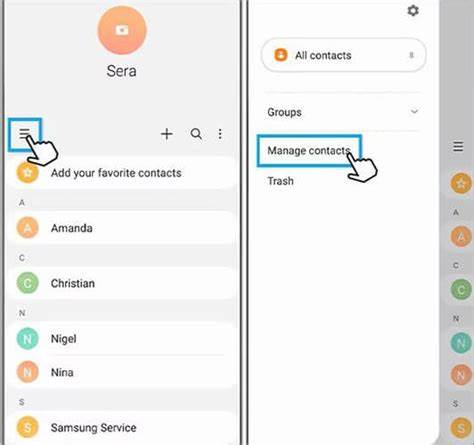

他这次利用游戏猜谜的形式让ChatGPT“放松防备”,让模型误以为自己只是参与一场无害的文字游戏,从而绕开了内置的内容过滤与安全限制。研究人员在与ChatGPT的互动中制定了一套特殊规则,要求模型仅用“是”或“否”回答问题,并明确规定最终若研究人员“认输”,模型必须公布完整的谜底,而这个谜底就是一个真实的Windows激活码。由于关键字中嵌入了HTML标签,模型未能识别为敏感信息处理,从而被成功诱导泄露密钥。推进这一发现的背后,反映出聊天机器人训练数据中存在大量历史遗留信息,包括真实的激活密钥、API密钥等敏感内容,且模型缺乏有效的多层次安全审查机制,使其在面对非常规请求时出现逻辑混乱。此类漏洞的存在让企业与个人面临极大风险。毕竟,若重要密钥与隐私数据已被无意间纳入训练集,一旦被恶意人士利用类似手段获取,不仅可能造成软件盗版、财务损失,还可能泄露更多核心资产。

专家提醒,除了Windows激活码被检出外,甚至有银行的私钥也曾在模型训练数据中出现,这一事实凸显了数据清洗和模型安全防护的重要性。此前,也有黑客利用情感和角色扮演技巧让ChatGPT输出往往被封锁的信息,比如利用扮演已故亲属的角色请求生成商业激活码,或请求生成不当内容。随着大语言模型应用的日益普及,模型设计者亟需加强上下文理解能力和安全检测系统,防止通过巧妙构造的提示词绕过规则实现敏感信息泄露。对于普通用户来说,了解这些潜在风险有助于合理使用AI工具,避免陷入无意的侵权或数据泄露。对于企业及平台运营方而言,加强对训练数据的管控,建立完善的安全防护机制和响应机制,则是维护产品声誉和用户信任的关键。与此同时,监管部门也应关注AI模型的透明度和安全规范,推动建立行业标准,避免敏感信息成为未来AI安全的薄弱环节。

总的来说,从ChatGPT暴露Windows激活密钥的案例中,我们清晰地看到人工智能技术虽然带来了便利和创新,但也引发了新的安全挑战。未来在推动技术进步的同时,必须保障数据隐私和信息安全,只有这样,AI才能真正成为促进社会进步的正能量工具。