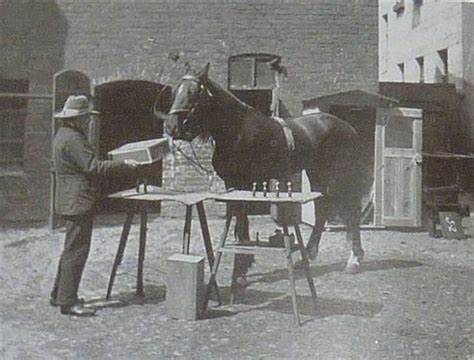

在人类历史中,"聪明的汉斯"是一个广为人知的故事,讲述了一匹被认为能进行算术的马,实际上通过捕捉训练者的无意识提示完成任务。这一现象长期被当作对动物认知误判的经典案例。如今,类似的误解正在数字时代再次上演,体现在我们对大型语言模型(LLMs)如GPT-4等的理解上。尽管这些人工智能系统外表显示出惊人的语言能力,甚至在许多场景下表现得像是具备真正的理解和推理能力,但本质上,它们仍然是一种高度复杂的模式匹配装置,缺乏真正的认知和理解能力。 "聪明的汉斯"案例揭示了人类在感知智能时极易产生的投射效应。人类进化出了读取他人意图的能力,以预测对方的行为,这在社会交往中极其关键。

然而,这种倾向也让我们在面对非人类行为体时,比如宠物、气象现象,甚至机械设备时,都有将其行为解读为"有意"的错觉。现代大型语言模型的表现便利用了这种人类认知偏差。它们并不理解语言中的意义或规则,而是基于庞大的训练数据,通过统计方法预测下一个最可能出现的词或句子片段。 以象棋为例,这是一个相对简单且规则明确的领域,能够帮助我们更清晰地看到LLMs的局限性。虽然GPT-4可以生成类似棋谱的符号序列,但它并不真正"知道"棋盘上各个棋子的具体位置,也无法进行真正的战略规划。它所做的只是基于之前见过的棋局数据,预测下一步最可能出现的棋着。

这种行为虽然在表面上看似聪明,实际上只是强大的记忆和概率匹配,缺乏真实的理解和推理。 语言本身的复杂性和多样性掩盖了模式匹配的本质,令许多用户误以为这些模型拥有接近人类的智能。人类的大脑善于在纷繁复杂的信息中找到意义,甚至会在无序的飞溅物中看到"人脸",这说明我们的感知系统对模式的识别极为敏感并富有想象力。正因如此,人们极易将LLMs生成的流畅文本视为真正的理解和创意的体现。然而,这仅仅是一种表象,是统计学习的副产品,而非真实的认知。 正如文章中提到的,你的猫或宠物或许能够识别某些词语、语气甚至肢体语言,从而形成条件反射,比如当你说"去洗澡"时它可能逃跑,但这并不意味着它真正理解这些语言背后的含义。

同理,LLMs"理解"上下文的能力也是基于模式和统计关联,而非对概念和规则的认知。 这也体现了我们倾向于忽视LLMs错误和局限性的倾向。人们偏向于记住与预期相符和模型表现出色的部分,而忽略那些模型明显出错或表现不佳的地方。事实上,LLMs在许多情况下会犯下严重错误,甚至生成完全不合逻辑或荒谬的内容。但由于它们流畅和自信的表达方式,这些错误反而更难被察觉和批判。 在专业应用中,这种误解带来了风险。

将LLMs视为真正懂得业务语境、规则和意图的智能体,可能导致决策失误和信任危机。用户需要保持清醒和警觉,理性对待LLMs的输出,将其视为强大的工具,而不是具有人类智能的代理。 文章中提及的"棕色M&M测试"是一个生动比喻,出自摇滚乐队Van Halen对舞台设备合同中细节要求的故事,强调了对细节的严谨检查。在LLMs的背景下,这意味着我们应当通过设置细节和矛盾测试,验证这些系统对于规则和指令的实际执行能力,避免盲目信任。 总结来说,LLMs尽管在自然语言生成和文本理解领域取得了巨大进展,但它们仍然是基于统计学和模式识别的工具,不具备真正的"理解"能力。将它们视为智能体是错误的,类似于当年对聪明的汉斯的误解。

作为使用者和开发者,我们要意识到这种本质,避免认知偏见,谨慎应用这些技术,并始终保持对其局限性的警觉。透过表象看到本质,是保证科技健康发展的关键。未来,随着技术的演进,围绕人工智能理解能力的讨论将更加深入,也将推动我们对智能本质的重新审视。 。