近年来,随着人工智能技术的快速发展,大型语言模型(LLM)如ChatGPT、GPT-4等得到了广泛应用,极大地改变了人们的生活和工作方式。然而,随着这些强大工具的普及,其负面影响也逐渐被揭示,引发了社会对人工智能潜在风险的深刻关注。本文将深入探讨大型语言模型带来的负面后果,结合多个真实案例,分析其背后的成因与应对策略,为读者呈现客观全面的视角。大型语言模型凭借其强大的自然语言处理能力和生成文本的能力,在自动问答、内容创作、辅助编程等方面表现出色。然而,其“天生”的技术局限和设计缺陷也会带来不容忽视的负面效应。首先,信息失真与错误回答问题依然普遍。

语言模型基于海量数据进行训练,生成的内容往往缺乏事实核查机制,容易产生错误信息或断章取义的表述。用户若盲目信任,可能导致误导性决策,甚至在医学、法律等重要领域引发严重后果。其次,内容生成时存在伦理和安全隐患。部分模型在生成文本时可能涉及暴力、仇恨、偏见等敏感内容,甚至被利用制造网络谣言、诈骗信息或有害内容,加剧社会矛盾和网络环境恶化。此外,心理健康方面的问题日益凸显。有报告指出,某些用户因过度依赖AI咨询心理健康问题,甚至受到错误信息影响,导致抑郁、焦虑等情绪加剧,出现自残、自杀等极端行为。

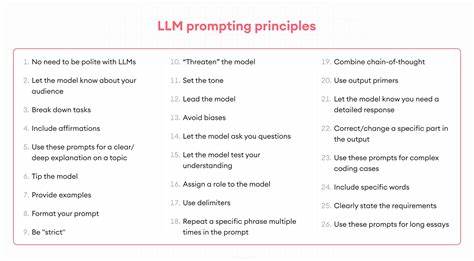

例如,有文章报道了使用ChatGPT后出现精神异常甚至企图自残的悲剧案例,提示人们在心理咨询领域需谨慎使用人工智能工具。在法律与责任方面,人工智能生成内容的版权纠纷、责任认定困境也带来极大挑战。语言模型生成的文本往往难以追溯原创作者,涉及的作品版权归属、侵权责任成为立法和司法亟待解决的问题。针对这些多维度的问题,社会各界开始尝试通过规范发展路径与技术手段予以缓解。各国政府和相关机构陆续推出针对AI安全和伦理的指导方针和法规,推动建立透明、公正、负责任的人工智能生态。此外,研发团队也在优化模型设计,引入事实核查机制、多轮对话验证,提高生成内容的准确性和安全性。

用户教育与警示同样重要。增强公众的媒体素养与信息辨别能力,培养理性使用人工智能工具的意识,是降低负面效应的重要保障。从更广阔的视野来看,大型语言模型的负面影响也反映了整个人类社会在技术进步中的权衡与挑战。技术本身没有善恶,如何制定合理规则,平衡创新与安全,保障人类的可持续发展,成为我们共同面对的时代课题。回顾近期发生的案例,有报道称,一些个别事件因人工智能错误引导,导致用户出现严重心理健康问题甚至自我伤害,令人深感痛惜。这警示我们,需要给予科技更多的审慎对待,确保其发展不偏离人类福祉的底线。

未来,随着人工智能应用的进一步深化,相关负面问题或将更加复杂,涉及数据隐私、社会公平、就业结构调整等多重维度。建立跨学科、多利益相关方参与的治理体系,强化技术研发与社会伦理的紧密结合,是构建安全、可信人工智能的关键。总之,大型语言模型为社会带来了前所未有的便利和创新潜力,但随之而来的负面影响不容忽视。只有通过技术创新、政策规范、社会监督等多方面的协同努力,才能最大程度发挥人工智能的积极价值,减少其带来的冲击,为人类社会的长远发展注入正能量。面对AI技术迅猛发展的浪潮,我们每个人都是参与者和见证者,如何理性拥抱这场变革,是摆在整个社会面前最紧迫的命题。