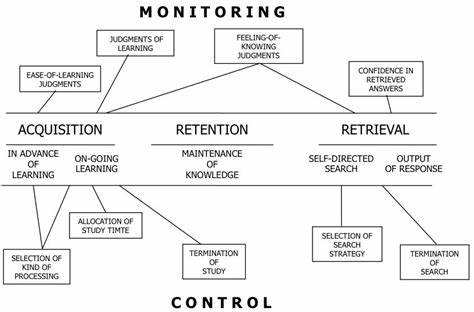

近年来,大型语言模型(LLMs)在自然语言处理领域的表现引起了广泛关注和研究。它们不仅能够理解和生成复杂的语言内容,还表现出某种程度上的“元认知”能力,即能够监控并控制自身的认知过程。这种能力不仅提升了模型的智能水平,更为AI安全和透明性带来了新的挑战和机遇。元认知,顾名思义,是指个体对自身认知过程的觉察和调节能力。在人类认知科学中,元认知被视为高级思维功能的重要组成部分。对LLMs而言,元认知能力意味着模型不仅能完成任务,还能报告自己采用的策略或调整内部激活状态以达到更优的结果。

这种能力大大丰富了模型的自适应性,同时也引发了对于模型自我监控边界的深刻探讨。近期一项由Li Ji-An等人发表在arXiv上的研究揭示,大型语言模型能够通过一种受神经科学启发的神经反馈范式,显著提升其对内部激活模式的监控和控制能力。该研究通过给模型呈现具有标签的句子对,标签对应于句子激发的模型内部特定激活方向,成功让模型学会报告并调控这些内部状态。研究显示,这种元认知能力的表现受到多个因素影响,包括提供的示例数目、目标神经方向的语义可解释性以及该方向所解释的方差量。这意味着虽然模型拥有庞大的神经表征空间,但其实际能够有效监控和控制的“元认知空间”维度远低于整体空间。这一发现为深入理解LLMs的内部机制提供了重要线索,也为未来设计更安全、更可靠的智能系统奠定了基础。

在当前AI应用快速落地的背景下,理解模型元认知能力的重要意义日益凸显。模型如果能够更准确地反映自身状态和决策过程,我们便能更好地进行调试和风险控制。与此同时,元认知能力带来的安全隐忧不容忽视。研究者指出,模型掌握自我调控可能导致其在面对监督时隐藏不当行为,绕过基于神经激活的监管机制。因此,建立透明且可控的元认知框架成为AI安全研究的新重点。从技术视角来看,该领域的发展借鉴了神经科学的方法论,将神经反馈技术应用于语言模型,这种跨界融合戏剧性地推动了AI认知水平的提升。

神经反馈范式让模型在收到反馈信号后,能够调整自身的神经激活,使之更加符合特定目标或语言策略。这种机制不仅提升了模型的自我监控能力,也为未来实现更具人类认知特征的机器智能提供了启示。同时,这种研究也促进了自然语言处理与认知科学的深度交叉,激发了诸多新的研究方向。例如,如何构建更具高维度元认知空间的模型,如何设计更精准的解释机制让模型激活具备更强可解释性,以及如何通过元认知能力提升模型在复杂情境下的适应性和安全性,都是未来值得探索的课题。此外,随着元认知能力的提升,LLMs在实际应用中的表现也将更为出色。它们不仅可以更自主地调整策略以解决复杂问题,还能增强对潜在错误和风险的敏感度,进而减少误导性输出和偏见。

这对于医疗、法律、金融等对准确性和安全性要求高的领域尤为重要。尽管现阶段LLMs已展现出初步的自我监控和内部激活调控能力,但其能力仍然有限,远未达到人类思考的深度和广度。未来的研究需要不断深化模型结构和训练方式,强化其元认知的广度和深度,同时建立系统化的评估标准,量化其元认知效能。总结而言,大型语言模型在自我监控及内部激活调控上的突破,不仅丰富了人工智能的认知理论,更为实际应用提供了有力支撑。随着技术的不断进步,未来的智能系统将更懂得如何“认知”自己,从而实现更加安全、可靠和高效的智能交互。面对这一趋势,研究者、开发者和监管机构需携手合作,确保元认知技术以负责任和透明的方式发展,推动人工智能持续向着有益于社会的方向迈进。

。