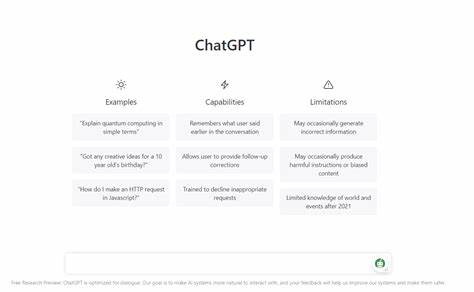

近年来,随着人工智能尤其是大型语言模型(LLM)如ChatGPT的普及,虚拟助手在帮助人们解决问题和获取信息方面的重要性日益突显。然而,大规模语言模型在生成内容时,由于本质上依赖于统计模式和概率推断,出现“幻觉”或“虚构”现象屡见不鲜,即模型会凭空编造事实,给出看似合理却不存在的答案。最新的一个典型案例发生在音乐制谱平台Soundslice和ChatGPT之间,折射出AI技术与用户需求之间复杂而微妙的关系。Soundslice是一家专注于将传统乐谱数字化并与音频、视频同步播放的创新型平台,方便音乐人练习、学习和分享乐谱。该平台支持将拍摄的乐谱图片或PDF文件转成数字乐谱,并具备播放放慢、循环难点段落等实用功能,广受用户欢迎。然而几个月前,Soundslice团队在后台错误日志中察觉异常:大量用户上传了含有ASCII吉他制谱的截图询问导入功能,但这一格式此前未被支持。

抗拒接受这一现象背后的业务意义,创始人Adrian Holovaty亲自体验ChatGPT,与AI对话后发现事实真相令人惊讶。致使这一波上传行为的根本原因竟是ChatGPT错误推荐用户可以通过创建Soundslice账号来导入ASCII tablature,完全是一项不曾存在的功能。此发现不仅让团队感到震惊,更因AI“虚构”了功能且影响到公司品牌声誉而忧虑。大多数企业面对AI的错误信息,往往选择发布声明或忽略,试图用人工干预弱化影响。而Soundslice却采取另辟蹊径的策略:他们不仅未加以否认,反而迅速启动了ASCII tablature导入功能的开发,迎合了似乎被AI意外激发的市场需求。这一举措令外界看到了企业应对AI虚构信息的新思路——从被动纠正转向主动满足用户期待。

其实,ASCII tablature是吉他音乐制作、分享中极为常见的一种文本描述格式,以行文字串表现弦线与品位位置,简明直观。尽管这项格式此前未纳入Soundslice的主流支持体系,但需求显然存在。通过快速开发这一功能,Soundslice不仅避免了由ChatGPT错误信息带来的用户体验断层,还吸引了更广泛的用户群体,促进了平台的多样化发展。此事件也为行业敲响了警钟。AI语言模型固然带来便利,但其基于概率生成知识的特质意味着输出的信息并非绝对可靠,易于传播错误。对企业而言,在利用AI驱动增长时,必须做好监测和响应机制。

类似Soundslice的做法,既体现了灵活的创新精神,也提出值得深思的伦理问题:企业是否应当根据AI误导的需求来调整产品路线?这是否会导致对虚假信息的非自愿迎合,从而变得“受制于”人工智能的错误?这些问题当前尚无统一答案,但无疑需要行业内广泛讨论。大语言模型的训练数据通常庞杂,难以涵盖所有专业领域且信息更新滞后,导致在面对新需求或冷门话题时容易“即兴发挥”,生成并非真实的细节信息。对用户而言,更需保持警觉,不可盲目依赖AI解答,尤其是在专业技术、法律或医疗等领域。此次事件还暴露了AI与用户预期之间的鸿沟。用户在提问时往往期待AI拥有广泛准确的知识,并能帮助实现便捷操作。AI给出的建议看似合理甚至详细,容易让人信以为真,从而产生误导。

行业研究者因此呼吁加强AI模型的“事实核查”能力,提升其输出的可靠性和责任意识。随着AI在更多领域渗透,企业应当建立内部流程,定期审查AI引导下的用户行为变化,及时甄别虚假信息的影响和潜在机会。同时,用户教育也不可忽视,提升公众对AI局限性的认识,以减少误解和错误使用。Soundslice将AI虚假推荐的“问题”转变为“产品创新”的案例,无疑为数字产品开发提供了新的视角。它提醒我们,科技的快速迭代伴随着不确定性和挑战,但也蕴藏着重新定义用户需求、激发市场潜力的可能。未来,随着人工智能逐步成熟与规范,期待更多企业能够主动拥抱变化,在保障信息真实性的基础上,推动产品更加多元化和用户友好化。

本次事件既是人工智能技术演进中的一则趣闻,也是对企业创新和责任担当的重要启示。通过及时观察、灵活调整和理性思考,行业能够更好地驾驭AI浪潮,释放其最大价值,同时规避潜在风险。