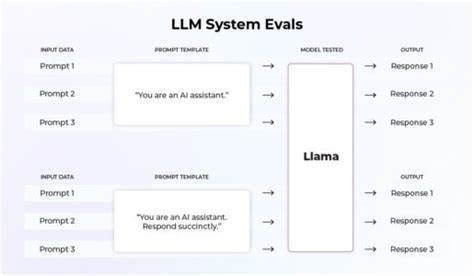

随着人工智能技术的飞速发展,大型语言模型(LLM)在自然语言处理、代码生成、内容创作等领域展现出强大的能力。然而,在实际应用中,如何准确、透明地评测这些模型的表现成为了业界和研究界关注的焦点。Prompt-to-Proof便是在这一背景下应运而生的创新工具,旨在提供一个既能高效测评又能确保结果可信的解决方案。Prompt-to-Proof是一套开源工具,专注于理解LLM的流式生成与采样机制,同时实现"可复现"的小规模评测流程,并以哈希链收据的形式确保数据的不可篡改性。该项目采用Node.js环境构建,支持OpenAI兼容的接口,无论是远程API还是本地服务(如vLLM、llama.cpp等)均能便捷接入,极大地增强了应用灵活性和兼容性。工程师和研究者可以通过简单的命令行操作迅速部署和执行模型的流式评测,从而监控模型的首字节响应时间(TTFT)以及令牌生成速率,为后续优化提供实操数据。

Prompt-to-Proof将生成过程中的关键信息如模型参数、分词器细节、采样配置、输入提示文本等整合进manifest.json文件中,保证每一次评测的环境和条件清晰明了。此外,在结果产出方面,系统自动生成的JSON文件详尽记录了响应时长、输入输出令牌数及具体文本,支持研究人员细致分析和后续复现。为了确保评测结果的可信度,Prompt-to-Proof融入了基于哈希链的收据机制。该机制将不同任务的评测结果以加密哈希相互链接,一旦任何环节被篡改,都会立即破坏链条的完整性,从而实现篡改的实时检测。这对于保障去中心化AI系统的数据诚实性尤其关键,也推动了评测流程的公开透明化。在具体的评测流程中,用户可以运行deterministic(确定性)评测,设定如温度(temp)为零、top_p为一等参数,确保结果稳定重复。

系统支持多轮尝试并统计通过率(pass@1和pass@k),通过对比不同模型的表现,Prompt-to-Proof揭示了如GPT-4o-mini与GPT-4o在任务完成率、响应时间和输出长度方面的微妙差异,为模型选择和调优提供了宝贵依据。Prompt-to-Proof不仅重视评测数据本身,还将流媒体日志作为核心组成部分。流媒体日志让开发者清晰观察TTFT和令牌速率的动态变化,便于发现网络延迟、排队时间或采样策略对生成效率的影响。多维度的数据呈现兼具实用性和科学性,赋能开发者深度挖掘模型性能瓶颈。作为开源项目,Prompt-to-Proof坚持MIT协议,降低了社区参与门槛,促进了工业界与学术界的广泛协作。它具备良好的扩展潜力和适配性,不仅可用于评测现有主流的LLM,也适合未来新兴模型的快速适配和验证。

展望未来,Prompt-to-Proof的理念和技术能够推动AI系统的去中心化信任建设,为构筑公平透明的人工智能生态贡献力量。随着对模型透明性和责任性要求的日益提升,基于哈希链的证明机制将成为评测领域的标配标准。Prompt-to-Proof通过细致的数据采集与链式验证,实现了测评过程的全流程追踪和障碍防护,有助于维护AI评测的客观公正。总之,Prompt-to-Proof不仅是一套实用的工具,更是实现大型语言模型可信评测的重要里程碑。它融合了流式性能监控、精确的代码评测框架和基于加密技术的不可篡改验证,为人工智能产品开发和研究实验提供了坚实的技术支撑。随着更多社区力量的加入和功能的不断迭代,Prompt-to-Proof将在未来的AI评测体系中扮演举足轻重的角色,推动整个产业朝向更加高效、可信和开放的方向发展。

。