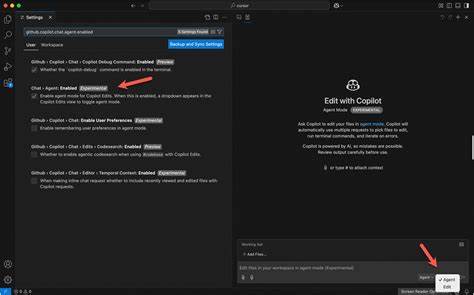

随着人工智能技术的高速发展,IDE中的智能辅助工具如GitHub Copilot变得日益流行,极大地提升了开发者的编程效率。Copilot的Agent模式支持更智能的功能调用和代码理解能力,使得AI在编程中不仅仅是简单的补全工具,而成为可调用多种功能、集成工具链的智能助手。然而,尽管OpenRouter作为一个集成多家领先AI模型的平台,提供了包括OpenAI、Anthropic等多种模型的API,直接在Copilot中启用这些第三方模型的Agent模式却存在障碍。主要问题在于OpenRouter的API无法完整支持Copilot Agent模式所需的函数调用与工具标识,这阻碍了开发者充分利用Claude、GPT-4等先进模型实现复杂功能调用。为此,开源项目copilot-ollama推出了创新的本地代理链解决方案,通过三步代理机制将OpenRouter模型转化为兼容Copilot Ollama集成的格式,在保留功能调用能力的基础上实现无缝适配。项目的核心目标是构建一条本地透明的请求通道,使VSCode的GitHub Copilot能够认为它连接的是一个标准的Ollama服务器,从而解锁Agent模式多模型使用权限。

首先,本地代理链通过oai2ollama组件,将来自Copilot的Ollama API调用转换为OpenAI兼容的请求格式。这一步打通了调用接口,让上层AI请求不因协议差异而阻断。紧接着,proxy链中的LiteLLM组件充当对OpenRouter的请求代理,负责转发经oai2ollama转换的OpenAI格式请求到OpenRouter平台,同时确保请求携带正确的函数调用和工具支持信息,使模型能够完整响应高级Agent模式需求。最终,OpenRouter接受并路由请求至相应的第三方模型,无论是Anthropic的Claude系列,OpenAI的GPT-4 Turbo,还是来自Mistral或Meta LLaMA的开源强大模型,都能具备Agent功能调用的能力。使用该代理方案,无需修改OpenRouter本身的API规范,也无需等待官方支持即可实现极具价值的多模型Agent模式,让开发者享受到模型多样性和功能智能化的双重红利。搭建过程十分简便,开发者只需安装必要依赖包,配置OpenRouter API密钥,克隆并启动代理项目,最后在VSCode插件设置中指定本地Ollama端点即可。

配置文件config.yaml允许用户灵活定义和管理本地广告的模型列表,从而根据不同项目需求轻松启用适合的模型版本。我们还能在配置中添加市面上表现出色的预设模型,比如Claude-3-Sonnet以其在代码生成上的出色表现闻名,亦或选择最新版的GPT-4-Turbo以期获得最佳性能,以及更为轻量快速的开源模型Mixtral和Meta LLaMA,满足不同场景的效率与效果权衡。这一开源项目不仅帮助开发者充分发挥普及度极高的GitHub Copilot智能辅助的潜能,也促进了AI模型的生态互联。它通过巧妙的代理链设计让缺少官方功能调用支持的API也能强力适配新兴的Agent模式,兼顾兼容性与功能完整性。对于技术社区而言,这不仅是一次技术创新,更是一种开放趋势,鼓励开发者自由组合与利用多家AI技术力量,从而建立更智能、更灵活的开发环境。未来,随着项目的活跃发展,可能会出现更多针对不同AI模型或平台的定制代理桥接,进一步丰富Copilot的扩展能力。

技术爱好者和开发团队可以积极参与贡献,帮助完善文档、功能,修复bug,一同推动AI辅助编程生态朝向更加开放和高效的方向演化。总的来说,copilot-ollama项目所提出的三步代理机制解决了OpenRouter API与GitHub Copilot Agent模式间的兼容性难题,为开发者提供了一个强大的工具链,助力其在熟悉的VSCode环境中享受多模型智能辅助带来的生产力飞跃。它简化了复杂功能调用的集成过程,极大地拓展了Copilot的应用范围,是当下智能开发工具领域不容忽视的创新方案。无论是个人开发者还是企业团队,都可借助这种桥接代理轻松开启第三方AI模型Agent模式新篇章,实现更智能、更高效的编程体验。随着AI模型功能不断丰富、工具链日趋完善,这种跨平台跨模型的互联互通方式无疑将成为智能编程未来的发展趋势。