随着人工智能技术的不断发展,大语言模型(LLM)在自然语言处理、智能问答、内容生成等领域展现出强大的能力。然而,大模型的规模庞大、资源消耗高以及复杂的部署配置需求,成为阻碍其广泛应用的重要瓶颈。尤其是在企业或技术极客追求私有化部署、数据安全与性能优化的背景下,如何快速、高效且稳定地将大语言模型从硬件环境配置到生产应用,实现真正的“开箱即用”,成为亟待解决的问题。LLMOne是一款应运而生的企业级开源解决方案,专注于大语言模型的自动化部署与服务平台。从操作系统安装、驱动配置到推理引擎集成,LLMOne为用户提供傻瓜式的快速部署流程,仅需几次点击即可将模型服务上线,极大缩短了传统部署周期,降低了运维门槛。LLMOne支持多种硬件平台,包含主流的NVIDIA GPU、华为Ascend NPU、Apple Silicon及国产芯片,覆盖高性能服务器、台式机及工作站,满足不同规模和场景的需求。

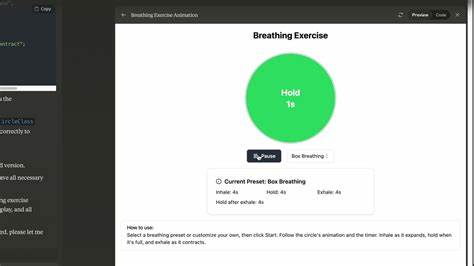

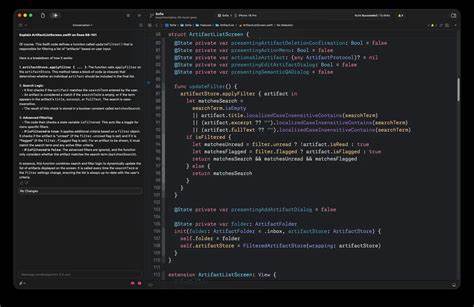

平台集成了vLLM等领先的推理引擎,对硬件资源进行了深度优化,以保障企业级的性能稳定和高可靠性。这种优化不仅提升了模型推理的速度,还有效提升了硬件利用率,为用户节约了大量算力成本。用户体验设计是LLMOne的另一个亮点。简洁直观的操作界面通过引导式配置流程,帮助用户快速设置网络环境及管理接口,如基板管理控制器(BMC)的IP配置、远程启动和系统安装等,降低了部署环境准备工作量。此外,平台内置详尽的部署报告和性能测试工具,让用户实时了解系统运行状态和模型表现,便于问题诊断和运维优化。对于对接多样化应用场景,LLMOne提供灵活的模型管理功能,支持模型切换、版本控制及多模型协同,大幅提升定制化场景的部署效率。

模块化的应用组件设计支持RAG等复杂应用的快速集成,满足企业级别的复杂度需求。同时,LLMOne积极构建开放的应用生态,支持如OpenWebUI、Dify和RAGFlow等开源交互界面及工具的无缝集成。通过“Deploy on LLMOne”功能,应用开发者能够快速将自己的产品标准化地部署在目标硬件上,实现一键交付和更新,极大地促进了整个生态的协同发展。在实际应用中,LLMOne适用于多个典型场景。大语言模型应用开发者和厂商可以利用LLMOne快速将其应用标准化地部署到客户的私有化环境中,提升客户交付速度和服务质量。一体机厂商及系统集成商借助平台的自动化部署流程,大幅缩短产品交付周期,提升产品附加值,实现硬件的真正“开箱即用”。

此外,拥有高性能设备如NVIDIA DGX服务器和Mac Studio的技术极客或企业用户,能够利用LLMOne快速搭建高效、稳定的模型推理服务,节省环境配置时间,专注于业务创新。为保证持续发展,LLMOne团队规划了多项未来路线,包括更完善的SSH模式支持,方便复杂网络环境下远程部署,同时持续优化Apple Silicon平台的支持,提升桌面级设备的运行效率。针对数据存储及向量数据库集成(如openGauss、Milvus),平台将增强对RAG等应用的本地支持能力。未来还计划推出标准化应用模板及开发接口,降低应用集成难度,促进更多优质大语言模型和应用的快速上线。值得一提的是,LLMOne完全开源,采用宽松的木兰宽松许可证(Mulan PSL v2),并兼容Apache 2.0许可证,鼓励社区和企业用户共同参与贡献,通过不断迭代完善功能和性能。整体来看,LLMOne立足于解决传统大语言模型部署周期长、配置复杂、性能不稳定及运维成本高等行业痛点,打造了一个覆盖从底层硬件管理到应用生态集成的全栈自动化部署平台,为企业及开发者实现高效便捷的智能基础设施搭建提供了坚实保障。

它不仅降低了技术门槛,也提升了系统稳定性和性能表现,助力更多组织充分释放大语言模型的业务价值。未来随着更多硬件与软件支持的加入,LLMOne有望成为业界领先的企业级大语言模型自动化部署利器,推动人工智能基础设施的普及与创新。对于企业级用户想要快速构建私有化、大规模、定制化的智能应用,LLMOne的出现提供了一个独具特色且成熟可靠的选项。