随着人工智能和高性能计算的不断发展,GPU成为推动现代计算创新的重要硬件力量。NVIDIA CUDA,作为全球领先的GPU计算平台和编程模型,为开发者和企业提供了强大且灵活的加速计算能力。然而,CUDA软件栈的安装与部署历来因复杂的依赖管理及兼容性问题给开发者带来一定的挑战。近日,NVIDIA宣布CUDA现已通过多家主流操作系统及包管理器实现直接分发,这一举措标志着GPU加速软件部署进入了一个更便捷、高效的新时代。长期以来,开发者在构建和部署基于CUDA的应用时,需要手动下载安装合适版本的CUDA Toolkit,并确保其与系统、驱动程序及相关软件库版本匹配。这个过程不仅耗时且容易出错,更是限制了多样化系统环境中CUDA应用的快速集成。

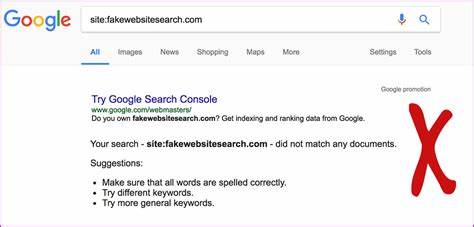

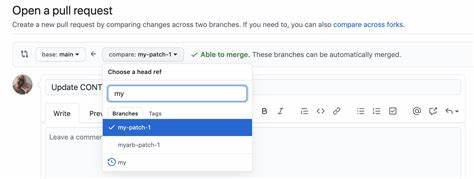

为了解决这一难题,NVIDIA与包括Canonical、CIQ、SUSE和Red Hat等主要操作系统发行厂商紧密合作,同时整合开发环境管理工具Flox及支持Nix包管理器的生态,推动CUDA直接嵌入各大平台的软件包源。通过这一合作,各大操作系统提供商可以将CUDA软件无缝地整合进它们的官方仓库,自动处理安装依赖和版本兼容性问题,为开发者带来前所未有的安装便利。新发布的CUDA包会严格遵循NVIDIA官方的命名规则,确保用户在使用过程中能够准确识别和匹配对应版本,减少混淆和潜在的使用错误。此外,各平台还承诺会在NVIDIA官方CUDA更新后及时发布新版本,有效缩短版本同步时间,降低开发者和企业的质量保障(QA)负担。这一举措不仅提升了软件生态的稳定性,也使新特性和性能改进能够被更快速地部署到用户端。更值得一提的是,CUDA将继续保持免费开源的状态,任何人都可以免费获取和使用CUDA的软件组件。

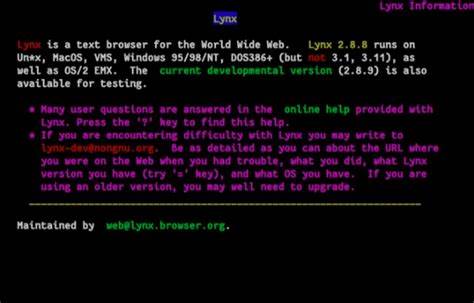

虽然部分发行平台可能会对其整体软件包做出商业收费,但NVIDIA强调CUDA本身不会被专门收费,这保障了广泛的开发者和科研机构能够无障碍地获取GPU加速计算资源。支持服务同样得到强化。除了各平台自身提供的技术支持外,开发者还可以持续依赖NVIDIA官方的开发者论坛与技术文档,享受多层次的支持体系。在具体应用场景上,这一新模式尤其惠及依赖GPU加速的重要人工智能框架和图像处理库,例如PyTorch和OpenCV等。开发者在安装这些复杂软件时,再也无需担心CUDA依赖的版本不匹配或者安装流程繁琐,只需通过操作系统的常用软件包管理工具即可轻松完成环境搭建。从更宏观的角度来看,此举充分体现了NVIDIA在推动GPU软硬件生态开放合作的战略眼光。

通过与主流Linux发行版及包管理器生态系统的深度融合,NVIDIA有效地减少了GPU应用部署的门槛,促进了跨平台的兼容性和软件维护的效率提升。更广泛地说,这将激活更多开发者群体参与到GPU加速应用的创新和优化中,加速AI计算、科学模拟和数据分析等领域的技术进步。展望未来,NVIDIA计划继续扩展合作伙伴名单,支持更多操作系统和软件分发渠道,实现CUDA生态的全方位覆盖。随着技术的不断迭代,GPU计算将更加普及和易用,真正实现"即装即用"的软件部署体验。开发者和企业可期待,利用集成CUDA的软件包管理体系,实现更快的开发周期、更高的运算效率以及更稳定的系统性能。同时,这也为云计算服务商和大型企业提供了管理复杂GPU集群和应用的便利,降低维护成本,提升服务稳定性。

总结来看,NVIDIA将CUDA软件栈引入操作系统官方仓库和第三方包管理器的举措,为整个GPU计算生态带来了深刻的变革。它不只是简化了安装流程,更构建了一个更透明、更高效的软件交付和更新机制,助力全球开发者在AI与高性能计算领域释放更大潜能。无论是科研院校、开发者个人,还是大型企业,这一发展都无疑意味着更容易获得领先的GPU计算能力,加速创新步伐。未来,随着更多平台的加入以及工具链的完善,CUDA的门槛将持续降低,GPU加速计算将更加贴近每一个需要计算力的开发者和应用场景。 。