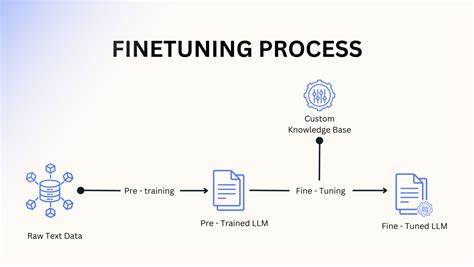

近年来,大型语言模型(LLM)在自然语言处理领域掀起了一场革命,从对话生成到知识问答,应用场景覆盖了广泛的行业。不少开发者和企业都试图通过“精调”(fine-tuning)技术来注入新知识,定制个性化任务,期望快速提升模型针对特定领域的能力。然而,随着研究的深入,人们逐渐认识到,精调并非万能钥匙,甚至可能是浪费时间的选择。理解这一点,需要从神经网络的本质和大型语言模型的训练机制谈起。 语言模型是由成千上万个相互连接的神经元组成的复杂网络。每个神经元承载着权重,这些权重通过训练过程逐渐学习并编码大量语言信息和语义关系。

训练初期,神经元如同白纸,权重随机分布,调整过程相对简单且代价低廉。然而,随着模型训练的深入,神经元内部权重变得密集且高度专门化,负责储存丰富的知识和语用规律。 此时,对模型进行精调意味着直接调整这些关键神经元的权重。虽然表面看似在注入新知识,但实际上是一种“覆盖式”操作:新数据可能会替换掉已有的知识结构,导致原有语料库中的丰富信息被破坏。这种“灾难性遗忘”现象在神经网络领域由来已久,也是很多人对精调抱有误解的重要根源。 更新神经元不是无代价的,尤其是在高级模型中,每一次权重微调都可能引发连锁反应,影响模型内部复杂的语义网。

比如,在AI安全和模型对齐任务中,研究人员发现微调会使模型的输出偏向于特定方向,减少了语言表现的多样性,甚至产生新的偏见。这种不可预见的副作用,正是因为模型权重的互联互依决定了单点调整可能引发全局性影响。 换句话说,精调不是简单的添加知识,而是精细且风险极高的权重重编程。在没有深刻理解模型内部结构和谨慎评估风险的情况下贸然精调,可能导致模型性能下降,甚至产生无法察觉的严重错误。因此,对于多数开发者和企业来说,投入大量时间和资金在精调上,很可能得不偿失。 那么,基于以上种种风险,机器学习社区和工业界开始更多地关注替代方案,这些方案试图避免对原始模型神经元的直接干预,而是通过模块化设计和增量扩展来实现知识更新。

检索增强生成(Retrieval-Augmented Generation,RAG)就是一种典型代表。它通过在推理阶段调用外部知识库,从庞大的数据库中动态检索相关信息,而不依赖改变模型本身的权重,从而保持模型底层知识不被破坏,同时提升答案的准确率和时效性。 另一个备受推崇的技术是适配器模块(Adapter Modules)和低秩适配(LoRA,Low-Rank Adaptation),它们通过添加小型子网络,实现对特定任务的定制,而不触及主模型权重。这样既节省了训练时间和资源,也避免了损坏模型整体结构的风险。 LoRA尤其受欢迎,因其训练成本低、速度快,能够在特定场景下达到与精调相媲美的性能表现,同时保持主模型完整。 对于想要快速获得优质结果的团队来说,手工设计和优化提示词(Prompt Engineering)也是极具性价比的方法。

有效的提示能够引导模型进入更优质的“思考路径”,帮助生成准确且贴切的内容。虽然这不属于真正意义上的“知识注入”,但结合现代LLM的超强泛化能力,往往也能达到良好的应用效果。 综上所述,随着对大型语言模型内部机制的深入理解,精调技术作为“知识注入”手段的局限性逐渐显现。它不仅代价高昂,且存在较大风险,容易造成原有知识的破坏和性能倒退。相比之下,基于模块化、检索增强和适配器的创新方案,更加灵活安全,具备更强的扩展性和维护性。 对于希望构建稳定、适应性强的AI系统的技术团队来说,摒弃传统的粗放型精调方式,拥抱以检索增强、子模块扩展和提示优化为核心的现代技术路径,将更有效地实现模型的持续更新和功能提升。

AI技术在高速发展,相关方法也在不断演进。理解并应用适合自身需要的技术手段,将帮助行业规避不必要的困境,推动智能系统更加稳健与高效地服务于人类社会。