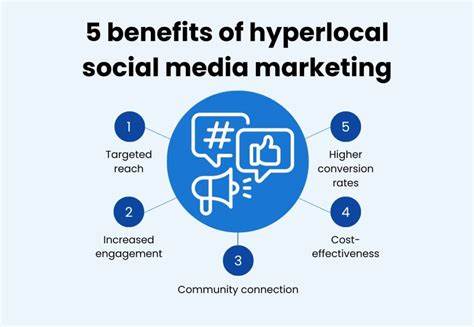

近年来,人工智能领域的发展使大型语言模型成为处理自然语言任务的关键技术。然而,面对日益增长的数据隐私保护需求和网络依赖带来的不便,如何在本地设备上高效运行大型语言模型成为了关注焦点。基于苹果M系列芯片的专用机器学习框架MLX,给用户提供了极具竞争力的选择,让本地部署LLM不仅成为可能,更加高效、节能和隐私友好。 本地运行大型语言模型的好处不言而喻。首先,数据安全性大幅提升。由于无需将敏感信息上传到云端,个人隐私和企业机密得到有效保障。

其次,离线环境为用户提供了更多自主控制权,尤其是在网络受限或不稳定的场景下,保证了服务的连续性和稳定性。除此之外,避免了持续付费的API调用费用,只需支付设备能耗这一项成本,对个人用户和中小型企业具有较强的吸引力。 苹果在硬件和软件层面为MLX打造了坚实基础。MLX专为M系列芯片优化,能够更好地利用芯片内的神经引擎和高性能CPU,提升模型推理的速度和能效。这不仅加快了语言模型的响应速度,也带来了更低的能耗表现,进一步提升了用户体验。用户可以通过MLX在设备上直接运行各种开源模型,享受近乎实时的智能服务。

在实际操作层面,使用MLX启动和管理LLM变得十分便捷。利用工具如uvx,用户能够快速搭建Python虚拟环境并安装所需依赖,实现顶层API服务器的本地运行。MLX提供的服务端示例支持OpenAI兼容的聊天完成接口,使用户的应用或客户端能够无缝对接,极大地提升了使用的灵活度和扩展性。 此外,日益丰富的模型资源生态为本地部署提供了坚实支撑。Huggingface上的mlx-community组织快速更新和上传适合MLX运行的模型版本,用户可以根据场景需求选择不同大小和精度的模型,例如从多亿参数到轻量化的量化模型。社区的积极贡献有效降低了入门门槛,也促进了技术的快速迭代。

对于命令行爱好者和开发者,simonw的llm工具及其mlx插件提供了功能强大的交互体验。通过这一工具链,可以灵活调用和调试模型生成结果,实现个性化定制和自动化处理。同时,利用shell别名和脚本,用户能够快速适配和管理模型资产,使得本地模型的开发与测试更加高效便捷。 现有的一些开源和商业项目也在积极推动MLX的集成。像Ollama这样基于llama.cpp构建的工具正在考虑拥抱MLX以获得更佳的性能表现。LM Studio等平台则将MLX纳入其生态,在企业合作前提下提 供成熟的使用体验。

未来,随着MLX生态的持续发展与完善,更多的应用场景将得以激活。 在实际体验中,模型的选择和参数调优起着关键作用。LLM的回复长度限制、量化方案、模型容量等因素都直接影响交互质量和响应速度。MLX目前默认的回复长度限制可能不足以满足某些复杂对话的需求,因此用户需要根据实际使用场景不断调整配置,甚至参与社区贡献,推动功能完善。 本地部署LLM对了解底层工作机制和计算资源消耗也大有益处。用户可以更清晰地感知硬件负载和能耗表现,这在远离传统“黑盒”云端服务时尤为重要。

掌握这些细节不仅有助于优化模型使用,还能在保护隐私的同时提高工作流程的透明度。 从技术普及的角度来看,MLX架构的优势在于降低了工程复杂度。它封装了模型加载、推理加速和服务器启动等核心环节,允许开发者集中精力于业务逻辑创新,减少兼容性和性能优化的难题。尤其是苹果芯片的独特架构与MLX紧密结合,体现了软硬件一体化的最大潜力。 未来展望中,本地大型语言模型运行将更趋智能化和多样性。MLX的发展路线可能会引入更多模型优化算法,包括更节能的稀疏计算、动态量化及更强大的模型压缩技术。

同时,跨设备协同与边缘计算整合也将成为趋势,允许多设备联合完成复杂推理,为用户带来无缝且安全的智能体验。 总体而言,利用MLX在本地设备上部署和服务大型语言模型,是当前人工智能技术进步与隐私保护需求结合的典范。它突破了传统云端依赖的局限,赋予用户更大的数据掌控权和使用自由度。无论是个人用户、开发者,还是企业用户,只要充分利用MLX提供的工具链和资源生态,都能够构建出符合自身需求的智能应用。 伴随着社区的不断壮大和技术的快速迭代,MLX在本地LLM部署领域的优势将日益显现。建议感兴趣的用户积极体验并参与,共同推动本地智能时代的到来。

。