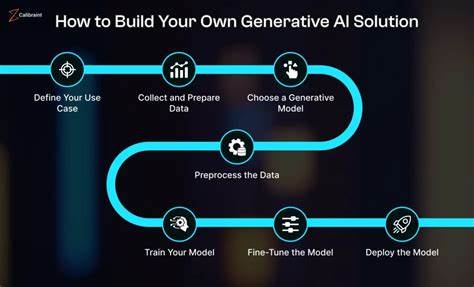

随着人工智能技术的飞速发展,预训练大型语言模型(Large Language Models,简称LLM)在自然语言处理和代码理解领域扮演着越来越重要的角色。特别是在代码相关任务中,LLM显示出了无与伦比的语言理解及代码生成能力。然而,庞大的模型规模和复杂的计算需求成为了制约其广泛应用的瓶颈。如何在保持模型性能的同时,降低计算成本和加快推理速度,成为了研究界亟待解决的问题。LeanCode正是在这一背景下应运而生的创新解决方案,致力于通过理解模型的内在机制实现代码简化,从而提升训练及推理效率。LeanCode是一种针对预训练大型语言模型的代码简化方法,其核心思想是利用上下文感知的注意力机制来评估代码令牌(token)的重要性,并基于此选择性地删减不重要的令牌。

与传统的方法不同,LeanCode并非简单地基于令牌在所有输入中的平均注意力分数进行删减,而是考虑了每个代码上下文中的细粒度注意力变化,这使得简化过程更加精准和高效。代码在执行时的上下文信息至关重要,因为同一个代码令牌在不同情境下可能承担着不同的语义角色。LeanCode的创新之处在于针对不同任务采用了不同的注意力分数来源,例如在分类任务中利用了编码器中的“CLS”令牌注意力分数,而在序列到序列的任务比如代码总结中,则依赖编码器-解码器间的注意力分数来确定令牌的重要性。通过这种差异化的策略,LeanCode能够更加合理地简化代码输入,避免对模型理解产生负面影响。在实际应用中,LeanCode展现了超越当今最先进技术(State-of-the-Art,SOTA)的显著优势。针对代码搜索任务,与DietCode和Slimcode等方法相比,LeanCode分别提升了60%和16%的性能;在代码总结任务中,性能提升则达到了29%和27%。

这些数据充分证明了LeanCode在提高代码相关任务效率和准确率方面的潜力。大规模预训练模型通常面临着输入序列长度增长所导致的计算成本成倍增加问题,尤其是在代码理解和生成中,源代码的结构复杂且冗长,处理起来尤其困难。通过利用LeanCode的注意力驱动令牌筛选机制,可以有效地压缩输入序列长度,减少计算资源消耗,同时保持模型的语义理解能力。这对于实际的软件开发场景具有极高的实用价值,比如快速代码搜索、自动代码生成、代码重构与总结等。LeanCode的设计理念还强调了模型透明度和可解释性。传统LLM虽然表现优异,但经常被批评为“黑盒”模型,难以理解其决策依据。

而LeanCode通过关注注意力权重,实际反映了模型在不同代码上下文中关注的重点,从而更好地诠释模型对代码片段的理解过程,为后续的模型优化和调试提供了科学依据。在学术界和工业界的广泛关注和交流中,LeanCode得到了持续的改进和提升。该方法被ACL 2025年主会议接收,代表着其技术创新性与实际价值获得了顶级大会的认可。未来,LeanCode有望进一步与其他模型压缩技术结合,如剪枝、量化等,构建更加轻量级且高效的代码理解体系。尽管LeanCode在多项指标上表现优异,仍有一些挑战值得关注。首先,不同编程语言的语法结构差异较大,如何确保LeanCode在跨语言情境下保持同样的简化效果,仍需进一步研究。

其次,注意力机制的解释虽提供了一定的可解释性,但仍存在噪声和偏差问题,需结合更多理论与实践经验加以完善。此外,在大规模工业应用中,如何平衡模型简化与业务需求、保证模型安全性及隐私保护,也是未来探索的重要方向。总而言之,LeanCode通过深入理解预训练大型语言模型的注意力机制,实现了针对代码处理任务的高效简化。这不仅显著提升了模型在代码搜索与代码总结中的表现,也降低了计算成本,为大规模代码智能处理铺平了道路。随着技术的不断成熟,相信LeanCode及其相关技术将在推动软件工程智能化、提升开发效率以及促进代码自动化方面发挥更加关键的作用。未来,我们期待LeanCode能够与更多AI前沿技术融合,为编程语言理解和生成领域带来更广阔的创新空间,助力构建更加智能、高效的软硬件生态系统。

。