近年来,随着金融科技的迅猛发展,多个支付和信用服务平台纷纷引入自动化系统以提升效率和减少成本。Klarna作为一个知名的灵活支付服务商,凭借其"先买后付"模式吸引了大量用户,尤其是在节日购物旺季。然而,一则真实的用户经历暴露了其自动化风控系统的漏洞和潜在风险,促使人们重新审视自动决策系统对消费者权益的影响。事件的主角是一位名为Amritha的用户,她享受着Klarna提供的灵活支付便利,却遭遇了系统误判。支付日当天,Amritha按常规操作成功下单并准备付款,但支付过程中平台的技术故障导致她无法完成交易。虽然客服告知技术问题并建议等待修复,但随后她却收到催收函,要求支付几乎翻倍的金额。

面对催收代理的强硬态度和平台缺乏有效人力审核的尴尬局面,她被迫支付了原始欠款及额外费用。此事件不仅导致她的个人信用评分大幅下滑,还使其在其他金融平台如PayPal上遭遇限制。揭开事件真相后,Amritha发现正是Klarna的自动决策算法未经过人类复核,直接将其案件转交给催收机构。尽管她多次通过GDPR数据访问权要求获得决策过程信息,Klarna的回复始终笼统甚至矛盾,反映出缺乏透明度与用户权利保障的现状。根据《通用数据保护条例》(GDPR),用户有权知晓平台对个人数据的收集和使用,尤其是自动化决策的逻辑和依据。第15条赋予用户访问个人数据的权利,第13条要求平台提供自动决策的说明,第22条明确禁止对产生重大法律影响的事项进行完全自动化决策,除非有用户明确同意或其他例外情况。

然而,Klarna在自动将逾期订单上报催收机构的行为上,既未提供详细的算法机制说明,也未开启人工干预通道,显然违背了第22条的规定。法律专家指出,除非用户明确同意,否则通过自动系统做出直接影响信用的决定涉嫌违法。Klarna的隐性默认同意条款覆盖了反欺诈和信用评估,却未明确包含债务催收环节,构成法律上的空白地带。此外,该案例还揭示了自动决策系统技术本身的不足。算法虽然依赖大量数据和复杂模型,但难免受到系统故障、数据不完整或异常的影响,导致误判或假阳性。尤其在涉及个体经济风险及信用声誉时,这类错误会产生严重后果。

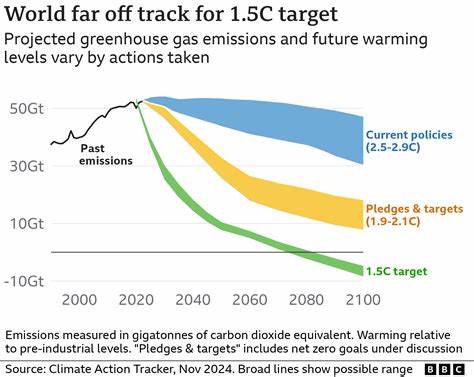

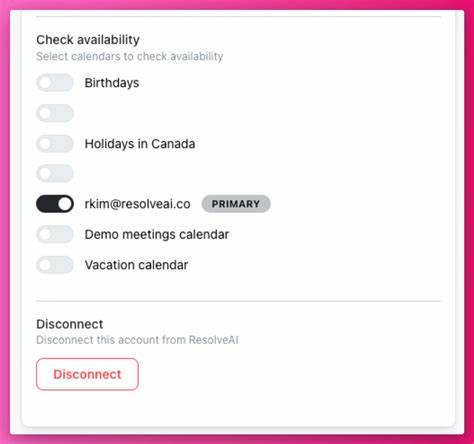

来自法国和英国的类似案例也反映出全球范围内自动化信用评分和社会福利分配领域的公平性问题。法国某福利系统算法被批评带有种族和社会偏见,英国社保部门基于算法的风控机制被指不公正地针对弱势群体。自动化系统本应提升效率与公正,但实践中缺乏透明监管和适当人工干预,容易造成"算法歧视"与法律纠纷。面对这样的挑战,广大消费者如何保障自身权益成为迫切课题。首先,充分了解并运用个人数据保护权尤为关键。GDPR为欧盟内用户提供了强有力的法规武器,允许用户查阅个人数据、要求算法解释、提请人工复核以及对自动化决策提出异议。

实践中,提交数据访问请求语言不必专业,可以通过简单的书面表达启动流程。其次,用户可以借助消费者保护组织的支持,如德国的Verbraucherzentrale和欧洲范围活跃的noyb,这些机构拥有经验丰富的法律团队,能够帮助用户进行申诉、投诉并推动案件解决。再次,推动立法完善和监管升级同样重要。现有法律框架尚无法完全覆盖飞速发展的自动化金融服务新场景,监管机构应加大对金融科技企业算法透明度的要求,规范算法设计与执行过程中的公平性检查,保护消费者免受无监督算法带来的风险。最后,平台自身也应承担更大责任。Klarna虽然在客户支持方面承认存在技术故障,但其对待用户投诉的态度和内部流程的缺陷显示出在自动化时代保持人文关怀的不足。

建立高效的人工审核机制、提供清晰透明的算法说明以及保障客户合理申诉渠道,是防止类似事件重演的必由之路。Amritha的经历不仅是她个人的维权故事,更是金融科技时代消费者权益保护的重要启示。算法作为强大工具,为人们带来便捷的同时,也潜藏着无法忽视的风险。只有通过完善法规、提升平台合规水平与增强用户自主权,才能实现技术进步与社会公正的和谐统一。作为社会成员,每个人都应增强数据保护意识,积极行使自身权利,同时呼吁科技企业和监管机构共同努力,建立更加透明、公正、可信的数字金融生态。未来,随着人工智能和算法技术不断迭代,如何平衡效率与伦理、自动化与人文关怀,将成为行业和社会面临的核心挑战。

Klarna被算法误判的事件为我们敲响警钟,也激发了新一轮关于算法治理和消费者保护的深度思考。 。