人工智能作为当下最引人瞩目的技术领域之一,经历了飞速发展和不断演变。通过回顾近百篇AI领域深度博客的内容,我们能够全方位地梳理这场技术革命中的关键经验教训和未来发展趋势。从经济学角度对AI的成本结构进行分析,到技术进步带来的突破,再到评估体系的困境及数据驱动的重要性,每一个方面都体现出人工智能复杂且动态发展的本质。 首先,AI的经济模型依然充满不确定性。早在2023年,关于OpenAI通过降低推理成本抢占市场优势的讨论就已火热。尽管GPT-5与GPT-4.1的性能提升不显著,但通过大幅降低单位Token成本,产品运营成本得以优化,这是一个显著的进步。

然而,更引人注目的是令运营商困扰的Token使用量激增现象。随着模型能力的提升和应用场景的拓展,Token消耗呈爆炸性增长,这直接推动了整体成本的增长。例如,一些产品因庞大的系统提示和复杂的调用,甚至出现了毛利率较低的困境。尤其是针对代码辅助写作的工具,如Cursor和Claude Code,因频繁调用大模型,令Token成本高企,企业采用存在较大经济阻力。尽管未来推理成本预计将进一步降低,但现阶段AI商业化进程必须面对这一严峻挑战。 同时,AI技术路径上的"不确定性"带来了意料之外的创新进展。

过去两年间,AI社区对于Retrieval-Augmented Generation(RAG)与微调技术的争论曾是热点话题。起初这些方法被视为相互对立甚至有减分效应,但事实证明,两者及其衍生技术如文本搜索、图谱增强、重新排序等形成了互补生态,为AI应用带来了逐层增益。更令人惊讶的是Agent技术的崛起。2023年初业内普遍认为开放式智能体的实现还需数年,但短短两年内,得益于语言模型能力的飞跃和社区经验快速积累,基于Agent的系统已成为主流实践。这种迅速逆转突显了AI领域技术迭代之快以及协同创新的重要性。 然而,评估AI系统效能依然是行业难题。

大量早期博客关注如何为RunLLM等产品设计合理的评测体系,但多次尝试现有框架后发现,理想的评测工具缺失导致实际效果难以量化和传导。目前业界普遍采用"感觉"评估为主,依赖内部测试脚本确保系统健全性和准确性,缺乏统一的、可广泛依赖的指标。在某些时间段,Chatbot Arena Elo分数似乎提供了一定参考,但随着用户需求多样化及开发者目标分歧,该指标的实用性逐渐降低。这反映出AI评测尚处于探索阶段,没有明确的标准和最佳实践,这是限制产品优化和跨领域对比的瓶颈。 数据质量依然是人工智能应用成功的基石。虽然这一观点在技术圈或许显得平淡无奇,但从实操角度来看,"垃圾进垃圾出"定律依然适用且至关重要。

博客作者强调,有效的信息输入对于获得正确和有效的输出至关重要。语言模型本质上是高效的文本处理机械,如果缺乏准确上下文和关键信息输入,结果自然难以令人满意。相较于人类能够基于经验调整输入,当前AI模型对错误或不足的上下文缺乏自我纠正能力。未来,如何提升模型的持续学习能力以及优化上下文管理成为关键议题,能够显著提升AI响应的准确性和实用价值。 值得一提的是,关于人工超智能(AGI)的讨论热度已明显下降。曾经火爆的AGI话题在业界逐渐被实用性更强的能力讨论取代。

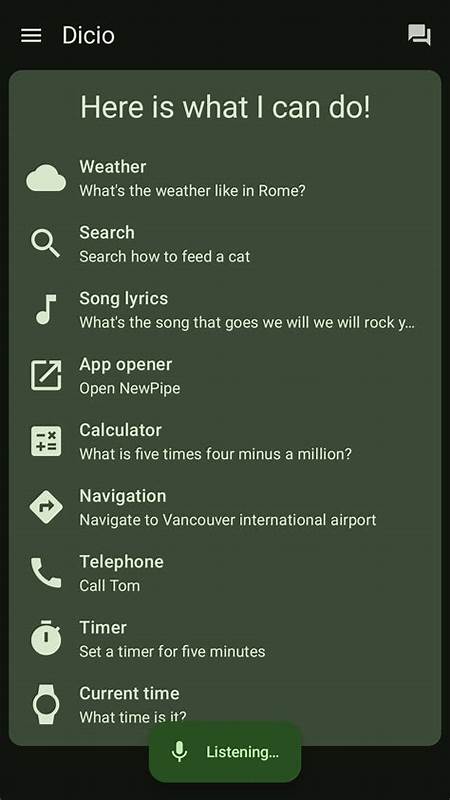

许多业内人士开始共识:AGI或许已不再是遥远目标,重点应放到现有智能系统的完善以及多样化场景中的应用创新。与其沉迷于哲学性辩论,不如聚焦AI现阶段能够实现的能力边界,以及如何针对具体问题打造优秀的用户体验和应用逻辑。正因如此,围绕AI应用UX设计的探讨日益加深,尤其是在如何让复杂智能技术为用户带来前所未有便捷和高效方面,仍有大量未解难题等待攻克。 纵观近百篇博客的总结,我们看到一个多维度的人工智能发展图景:技术不断突破,经济成本仍需调优,评估系统有待成熟,数据质量至关重要,AGI关注度逐渐弱化而实用场景繁荣。面对未来,AI产品开发者必须在成本管理、技术采纳、精准评测、上下文构建以及用户体验设计等多个环节持续创新。唯有如此,才能将AI从独立的前沿技术转化为深植于社会各领域、真正赋能人类的生产力工具。

未来的人工智能之路,既充满机遇,也伴随挑战。技术进步固然令人振奋,但经济和应用的可持续性才是决定AI能否真正变革世界的根本。对开发者而言,把握数据本质、深刻理解用户需求、合理设计评测体系,以及高效管理成本,将成为赢得竞争优势的关键。总之,从这近百篇博文汲取的经验不仅是回顾,更是启示,为我们描绘一幅AI演进的清晰蓝图,指引未来的技术探索和产品创新方向。 。