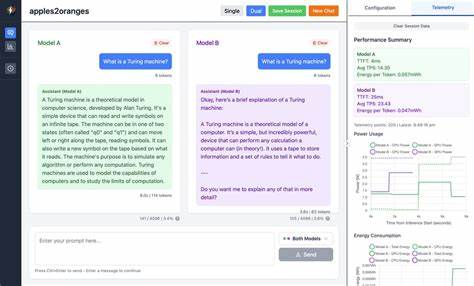

随着人工智能技术的不断发展,特别是大型语言模型(LLM)在自然语言处理领域的广泛应用,如何高效地比较不同模型的性能和资源消耗,成为开发者和研究者关注的重点。Apples2Oranges作为bitlyte团队在小型语言模型及本地AI生态中首次开源贡献的项目,顺应了这一需求,提供了在本地设备上同时运行多个模型、实时监测硬件状态并进行深入性能分析的创新工具。Apples2Oranges本质上是一款桌面应用,采用轻量级的Tauri框架构建,配合Rust和React技术栈,融合丰富的硬件监测功能,致力于打造一个小语言模型推理及对比的生态平台。该平台允许用户加载多种量化模型,借助双聊界面进行实时对比,并通过精准的硬件与推理数据帮助用户更科学地决策。Apples2Oranges的设计理念聚焦于普适性,既满足专业人士渴望精细对比和深度分析,又兼顾初学者和爱好者的操作友好,甚至为学习者揭示模型量化与硬件利用间的微妙关系。通过其智能的内存管理机制,保证系统资源利用最优化,避免无谓的内存占用。

一个显著特色是自动等待CPU温度回落到基线后再启动第二模型推理,确保公平、稳定的性能对比结果。这一点在同类工具中尤为罕见,也体现出该项目对精确指标的追求。仪表盘样式的实时硬件监控涵盖CPU核心利用率、温度、GPU使用率以及电力与能耗等关键指标,结合推理时的时间到首个Token(TTFT)、每秒生成Token数(TPS)等性能数据,让用户获得全方位的体验反馈。多达七次会话的并行数据分析功能,配合3D散点图、雷达图、并行坐标及气泡图等多样化的可视化方式,极大丰富了模型比较的深度与广度。不仅如此,Apples2Oranges还支持GGUF格式模型,保障与多种本地文本生成模型的兼容,并且具备灵活的配置保存能力,提升了用户的操作效率与个性化需求。作为一款专注于本地推理环境的工具,目前Apples2Oranges主打macOS系统,尤其对配备Apple Silicon芯片的电脑进行了针对性优化,并计划未来扩展至Windows和Linux平台。

对于模型加载和长上下文管理仍在不断迭代优化中,现阶段更适合短期推理任务和模型性能的初步探索。用户可通过GitHub仓库进行安装,需配合Node.js及Rust环境,另外建议安装macmon以无管理员权限方式实现硬件监控。软件虽处于早期版本,但开发者已明确表示鼓励社区积极参与,包括反馈问题、提出功能建议及贡献代码等。未来更新愿景中,包括引入更多推理引擎、多模态模型支持、API服务整合以及上下文持续管理,力图推动本地AI应用品质迈向新高度。这款工具不仅对于专业工程师和模型评估师意义深远,还对热衷于深入了解神经网络量化、硬件算力瓶颈以及推理效率的爱好者、学生具备极高的学习和实践价值。就目前市场现状而言,主流LLM大多依赖云端计算,而Apples2Oranges提供了一个自主可控、开源透明、数据可追溯的解决方案,帮助用户跳脱网络依赖,拥抱本地智能的未来。

其内嵌的高效Rust后端与友好的TypeScript前端实现了性能与体验的完美平衡,配合现代化的Tailwind CSS界面设计,让操作流畅且视觉舒适。硬件监控部分依托macmon、IOHID、sys_info等多种底层工具采集数据,为设备热指标及动态性能提供了真实可信的支撑。这对于在设备有限的条件下调优模型表现,找到最佳平衡点帮助极大。结合sqlite数据库存储会话数据,Apples2Oranges支持用户保存和复现先前的推理及聊天记录,便于回顾与深入分析。用户可灵活重跑历史消息以对比多个模型在相同条件下的输出差异,为研究和产品开发奠定坚实基础。虽然目前不支持API调取云端模型,未来规划中已明确提出将引入如OpenAI、Anthropic等主流云端服务对比,扩大应用场景覆盖。

总而言之,Apples2Oranges凭借其专注性能对比和硬件监测的独特视角,带来一款兼具实用与研究价值的开源工具。在快速演进的本地AI领域,它为模型选择、推理优化和硬件利用提供了全新思路。各类用户无论是追求精细模型表现的研发者,还是渴望实践本地AI的学习者,都能从中获益匪浅。随着版本不断完善和社区日渐活跃,相信Apples2Oranges将在未来成为本地语言模型生态不可或缺的一环。对于关注边缘AI发展、模型量化及硬件性能表现的技术人士来说,关注、参与和实践这一项目或许会带来意想不到的启发和价值。 。