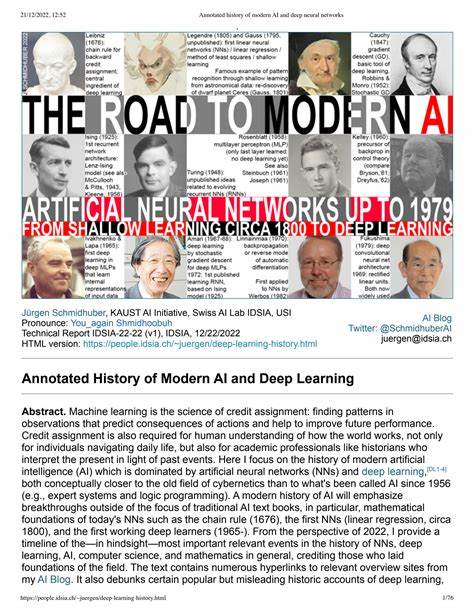

现代人工智能(AI)和深度学习(Deep Learning, DL)的崛起,是科学技术史上一场震撼的革命。追溯其根源,可以发现,其本质是寻找“信用赋值”的过程,即在观察中发现模式,预测行为后果并优化未来表现。人类理解世界、历史学家诠释当下以及人工智能系统的诞生,都是信用赋值科学的体现。与传统1956年达特茅斯会议上提出的专家系统及逻辑编程不同,现代AI与深度学习更接近20世纪中叶早期的控制论思想,而人工神经网络则是其核心呈现。早在1676年,人类就发现了链式法则这一数学工具,它为后续神经网络中的误差逆传播和深度信用赋值奠定了基础。随后,近代数学巨匠勒让德和高斯将最小二乘法的思想转化为线性回归模型,这实际上是最早的浅层神经网络,推动了基本模式识别技术的成长。

从1920年代物理学家伊辛提出的递归结构,到1972年阿马里的学习递归神经网络,网络结构开始具备记忆和动态反馈能力。1958年,罗森布拉特设计了包含多层网络的感知机,但尚不具备今天所理解的深度学习能力。1965年,乌克兰学者伊瓦赫年科与拉帕率先实现了多层深度学习架构,并在1970年代提出了基于随机梯度下降的整体训练方式。1970年西波·林奈曼首次发表反向传播算法,将链式法则高效运用到神经网络训练中,奠定了现代深度学习的训练基石。然而,四十多年间,深度网络训练仍面临梯度消失与爆炸等重大挑战,限制了其实用性。1979年,日本学者福岛邦彦提出了首个深度卷积神经网络框架——新认知机,开启了视觉识别领域新时代。

同时,他在1969年引入的修正线性单元(ReLU)如今成为卷积网络的激活冠冕。进入1990年代,深度学习研究收获丰硕成果:生成对抗网络(GAN)在慕尼黑首次提出,人工Curiosity激励算法被开发,不断推动自主学习机器的探索能力。1991年,斯普林格提出了线性化自注意机制,成为今天Transformer架构的先驱,为自然语言处理带来革新。同时,早期的自监督预训练、模型蒸馏等方法显著降低了深度网络训练门槛。关键难题——梯度消失问题由霍赫赖特于1991年解决,伴随长短时记忆网络(LSTM)的发展,解决了传统递归神经网络长时间依赖学习难题。1995年,神经语言模型重新定义了自然语言处理的标准。

2000年代,受LSTM启发的Highway网络和ResNet推动深度神经网络结构创新,层数从几十飙升至数百,极大提升网络表达能力。与此同时,强化学习结合深度网络出现突破,强化智能体在复杂环境中的学习能力,诞生了深度强化学习。在硬件方面,计算能力的指数级增长成就了深度学习奇迹,从古代齿轮计算装置到1940年代的电子计算机,再到现代的GPU和专用张量处理单元(TPU),硬件革命激活了理论潜能。冯·诺依曼架构、集成电路、图形处理器等技术累积,为深度学习提供了强劲算力支持。理论基础方面,自1930年代哥德尔、丘奇、图灵等人奠定了现代计算机科学基础,提出了可计算性和算法复杂性理论,为AI提供了理论指导。1970年代,所罗门诺夫及其后继者创立的算法信息论,为普适学习理论与人工智能探索提供了数学依据。

21世纪以来,AI研究不仅脱离了局限性的专家系统,还跨足了认知与推理领域。现代神经网络借助注意力机制、图神经网络、元学习等新技术,实现了更具通用性的智能表现。随着Transformer及其变种的风靡,语言模型和序列处理进入新纪元。当前,AI技术已广泛应用于自动驾驶、语音识别、图像理解、医疗诊断和机器人控制,极大提升社会生产效率与生活质量。展望未来,从2020年代到约2040年的“Omega点”预测,AI将进入指数加速发展阶段,技术融合硬件创新和理论突破,催生超级智能体。自主进化的智能机器人或自我改进的算法,可能实现对宇宙资源的深度挖掘与利用,推动人类文明迈向新的篇章。

总而言之,现代AI和深度学习并非近年偶然出现的技术潮流,而是几百年数学、物理与计算机科学积累的结晶。从链式法则到LSTM,从卷积网络到生成对抗网络,再到Transformer和自监督学习,每一步都源于对基础理论和工程实践的深刻探索。合理诠释AI历史,尊重所有先驱贡献,将促进学界健康发展,也指导未来人工智能更具创造力、更有效率地服务于人类社会。随着技术不断成熟,AI将在更多领域展现强大潜力,深刻改变我们对智能的理解和社会运行方式。