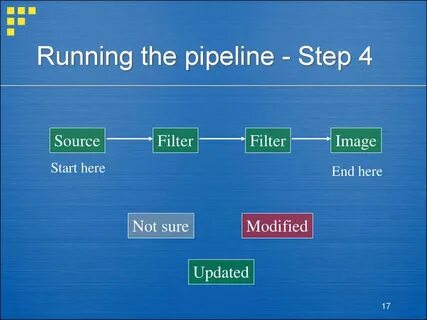

随着人工智能技术的飞速发展,语音交互成为连接人类与计算机的重要桥梁。语音转文本(Speech-To-Text,STT)、大语言模型(Large Language Model,LLM)以及文本转语音(Text-To-Speech,TTS)组成的流水线技术,使得自然语言处理变得更加智能和自然。而如何高效整合这三个环节,成为构建智能语音系统的关键。本文将详尽介绍如何利用C语言实现一个从STT经过LLM到TTS的完整管线,借助当前开源的强大库,打造性能优异且跨平台的智能语音交互系统。语音转文本是将用户的声音转化成机器能够理解的文字信息,这一步骤在智能语音助手、语音输入法和多种自动化系统中扮演至关重要的角色。C语言以其卓越的底层性能和跨平台兼容优势,在此环节中往往可以实现高实时性的语音识别效果。

当前,mt_stt库作为Whisper.cpp的C/C++封装,具备将音频快速转写成文本的能力,且易于集成,成为实现STT的理想选择。完成语音转文本后,流程进入大语言模型处理阶段。LLM不仅可以理解和分析文本,还能根据上下文进行智能写作、对话生成和复杂任务推理。Llama.cpp的C/C++封装库mt_llm提供了调用效能极佳的本地语言模型接口,使开发者能够无需依赖云服务便完成复杂的语言理解与生成工作。利用mt_llm,开发者可直接在本地结合STT输出的文本内容,进行智能回复、指令解析及内容扩展,极大提升整个系统的智能感知和互动深度。最后,将LLM生成的文本通过TTS技术转换为语音,完成从输入声音到输出声音的闭环。

Piper技术以及其封装库mt_tts提供高质量、自然流畅的语音合成功能。采用C语言接口,TTS模块在性能上同样可以做到低延迟且高还原度,还支持多种声音风格和语言,提升人机交互的个性化体验。建立这样一套STT→LLM→TTS的管线,意味着开发者可以在本地实现自动语音识别、智能语言处理与高质量语音合成,极大增强应用的自主性和隐私保护能力。使用纯C语言让整个系统具有良好的跨平台性能,无论是Windows还是Linux环境,都能顺畅编译运行,有利于在不同设备和场景中的部署。要构建这一管线,开发者首先应按照mt_tts库官方指导完成文本转语音模块的测试,确保基础TTS功能可用。接着基于mt_stt的说明,集成语音转文本功能,验证输入音频能够正确转写为文字。

紧接着,从mt_llm官方教程入手,将大语言模型模块加入项目,实现对文本的上下文分析和智能生成。最后,将三者结合在一个项目文件夹内,替换主程序main.c为最新实现文件,使用Visual Studio 2022的x64 Native Tools命令行环境进行编译链接,保证所有模块库的正确加载和调用。执行编译后的可执行程序后,系统将能识别输入的语音,借助大语言模型进行处理,并将结果通过文本转语音模块输出音频文件,用户可以直接收听智能应答。这种基于开源库的C语言实现方式,不仅降低了系统的依赖,而且在资源占用和响应速度上表现优异。对于想要打造定制化智能语音助手、智能客服系统以及自动化交互平台的技术团队来说,是非常有价值的实践案例。此外,C语言在嵌入式系统和边缘计算设备上依然占据主导地位,利用mt_stt、mt_llm和mt_tts等库封装的接口,可以快速在资源受限的环境中部署复杂的AI语音应用,满足多行业场景的需求。

未来,随着各个模块底层算法和模型的持续优化,结合更多语言和声音风格的支持,这样的STT→LLM→TTS管线有望为语音交互体验带来更加智能、自然和个性化的改革。在设计和开发过程中,建议关注跨平台兼容性和模块间数据传输效率,合理利用C语言的性能优势,确保语音处理的实时性和系统稳定性。同时,持续跟进开源项目mt_stt、mt_llm、mt_tts的更新动态,充分利用社区贡献的最新功能和优化,提升整体系统的技术水平。综上所述,构建一条高效、稳定且完整的STT→LLM→TTS语音处理管线,利用C语言和开源库实现本地部署,是实现智能语音交互的有力途径。无论是应用于智能设备、客服机器人还是语言学习工具,该管线均具备广泛的实用价值和市场前景。技术人员和开发团队可根据本文指导,有序搭建并优化管线配置,发掘AI语音技术在各行业的巨大潜能。

。