在计算机视觉与深度学习的热潮中,卷积神经网络(Convolutional Neural Networks,简称CNN)已经成为图像、视频和视觉感知任务的核心工具。围绕"谁发明了卷积神经网络"这一问题,历史并不是单一发明者的故事,而是由多位研究者在不同时间、不同背景下的连续贡献构成的复杂谱系。要理解这一发明史,需要把视角放在概念萌芽、架构设计、训练方法和工程实现四个层面上进行梳理。许多现在被视为"CNN核心"的要素,其实各自有着独立的起源与演变。 卷积神经网络的最早雏形可以追溯到上世纪七十年代末和八十年代初。日本学者久保木邦彦(Kunihiko Fukushima)在1979年提出的Neocognitron,被广泛视为最早的深度卷积式架构之一。

Neocognitron借鉴了Hubel与Wiesel关于猫视觉皮层的生理学发现,提出了交替的局部感受野特征提取层和下采样层的设计思想,这种层级化的局部连接与平移不变性思想成为后续卷积网络的重要启发。Neocognitron最初以无监督学习规则进行训练,更多体现为一种神经模型与生物视觉机制的理论结合,而非直接依赖于后来的监督反向传播训练。久保木早在1969年的工作中还使用了类似整流线性单元(ReLU)的激活思想,这一早期发现后来在现代深度学习中再次变得关键。 与此同时,其他研究团队在不同问题域中也提出了卷积或时间延迟结构的概念。上世纪八十年代中后期,Alex Waibel等人在语音识别领域提出的时延神经网络(Time-Delay Neural Network,TDNN)引入了权重共享和一维卷积的想法,运用了反向传播来训练语音分类器。一个与之相关的团队提出了"卷积"这一术语在神经网络中的应用,使得"卷积神经网络"这一名称逐步被接受。

进入八十年代末,卷积网络进入了"现代化"阶段:研究者开始把二维卷积与反向传播结合起来应用于字符识别等任务。1988年,张伟(Wei Zhang)及其合作者报告了首个使用反向传播训练的二维卷积网络,并将其应用于字符识别问题。该方向在1989年和90年代初得到进一步完善并发表在期刊上,构成了现代CNN体系的重要技术基础。 在几乎同一时期,Yann LeCun与他的团队在AT&T贝尔实验室推动了另一条关键路线。LeCun等人在1989年发表的关于手写邮编识别的工作,展示了基于反向传播训练的二维卷积网络在实际识别任务中的可行性,并将相关方法推向更广的研究社区。LeCun团队的工作在随后的几十年里对工业界和学术界影响深远,把卷积网络从实验室模型带向了实际应用场景。

结构细节方面的改进同样重要。久保木最初在Neocognitron中采用了基于空间平均的下采样(或平移不变性处理)方法,而在1990年代早期,研究者提出了最大池化(max-pooling)作为替代方案,这种操作后来成为很多现代CNN架构的标配。激活函数与网络深度问题也在长期演进中逐步得到解决,早在1969年和1970年代的工作就已隐含了整流线性激活的思想,后来在2010年代成为加速深度网络训练的重要元素。 如果把发明过程分为"提出概念的理论贡献"与"使其在实际任务中可用"的工程实现,两者都是不可或缺的。概念层面的奠基者为后续的发展提供了理论基础,而工程层面的突破往往决定技术能否在产业中爆发式应用。2011年是卷积网络走向广泛实用的一个重要年份:瑞士IDSIA实验室的研究人员Dan Ciresan及其同事率先将深层卷积网络结合GPU加速,显著提升训练与推理速度,并在图像识别比赛中取得了超越人类的成绩。

快速的GPU实现和更大规模的数据训练,让卷积网络在性能上实现质的飞跃,也推动了更多团队投入到CNN的研究与开发中。2012年Alex Krizhevsky等人发表的AlexNet,将更深的卷积网络应用于大规模图像识别任务(ImageNet),把CNN的潜力推向大众视野,进一步促成了行业内的广泛采用与快速迭代。 学术归属与发明权的问题常常伴随技术发展而出现。卷积神经网络的发展并非一人之功,而是多国、多团队长期积累的结果。日本学界在早期贡献突出,特别是在Neocognitron与相关视觉神经科学启发方面;欧美研究团体则在反向传播训练、器件实现与大规模应用上取得了关键进展。由于早期论文的发表背景、引用习惯以及地域传播的差异,关于"谁是发明者"的争议时有发生。

更为审慎的历史视角强调承认各个阶段的重要贡献:从Neocognitron的概念模型、TDNN的时间卷积思想、二维卷积与反向传播训练的早期实现,到最大池化、ReLU激活函数和GPU加速等工程改进,每一步都推动了卷积网络走向成熟。 理解这一历程对今天的研究与工程有重要启示。首先,基础理论与工程实现必须并重。早期的概念若缺乏高效训练算法与硬件支持,难以在工业尺度上发挥作用;反之,单纯的工程改进若没有坚实的理论支撑,也难以提出可持续演进的新模型。其次,跨学科灵感至关重要。生物视觉研究、数值优化方法、并行计算与统计学习理论多方面的交汇,造就了CNN从理论到实践的成功。

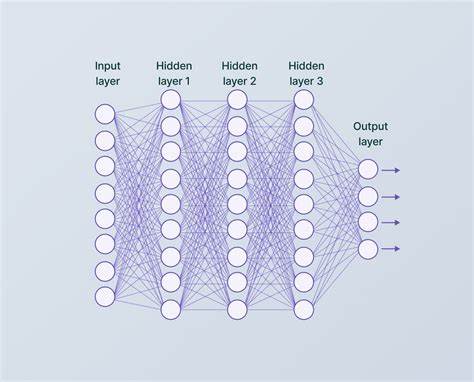

最后,历史的复杂性提醒我们在引用与致谢时保持严谨,识别和尊重早期贡献有助于构建更加健康的学术生态。 在技术细节上,现代卷积神经网络包含了若干关键组件:局部卷积核负责局部特征提取并通过权重共享减少参数;池化层提供空间不变性并降低计算复杂度;非线性激活函数(如ReLU)打破线性变换的限制并加速训练;批归一化、残差连接与各种正则化方法帮助训练更深、更稳健的网络。这些组件并非一次性由某个人独创,而是在数十年中通过不断实验、对比和改良逐步形成的。把这些元素整合在一起,并通过大规模数据和现代硬件训练得到的高性能系统,才是今天所谓"现代CNN"的真正含义。 面向未来,卷积神经网络仍在演进。自注意力机制和Transformer架构在视觉领域的兴起开始促使研究者重新审视局部卷积与全局自注意力的优劣互补。

轻量化网络、神经架构搜索、自监督学习和跨模态视觉语言模型正在推动视觉模型向更高效、更通用的方向发展。无论技术如何更迭,理解卷积网络的历史来源有助于更好地把握其适用场景与设计取舍。 总结来看,卷积神经网络不是单一发明者的产物,而是多个研究团队在不同方向上长期积累的成果。久保木邦彦的Neocognitron在概念上奠定了非常重要的基础;Waibel与同事在时延卷积与权重共享方面做出了贡献;张伟等人的工作和LeCun团队的推广使得反向传播训练的二维卷积网络成为实际可用的工具;而2010年代初的GPU加速与工程规模化则促成了CNN在工业与学术领域的全面爆发。认识这些历史脉络,不仅能更公允地评估贡献,也能为未来算法设计和工程实现提供宝贵的经验与启示。 。