随着人工智能技术的飞速发展,尤其是在自然语言处理和计算机视觉领域,对处理大规模上下文信息的需求日益增长。上下文窗口的大小直接影响模型理解和生成的准确性与连贯性。然而,传统计算架构在应对无限上下文窗口时面临诸多挑战,尤其是资源消耗和计算效率的限制。在此环境下,CPU注意力机制与无状态GPU计算的融合引起了广泛关注,成为突破现有瓶颈的重要方向。 CPU作为通用计算的核心,具备强大的串行计算能力和高度灵活的调度机制。其在注意力机制中的应用主要体现在处理复杂数据依赖关系和动态控制流程上。

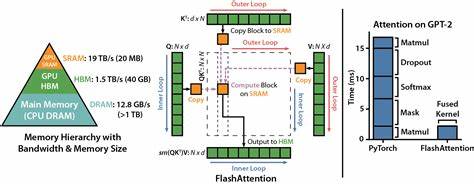

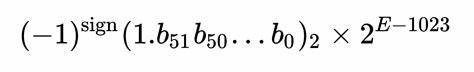

传统的注意力机制往往需要大量的内存和计算资源,尤其在处理长序列时,计算复杂度呈平方级增长。CPU的优势在于能够高效管理数据流和缓存,借助多核并行和超线程技术,优化注意力计算过程,降低延迟,提高吞吐量。 同时,无状态GPU计算则代表了另一种革命性的计算思路。GPU以其高度并行的架构擅长处理大规模的矩阵运算,成为深度学习计算的核心力量。然而,状态管理在GPU计算中往往带来额外开销,限制了扩展性和灵活性。无状态计算模式将状态信息从计算单元中剥离,减轻了对内存持久性的依赖,实现了更灵活的计算调度和更高的扩展效率。

这种方法尤其适合处理无限上下文窗口的任务,因为它允许动态加载和卸载上下文数据,避免了传统方法中因状态保存带来的瓶颈。 结合CPU的灵活控制和GPU的强大并行计算能力,无状态GPU计算补充了CPU在大规模数据处理中的不足,而CPU则弥补了GPU在控制逻辑和状态管理复杂性上的短板。通过合理的软件架构设计,将注意力机制核心部分部署在CPU,利用其对控制流的优势,同时将大规模矩阵乘法和向量计算任务卸载至GPU中无状态执行,能够显著提升处理无限上下文窗口的效率和可扩展性。 此外,当前人工智能模型的发展趋势也加速了对此类混合计算架构的需求。大语言模型(LLM)和复杂序列建模任务对上下文长度的扩展提出了更高要求。传统基于状态保持的GPU计算由于内存瓶颈和通信开销,难以满足无限上下文的实时处理需求。

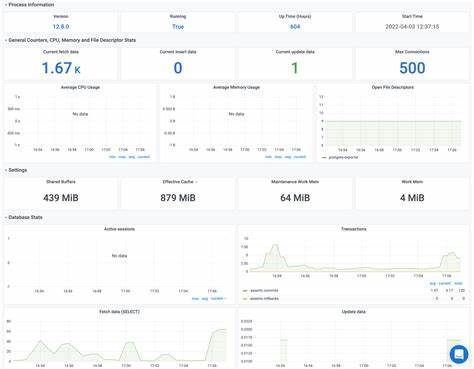

而借助CPU直接参与注意力计算,灵活管理上下文数据结构,并辅以无状态GPU的高效并行计算,能显著降低延迟,提升推理速度,实现真正意义上的无限上下文窗口支持。 在实际应用中,这种混合计算架构带来了广泛影响。例如在机器翻译、文本生成、语音识别甚至视频分析领域,模型能够实时访问更长的上下文信息,从而产生更加准确和连贯的输出。在数据隐私保护和联邦学习场景中,无状态GPU计算简化了设备间的数据同步流程,降低了通信成本,增强了系统弹性。 技术上,推动这类计算模式的关键还包括高性能互联技术和高效的内存管理方案。CPU和GPU之间的数据传输效率直接影响整体性能。

利用高速互联协议如NVLink,以及智能缓存和预取技术,可以最大限度减少数据传递延迟。此外,软件层面的优化也不可或缺,诸如异步执行框架、动态资源调度和任务拆分策略,有效协调CPU和GPU的计算负载,提升并行度和效率。 未来,随着硬件架构的持续升级和深度学习算法的优化,CPU注意力机制与无状态GPU计算的结合有望在处理无限上下文窗口能力上取得重大突破。探索更加智能和自适应的计算模型,将进一步释放两者优势。与此同时,随着开源生态的完善,相关技术方案将更加成熟与普及,为开发者提供灵活、高效的解决方案。 综上所述,CPU注意力机制和无状态GPU计算的协同发展,为解决无限上下文窗口的计算难题提供了坚实基础。

二者优势互补,不仅提升了计算效率和扩展性,也推动了人工智能模型处理更长序列和复杂任务的能力。随着研究的深入和应用案例的丰富,这一技术趋势无疑将成为推动未来智能计算创新的重要引擎。 。