近年来,图神经网络(GNNs)在诸多领域展现出强大的建模和推理能力,尤其是在处理结构化数据和复杂关系方面,已成为深度学习领域的重要分支。然而,在软件工程与程序分析领域,传统的数据流分析(Data-Flow Analysis, DFA)作为程序语义理解的基石,依然占据着关键地位。将GNNs与DFA深度融合,利用前者优异的表征学习能力和后者严谨的算法理论基础,是提升智能程序分析技术的重大突破。本文将着重阐述这一融合背后的核心思路、技术挑战与创新解决方案,并展望未来发展前景。 数据流分析作为编译原理和程序优化的经典工具,通过抽象程序中的变量定义与使用路径,捕捉程序状态的变化信息,实现如活跃变量分析、常量传播和污点分析等关键功能。DFA以其理论完备性和可解释性,被广泛应用于安全检测、软件维护等领域。

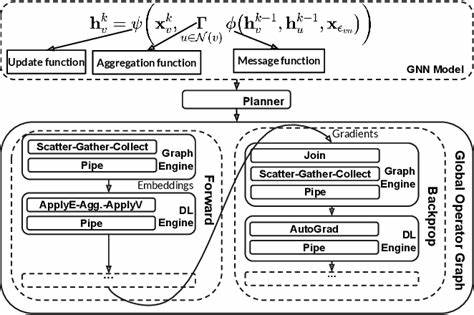

但传统DFA依赖手工设计的语义规则和复杂迭代算法,对代码结构依赖较强,难以有效应对程序规模扩展与多样化。 图神经网络通过对图结构数据进行端到端学习,可捕获节点的局部及全局语境信息,特别适合于表示代码中的数据依赖关系和控制流结构。GNN天然契合程序图的特点,使其成为数据流分析现代化改造的理想工具。学术界通过“神经算法推理”(Neural Algorithmic Reasoning, NAR)等框架,提出利用神经网络模拟传统算法,通俗理解为让神经网络“学习”执行经典算法的推理步骤,实现算法与神经模型的深度对齐。 在这一背景下,研究者们聚焦解决DFA与GNNs之间存在的关键歧义和技术难点,包括位向量的非干扰性问题以及外部信息在算法不同阶段的复杂处理。通过提出DFA-GNN家族架构,逐步提升模型的算法对齐程度,从DFA-GNN−、DFA-GNN到DFA-GNN+,不仅改进信息传递方式,也优化了状态更新机制,使得GNN能够更精准地模拟数据流分析的迭代行为。

在实证层面,这些架构表现出卓越的泛化性,尤其在训练样本有限且测试规模大幅扩张的情境中,依然保持出色的性能。实验数据证明,算法对齐更高的DFA-GNN+在样本效率和规模泛化能力上远超传统神经模型,能处理输入大小扩大十倍的程序图,显著降低数据标注和训练成本。 值得关注的是,研究还发现仅基于输入输出对进行训练的模型,并不逊色于那些利用全执行轨迹监督的模型,这展示了高度算法对齐GNN建模的强大鲁棒性与实用价值。这不仅为程序分析领域带来了全新的学习思路,也激发了对深度学习与传统符号计算融合的深入探索。 技术发展的背后,是理论与工程的双重突破。研究不仅关注提升模型预测准确率和扩展能力,更重视算法语义的忠实再现和可解释性,确保模型在实际软件工程任务中具备可用性与可信度。

同时,结合最新的图注意力机制和动态计算策略,不断优化神经网络的学习效率,为复杂程序的自动化分析和智能修复奠定了坚实基础。 未来,GNN与DFA的结合将拓展更多应用场景。例如,自动漏洞检测、代码补全、跨语言程序理解以及软件资产管理等,均受益于模型对程序语义深度理解的提升。此外,随着计算资源和算法架构的进步,包括Transformer在内的新兴神经网络模型与图神经网络的融合,也将极大丰富和完善程序分析的技术体系。 总之,深度融合图神经网络与数据流分析,是架构现代智能程序分析系统的必由之路。通过算法对齐原理,有效弥合神经模型与经典算法之间的鸿沟,不仅提升了模型的推理能力和扩展性,也为软件工程领域带来智能化创新。

随着研究的不断深入,预计这种融合将进一步推动程序分析技术进入效率更高、学习能力更强、适应性更广的新阶段,助力软件开发和维护迈向智能自动化新时代。