随着人工智能技术的不断演进,数据科学家们对复杂数据结构的处理需求日益增强。结构化数据中蕴含着丰富的关联关系,这些关系常常无法通过传统线性方法进行有效建模。图神经网络(Graph Neural Networks,简称GNN)应运而生,成为理解和利用图结构数据的有力工具。然而,近年来新兴的图变换器技术正在逐步取代传统GNN,成为结构化数据处理的革命性力量。图变换器结合了深度学习中变换器架构的强大自注意力机制与图数据的独特性质,极大提升了模型对复杂关系的捕捉能力和表达潜力。数据科学家了解并掌握图变换器技术,对于应对现实业务中的多样化数据挑战具有重要意义。

图神经网络通过信息传递(message passing)机制,依赖于每个节点与其邻居节点间的信息交换,逐步迭代更新节点的内部状态。尽管这一模式有效地挖掘了局部邻域特征,却存在明显的限制。消息传递容易导致信息的"压缩过度"(over-squashing)现象,使得跨多跳传播的信息变得稀疏且不完整,影响模型对远距离依赖关系的捕捉。此外,传统GNN在区分复杂结构及捕获全局上下文方面也存在不足。这些瓶颈促使研究者将目光投向了变换器(Transformer)架构。变换器模型最初在自然语言处理领域中广泛应用,依靠自注意力机制允许序列中的每个元素关注到其他所有元素,实现了对长距离依赖的有效捕获。

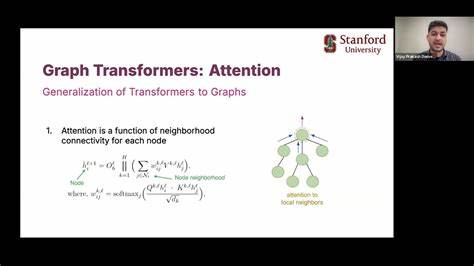

将类似机制引入图结构数据中,便诞生了图变换器。图变换器通过注意力机制打破了纯粹基于局部邻居的约束,使每个图节点均可根据学习到的重要性直接关注其它节点。其灵活性和表达能力优于传统消息传递方法,能够应对大规模、复杂的图结构数据。这种机制不仅减少了信息传递的层数需求,也解决了长期以来结构表达能力不足的问题。从技术角度看,最大的挑战在于如何将图的结构信息有效注入到无序的变换器架构中。图不像文本序列有天然的节点顺序,缺乏显式位置标记。

因此,图变换器引入了多种专门的图位置编码方法。在这些方法中,拉普拉斯特征向量(Laplacian Eigenvectors)利用图拉普拉斯矩阵的谱特性捕捉全局结构,随机游走捕获节点之间的概率路径分布,结构性编码则通过节点度数、距离指标或边类型等特征来提供局部及全局信息。这些编码机制为注意力模块提供了结构感知,使其能够更合理地计算节点间权重,从而提升模型性能。现实世界中,图变换器的应用场景广泛且日益丰富。以药物研发为例,通过将分子结构表示成原子和化学键组成的图,图变换器能够精确模拟分子间复杂的相互作用,助力新药性状预测。物流与供应链领域则利用图变换器来分析运输网络中的多方关系,实现路径优化与资源调度。

在电商平台,用户行为与产品之间的多重关系构成海量的图结构,图变换器通过抓取关联行为,优化推荐系统的准确度。网络安全领域应用图变换器检测异常访问模式和入侵行为,保护系统的完整性。这些实例充分展示了图变换器的多维价值,为企业带来了前所未有的洞察和竞争优势。不过,图变换器的实际部署同样面临一些工程与算法挑战。自注意力机制的计算和内存开销随节点数量呈二次方增长,巨大的图数据对硬件提出了高要求。多样且方向性的图边使得结构编码与注意力权重的计算更加复杂。

此外,结构化图数据往往需与非结构化数据(如文本、时间序列、图像)融合处理,要求架构设计具备高度灵活性和鲁棒性。这些技术难题促使业界在算法优化及系统设计上持续投入,如采用局部注意力、稀疏化技术、多层次混合建模等方法,力求保持性能和效率的平衡。未来,图变换器与大型语言模型(Large Language Models,LLM)的融合成为一个备受关注的研究方向。通过将图结构的知识与语言上下文结合,能够打造更加智能且具备推理能力的混合系统。例如,在生命科学领域,AlphaFold利用图变换器解码蛋白质结构,在分子水平推动科学突破。在企业智能助手领域,结合图变换器构建的客户行为图与LLM的文本理解,实现更精准的客户问题解决。

此外,智能代理能够借助图变换器动态分析环境状态和关系,优化决策过程,满足多样化应用需求。综上所述,图变换器不仅仅是图神经网络的继任者,更代表了一种结合结构意识与灵活注意力的新范式。无论是金融风控、医疗健康,还是推荐系统和智能制造,理解和运用图变换器技术,都将为数据科学家和企业带来颠覆性的价值。面对信息爆炸和数据复杂化的新时代,掌握图变换器技术,意味着能够更好地驾驭结构化数据,实现跨领域创新和智能升级,为未来数据驱动的世界铺平道路。 。