随着人工智能技术的飞速发展,大型语言模型(Large Language Models,简称LLMs)正逐渐成为科学研究中不可忽视的重要工具。尤其在化学领域,这些基于庞大文本数据训练的模型展示了超乎想象的语言处理和信息生成能力,挑战了传统人类专家的专业地位。本文将围绕大型语言模型的化学知识储备与推理能力,与人类化学专家展开深入比较,探讨其优势、局限及未来可能带来的变革。 大型语言模型的兴起无疑源于其在语言理解和生成方面的卓越表现。经过海量文献、教材、数据库和论文的训练,LLMs能够高效处理复杂的化学文本,甚至在未经过专门训练的任务中表现出令人瞩目的泛化能力。近年来,业界最顶尖的模型已经在多个专业化考试中达到或超越人类水平,表现出“类通用人工智能”的雏形。

然而,这些模型的内部工作机制本质上基于统计模式匹配与概率推断,被批评为“随机鹦鹉”,即它们并非真正理解知识,而是复述训练数据中的内容。 在化学领域,知识的准确掌握和严密的推理尤为重要。大量的化学信息以文本形式散布于教科书、学术论文和专利中,人类专家依靠长期积累的专业知识结合实验数据进行判断。与之不同,LLMs虽然在文本中学习并模拟化学语言,但它们并不直接进行实验验证,因而其输出虽然丰富,但往往难以确保完全正确。此外,模型有时会表现为过度自信,错误回答时难以体现出对应的不确定性,这在涉及安全易燃、有毒化学品的应用时存在潜在风险。 为促进对这类模型在化学专业领域能力的科学衡量,研究人员开发了专门的评价框架——ChemBench。

该框架包含超过2700条覆盖广泛化学主题的问答内容,涵盖从基础化学知识到高级推理和化学直觉的多维度考察,既包含选择题也包含开放式问答。其中的一项关键发现是,部分最先进的LLMs在整体表现上甚至超越了参与实验的化学专家,凸显出其强大的信息整合能力和语言理解能力。 然而,值得注意的是,这些模型在某些知识密集型问题上依然表现较弱,尤其是在化学安全性和毒性评估领域。模型难以完全替代专家对数据的分析与判断,尤其是在需要跨学科知识和深层次推理时。此外,由于LLMs训练语料和知识库的限制,它们能够回答的问题往往局限于其训练数据的范围,面对不常见或者新颖的化合物结构,推理准确性降低。 在具体学科分支上,比如分析化学中复杂核磁共振信号识别,LLMs的表现远不及化学专家。

专家通过结构绘图和深刻的分子对称性理解,能精准判断信号数目,而模型仅凭SMILES字符串而缺乏对分子三维空间的认知,导致推理能力不足。此外,对于化学直觉类的问题,如药物设计中化合物的偏好判断,LLMs目前表现接近随机,表明这类涉及主观判断和经验聚合的任务尚不适合完全依赖AI。 对比人类专家与LLM的评测也揭示了模型自身对答案置信度估计的不足。多项测试显示,许多模型在自我判断正确与否的能力上存在严重误差,错误的答案常伴随着过度的自信,使得用户难以分辨答案的可靠性。这一现象提示化学领域中AI辅助工具的使用者必须保持批判性思维,并辅以专业知识核验模型输出结果。 大型语言模型在化学领域的迅速进步,也引发了对教育模式的深刻思考。

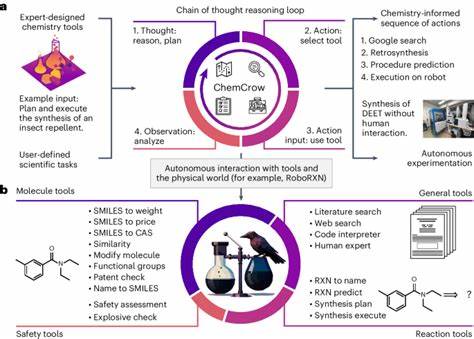

传统的以记忆事实和机械训练为中心的化学考试已难以衡量未来科学家的能力。随着人工智能在信息检索和基础知识掌握方面的超群表现,化学教育需要更多地强调批判性分析、问题解决能力以及跨领域整合思维,以配合智能系统成为辅助科研的有力工具。 未来的发展方向中,结合LLMs与专门化学数据库的混合系统被认为是提升AI化学推理能力的关键。例如,集成公共化学信息库如PubChem、Gestis的检索模块,可以大幅扩展模型对于特定物质安全性和性质的准确认识。此外,工具增强型模型(Tool-Augmented Models),利用外部计算资源和实验自动化仪器相结合,有望实现实验设计和执行的半自动化,极大提升科研效率。 同时,随着模型规模的不断扩大及训练技术的优化,其对化学结构的理解力也有望逐步增强。

目前业界已在探索多模态模型,将化学分子结构、图像与文本相结合,突破纯文本表示的局限,使得模型不仅能处理化学语言,还可以“看懂”复杂的分子布局和实验数据,进一步增强推理和创新能力。 不过,AI与化学的结合也伴随着风险,尤其是技术的“二重用途”问题。例如,能够设计无毒分子也可能被滥用来设计有害物质。因此,构建安全可靠的使用标准和监管机制同样重要,避免技术滥用带来社会问题。 总的来看,大型语言模型在化学知识与推理方面展示出前所未有的潜力,正在成为科研与教育的新助力。尽管它们还不能完全替代人类专家的综合判断和创造力,但凭借其庞大的信息处理能力和持续进化的模型结构,合适的应用场景中LLMs能够显著加速化学研究进程。

未来,促进人机协作、优化模型可信度及公平性,将是推动这一领域持续发展的关键环节。