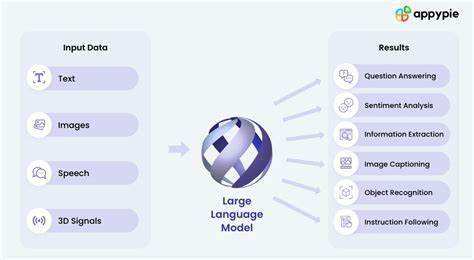

大型语言模型作为当前人工智能领域的核心技术,依托海量数据进行预训练,已在自然语言处理、代码生成以及视觉分析等多个领域展现出强大的能力。然而,面对具体且复杂的任务,这类模型往往因预训练时使用的泛化数据而难以发挥最佳性能。如何在保证计算资源合理利用的前提下,有效提升这些大规模模型的任务适应能力,成为学术和工业界共同关注的焦点。近日,北卡罗来纳州立大学的研究团队推出了一项名为WeGeFT(Weight-Generative Fine-Tuning,权重生成微调)的创新技术,成功实现了对大型语言模型的高效微调,且无需大幅增加计算成本,为大模型技能提升开辟了全新路径。预训练模型与微调技术的挑战传统预训练大型语言模型一般采用变换器架构,通过学习庞大的文本语料库,捕捉语言的统计规律和多层语义信息。虽然这种方法让模型具备了处理多样语言任务的基础能力,但预训练的性质导致模型在面对高度专业化和复杂的任务时表现有限。

为此,研究人员需要对模型进行微调,即在具体任务数据上进行再训练,以让模型适应特定领域的需求。然而,随着模型参数量达到数百亿乃至千亿级别,传统的微调需要耗费大量计算资源,不仅成本高昂且速度缓慢,实际应用受阻。研究团队指出,现有的微调方法多存在无法兼顾性能提升和计算效率的矛盾,尤其是经典的低秩适配方法LoRA虽然在参数效率和性能间取得了平衡,但其后续改进尝试往往付出了更多计算资源,且未能获得更理想的表现。WeGeFT技术的核心创新基于对预训练模型参数的深度理解。该方法利用两个线性层构成的低秩结构,学习一种生成式机制,直接从原有的预训练权重中生成适应特定任务所需的微调权重。通过这种方式,模型能够精准区分哪些参数是已有知识,哪些需要“学习”新技能,从而将精力集中于真正关键的调整部分。

此创新不仅保留了LoRA的计算与内存优势,还进一步提升了微调效率。经实验证明,WeGeFT在常识推理、算术推理、指令跟随、代码生成以及视觉识别等多个下游任务上均取得了优于或不低于LoRA及其各种变体的性能。特别是在保持低计算负担的情况下,模型对多样化任务的适应性和准确率实现了跨越式进步。除了技术层面的突破,WeGeFT还为人工智能模型的安全与可控性带来了新的可能。研究团队正在探索利用该方法识别和编辑模型中导致有害输出的参数,实现“AI外科手术”式的精准优化。这一方向对提高人工智能系统的可靠性和伦理合规性至关重要,意味着未来WeGeFT不仅能提升智能水平,还能加强模型的安全管理。

WeGeFT将在2025年7月举行的国际机器学习大会(ICML)上正式发布,与来自全球的学者分享这一成果。该方法得到了美国国家科学基金会与陆军研究办公室的支持,彰显了其科学价值及潜在应用前景。随着人工智能持续融入社会各个领域,提升大规模语言模型微调效率的重要性愈发显著。WeGeFT的诞生折射出学术团队对复杂技术难题的深入洞察与创新求索精神。未来,随着该技术进一步优化与推广,预计各行各业将受益于更加智能、高效且安全的AI服务。总结来看,WeGeFT代表了大规模语言模型微调技术的新趋势。

它不仅实现了性能提升和计算资源节约的双重优化,还为语言模型的安全治理提供了新的思路。通过这一创新,人工智能迈向更加精准和可控的智能新时代,推动其在自然语言处理、科技研发、教育、医疗、金融等众多领域的应用爆发式增长。持续关注这一领域的研究进展,对于把握未来人工智能发展脉络和商业机遇尤为关键。