随着人工智能和深度学习的不断进步,循环神经网络(RNN)作为一种处理序列数据的强大工具,正逐渐颠覆传统的数据处理方式。RNN不仅能够有效应对文本、语音、图像等多种形式的序列信息,还能够生成极具创造性的内容,使得机器学习的应用领域日益扩大。本文将深入剖析RNN为何表现得如此出色,涵盖其基本原理、实际应用、训练技巧以及未来发展趋势。循环神经网络最核心的优势在于其对序列依赖关系的建模能力。传统的神经网络,如前馈神经网络或卷积神经网络,通常接受固定长度的输入并输出固定维度的结果,这限制了它们对变长序列数据的处理能力。相比之下,RNN通过引入隐藏状态,能够对先前输入的信息进行“记忆”,并将历史信息贯穿于整个序列。

换言之,RNN在每一个时间步中不仅接收当前的输入,还结合了之前所有时间步的状态,形成一种动态的状态更新机制。这种机制犹如一台拥有内部记忆的机器,使得RNN能够理解上下文和时间顺序中的复杂关系。尽管最初的RNN模型(如Vanilla RNN)在长序列上存在梯度消失和梯度爆炸的问题,难以捕获远距离依赖信息,但随着长短期记忆网络(LSTM)和门控循环单元(GRU)的提出,这些问题得到了有效缓解。LSTM通过设计输入门、遗忘门和输出门,有选择性地保留和抛弃信息,极大提升了模型对长依赖关系的学习能力与稳定性。基于这些改进,RNN在文本生成、机器翻译、语音识别等任务中取得前所未有的成功。RNN在实际应用中表现出的“魔法”令人惊叹。

以字符级语言模型为例,输入大量文本数据后,RNN能够逐字符预测下一个最可能出现的字符,实现文本生成。令人惊奇的是,经过训练的模型不仅能够拼写正确的单词,还能模仿语法结构甚至写出具有一定逻辑连贯性的段落。有研究团队在不同的数据集上进行了训练,从英语文章、莎士比亚作品、维基百科内容,到复杂的数学LaTeX代码,以及大型的Linux内核源码。结果表明,RNN在各种结构化和非结构化数据上都能捕捉深层次规律,有时候甚至生成的内容能达到“假冒大师”的级别。这种现象揭示了深度学习中端到端训练的强大能力,即使不经过人为设计规则,模型也能从原始数据中自主发现结构和模式。例如,训练在维基百科数据集上的LSTM能够正确生成符合Markdown格式的文本,甚至能保持XML标签闭合顺序,有些细胞甚至学会了“引号检测”的功能。

这种“神经元”的自发学习凸显了深度学习模型理解和处理复杂语言结构的潜力。训练RNN的过程本身也引人入胜。起初,模型生成的文本多为无序的字符堆砌,但随着迭代次数增加,逐渐学习到空格用法、常见单词、标点符号,从短词到长词,最终生成结构完整的句子和段落。这一演化过程不仅体现了模型对语言层次结构的认知,还显示了深层次记忆在序列处理中的关键作用。模型训练多采用随机梯度下降配合适应性学习率优化算法如Adam或RMSProp,结合截断反向传播避免梯度爆炸,通过不断微调权重,达到较优的预测效果。同时,调节采样温度参数可以控制生成文本的创新性与准确性,实现从保守重复到多样化创新的平衡。

此外,RNN的应用远不止语言领域。计算机视觉领域内,循环神经网络被用于视频帧级分类、图像描述生成以及视觉问答等任务。结合卷积神经网络(CNN),RNN能够处理图像的时序信息,捕捉动态变化,提升视觉理解能力。一些创新模型如视觉注意机制更是引入了强化学习技术,实现了“窥视”图像不同区域的策略优化,推进了复杂任务的性能突破。尽管RNN存在内在的优势,但它们也面临诸多挑战。例如,模型对长距离依赖的捕获虽有改进,但仍难以完全解决。

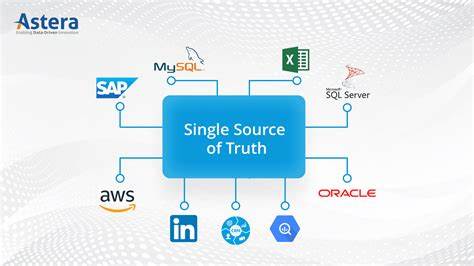

循环结构导致的计算链条长,使得训练时耗较高。此外,固定大小的隐藏状态导致扩展性受限,难以直接处理需要非常大记忆容量或长期推理的任务。针对这些问题,研究者提出了神经图灵机(Neural Turing Machines)、记忆网络(Memory Networks)和基于注意力机制的变体,试图使模型拥有更大、更灵活的外部记忆和访问能力。软注意力机制的引入,使整个模型保持端到端可微,并且能够对关键部分赋予更大权重,极大提升了性能和解释性。这些研究为RNN的发展开辟了新的方向,有望解决传统循环网络难以逾越的瓶颈。从算法设计到计算框架,RNN的生态也在不断完善。

现代深度学习平台如TensorFlow、PyTorch和Keras为RNN的开发和加速训练提供了强大支持。GPU的广泛应用极大缩短了训练时间,使得大规模模型成为可能。针对序列数据,诸如多层LSTM结构、双向循环网络(BiRNN)、堆叠循环网络等架构被广泛采用,进一步提升模型的表达能力和泛化性能。展望未来,循环神经网络将在更多领域实现突破。随着计算资源的丰富与算法的优化,RNN有望在自然语言理解、自动代码生成、机器人控制、医疗诊断甚至艺术创作等方向发挥更大作用。融合外部知识库、可解释机制以及多模态数据处理将成为研究热点,推动人工智能走向更高水平的智能化和自主学习。

总结来看,循环神经网络以其独特的架构设计,将序列信息的动态变化与记忆机制完美结合,展现出了出人意料的强大性能。从最早的字符级文本生成到如今覆盖语言、视觉、代码等复杂领域,RNN的神奇表现不断刷新人们对机器学习的认知。对于希望深入理解序列数据与构建智能系统的研究者和开发者而言,掌握循环神经网络的核心思想和应用技巧无疑是必不可少的。未来,随着研究的不断深入和应用场景的持续拓展,循环神经网络必将成为人工智能发展进程中不可或缺的重要力量。