在当今数字化转型加速的时代,人工智能特别是大型语言模型(LLM)在金融领域的应用愈发广泛。从自动化报告生成、投资咨询到情感分析和合规监控,LLM正以前所未有的速度推动金融服务的创新与升级。然而,随着这些模型规模的不断扩大和结构的日趋复杂,金融机构也面临着一个亟需解决的问题——黑盒难题。模型的决策机制缺乏透明度,使得用户和监管者无法明确了解模型如何得出具体结论,带来了信任危机和潜在风险。机械可解释性作为一种革新性的技术路径,正在打破这层神秘面纱,为金融界带来全新的解析与掌控能力。 大型语言模型的核心优势在于其强大的自然语言处理能力,能够理解并生成高质量文本,支持金融领域多样化的应用需求。

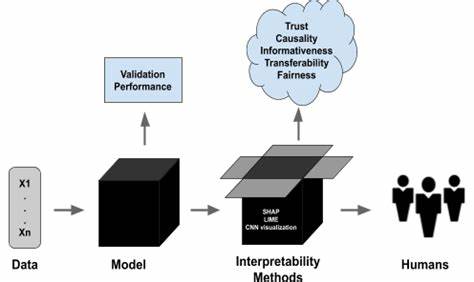

例如,通过智能文本摘要,金融分析师能够快速获取市场动态和行业趋势;依靠情感分析,投资者能洞察市场情绪,辅助决策制定;而在合规领域,模型能够自动识别政策变化、监管文档,提升合规效率。然而,尽管表现出色,这些模型往往被视作“黑盒”——外部看似透明的输入输出背后,隐藏着一套复杂而难以解释的算法和权重。这种不透明性不仅限制了用户对模型的信任,也增加了金融机构面对监管审核时的合规难度。 传统的可解释人工智能方法在处理LLM时往往力不从心。它们通常依赖于输入特征的重要性评分或局部模型解释,但对深度学习模型复杂内部结构的理解有限。机械可解释性则倡导通过逆向工程方法,逐层剖析模型内部的激活模式和神经元电路,明确每个组件如何影响最终的决策输出。

这种精细化的“解剖”不仅揭示了模型的特征提取策略和推理路径,也使得模型行为可预测和可控,极大地提升了模型的透明度。 在金融领域,机械可解释性带来了多方面的积极影响。首先,对于交易策略的开发和优化,通过理解模型如何解析历史行情数据、识别关键指标,交易员能够设计出更精准且风险可控的策略。此外,情感分析中的偏差识别变得更加高效,模型可能因训练数据中的偏见而产生误导性判断,机械解释技术可以揭示并纠正这些偏差,避免决策失误。最为关键的是,在监管合规方面,金融机构通过解释模型的操作逻辑,可以更容易回答监管机构关于模型公平性、合理性和安全性的审查,满足日益严苛的合规标准。 举例而言,在市场行情预测中,机械可解释性技术通过拆解模型内部特定神经元对价格波动信息的响应,能够识别重要的价格模式和潜在风险信号。

这种透明度让投资者和风险管理人员能够信赖模型输出,及时调整持仓策略以应对市场变化。同时,对模型产生的误判和“幻觉”现象进行检测和分析,也依赖于对模型内在机制的深刻理解,从而减少潜在的资金损失。 从宏观层面看,随着全球金融监管力度的加强,监管机构对于人工智能系统的透明性和公平性提出了更高的要求。机械可解释性为金融科技公司提供了一条合规路径,使得算法决策过程能够被细致审查,为模型的可审计性提供技术保障。这不仅利于防范金融犯罪和欺诈行为,也增强了客户对智能金融服务的信任感,推动行业健康可持续发展。 然而,机械可解释性的推广和应用还存在一定的挑战。

首先,模型规模庞大,分解和分析计算资源消耗巨大,需要高性能计算平台的支持。其次,解释结果如何以直观且易懂的形式展示给非技术背景的金融从业者,也是技术落地的重要环节。此外,保护用户隐私和数据安全在解释过程中必须得到充分重视,防止敏感信息泄露。 尽管如此,未来随着研究的深入和技术的成熟,机械可解释性必将在金融行业扮演愈发重要的角色。通过结合自动化工具和可视化技术,金融企业能够构建起完善的模型风险管理体系,实现从模型开发、测试到上线的全流程透明监控。更重要的是,这种机制有助于构建以人为本的智能金融生态,确保AI系统服务于人类利益,避免算法固化偏见,实现公平、公正、负责任的人工智能应用。

总的来说,破解大型语言模型的黑盒本质,是金融行业迈向智能化、合规化的必由之路。机械可解释性作为一种前沿技术手段,正在成为推动金融AI透明化的重要驱动力。从交易策略到风险控制,从客户服务到监管合规,LLM的内在逻辑解析赋予金融场景更多的智能可能,也让金融科技走得更稳、更远。未来,随着业界不断探索和实践,期待机械可解释性能够进一步深化落地,助力全球金融生态迈向更加开放、透明和可信的新时代。