在当前人工智能迅速崛起的时代,AI芯片成为驱动行业进步的关键硬件。长期以来,Nvidia凭借其高性能图形处理单元(GPU)及CUDA平台,牢牢占据着AI基础设施市场主导地位。然而,随着技术的不断演进,另一家科技巨头谷歌正悄然崛起,逐渐展现出挑战Nvidia霸主地位的潜力。谷歌依托自主研发的张量处理单元(TPU),不仅满足了自家庞大AI运算需求,也开始向外部开发者提供租赁服务,甚至吸引了OpenAI等顶级AI研发机构的关注和试用。谷歌TPU的崛起能否掀起AI芯片市场的新风暴?本文将全面剖析谷歌TPU的技术优势、市场机遇以及其未来发展路径,深度解读或将改变行业格局的幕后力量。 谷歌TPU的诞生始于应对自身海量数据和复杂AI模型的计算需求。

作为专为深度学习任务设计的专用集成电路,TPU在计算速度、能效比以及延迟等方面具备显著优势。相比通用GPU,TPU能够更高效地处理矩阵乘法和张量运算,这也是深度神经网络的核心计算过程。谷歌将其广泛应用于搜索、翻译、语音识别等关键业务,极大提升了服务质量和响应速度。 近期谷歌推出了名为“Ironwood”的全新推理专用TPU,专门针对AI推理阶段进行了优化。推理阶段是将训练好的模型应用于实际数据的关键环节,对速度和成本要求极高。Ironwood TPU在功耗控制、延迟降低和弹性扩展方面展现卓越性能,使其成为AI推理的理想硬件选择。

随着AI推理市场的快速扩大,这款专用TPU有望获得更广泛的市场认可和采用。 另一方面,谷歌的垂直整合优势不可小觑。公司不仅拥有自研芯片,还搭建了顶级云计算平台Google Cloud和完整的软件生态系统,能够为客户提供从硬件、云资源到AI框架的全方位服务支持。这种具有端到端整合能力的商业模式,为谷歌在AI基础设施市场树立了强大壁垒。相比之下,Nvidia虽然在芯片领域技术领先,但并不拥有云平台资产,这为谷歌提供了差异化竞争的机会。 AI基础设施市场本身面临巨大增长机遇。

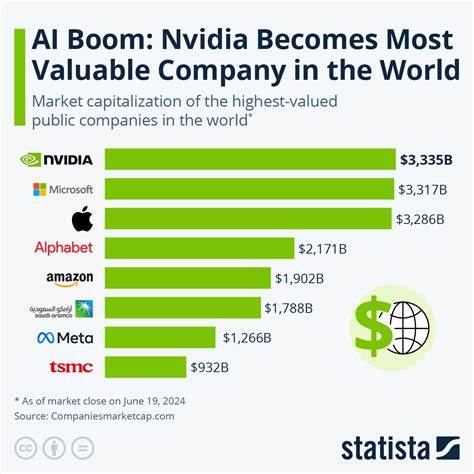

据Nvidia预测,到2028年全球数据中心资本支出将超过万亿美元。随着AI技术落地加速,企业对高效、低成本计算资源的需求与日俱增。特别是AI推理迅速成为市场主流,推理任务比训练任务对硬件的多样化和成本敏感性更强,这为专为推理设计的TPU芯片提供了广阔的发展空间。值得注意的是,AI推理的技术复杂度相对低于训练阶段,减少了对于Nvidia专有CUDA平台的依赖,使得更多企业愿意尝试和迁移到谷歌的TPU解决方案。 谷歌TPU的成本优势同样不容忽视。通过针对自家硬件和软件深度优化,谷歌能够实现更低的延迟和更高的能效,从而降低客户的整体运算开销。

在云计算定价日益成为客户选择关键因素的背景下,TPU的这一优势有望吸引更多企业用户,逐步蚕食Nvidia部分市场份额。 此外,谷歌与OpenAI的合作和互动,成为业界密切关注的焦点。作为AI领域的领头羊,OpenAI在模型研发和应用方面具备重要影响力。虽然目前OpenAI仅处于TPU测试阶段,尚未大规模部署,但其试用本身已充分说明谷歌TPU技术的可行性与竞争力。未来若OpenAI或其他顶尖AI团队选择广泛采用TPU,将对行业品牌认知及市场格局产生重大推动。 尽管如此,谷歌仍面临挑战。

Nvidia的技术积累、生态构建和客户基础异常坚实,且其CUDA平台已成为行业标准,这种“护城河”短时间内难以突破。此外,芯片设计及制造拥有极高门槛和复杂性,任何技术进步都需要巨额投入和长期规划。谷歌TPU虽然具备独特优势,但要实现规模化商业成功,还需不断完善技术和服务,强化市场推广力度。 总体而言,谷歌TPU代表了AI硬件发展的关键趋势,即更多企业倾向于采用垂直整合、专用定制的计算解决方案,以满足日益多样和复杂的AI任务需求。凭借技术创新能力,全面的云生态布局,和对推理市场的精准把握,谷歌正逐步从幕后走向台前,成为Nvidia在AI芯片领域不可忽视的新兴力量。未来几年,随着AI基础设施投入持续猛增,市场竞争将更加激烈和多元,谷歌TPU有望借助差异化优势,吸引更多客户,扩大市场份额,甚至显著重塑行业格局。

对于投资者和行业观察者而言,密切关注谷歌TPU的技术进展、客户动向以及市场反馈,能够更好把握AI芯片市场的未来走向。从长远看,AI与云计算的深度融合将引发新的技术革命与商业模式变革,谁能在硬件与软件的结合处抢得先机,谁就极有可能成为未来AI时代的最大赢家。