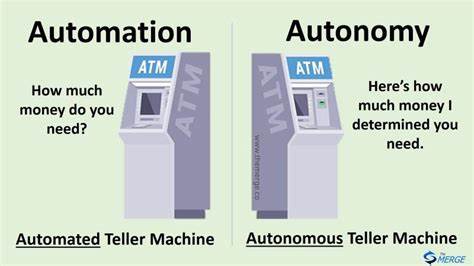

在人工智能迅速发展的当下,基于大型语言模型(Large Language Models,简称LLM)的自动化应用逐渐成为现实世界中各种需求的核心支撑。然而,如何有效地平衡模型的自主性和系统的可控性,成为开发者面临的一个重大挑战。针对这一难题,“Add Autonomy Last”作为一种新颖的设计理念,正在获得越来越多的关注。它主张先最大限度地利用传统编程的严密逻辑处理任务,再逐步向模型赋予适度的自主能力,实现稳定且可扩展的智能系统。本文将为您详解“Add Autonomy Last”背后的理念、其对比传统的“Autonomy First”策略的优势,以及如何将其应用于实际项目中构建更为可靠的智能助手。 大型语言模型赋能自动化应用的优缺点 大型语言模型以其强大的自然语言理解与生成能力在多个领域大放异彩。

从文本生成、对话机器人到复杂的数据分析,LLM都展示了令人惊叹的潜力。然而,充分发挥LLM能力的同时,如何确保模型输出的准确性与一致性,防止其发生误判或偏离任务目标,成为制约继续深化应用的关键障碍。 当前主流的编程思路倾向于“Autonomy First”——即让模型在程序中发挥最大的自主决策权,设计架构以辅助和引导其行为。例如通过丰富的上下文信息、工具接口、精细的提示词(Prompt Engineering)等方法赋予模型更大的功能空间。尽管这种方式在初期的功能实现上颇具魔力,但随着应用的复杂性与规模提升,诸多问题也逐渐暴露。程序行为常因模型切换而产生巨大波动,甚至出现信息幻觉或工具误用的情况,不仅影响用户体验,也大幅增加维护成本。

“Add Autonomy Last”的理念诞生了 为什么采用“Add Autonomy Last”思维则站在了不同角度。它强调在设计系统时,先用传统代码尽最大努力解决业务逻辑和数据处理的稳定部分,再留给模型自主操作的范围保持有限且清晰。换言之,程序大部分核心流程依赖确定性编程,模型仅在有限且可控的场景里发挥作用,从整体上降低不确定性和混乱的可能。这样的设计理念不仅有助于避免模型过度决策带来的问题,也让开发者能够更精准地监控和调试自动化任务的执行结果。 在实验中已经证明“Add Autonomy Last”可以带来更好的可维护性和一致性案例:打造具备记忆能力的聊天机器人Elroy 为了实践和验证“Add Autonomy Last”的有效性,Elroy团队尝试将其应用于开发一款具备记忆功能的聊天机器人Elroy。此机器人旨在帮助用户进行流畅、个性化的对话,同时能根据上下文智能调用历史记忆进行互动。

初期尝试中,团队采用了典型的“Agent”模式,令模型自动决定何时创建或检索记忆。然而,这样的方案在不同模型上表现波动极大,甚至在迁移到低调型号时,极易出现频繁且低效的记忆调用,严重影响体验和资源消耗。 在尝试“Model Context Protocol”(MCP)作为中间抽象层辅助记忆管理时,虽然简化了扩展方案,但依然存在模型决策不一致带来的问题。例如,模型可能频繁发起搜索请求,导致上下文乱序或信息堆积。 最终,团队决定将自动化自主权“后置”,即剥离出模型在何时记忆或检索的决策权,由外部程序逻辑统一调度。机器人接收到用户消息后,系统自动定时搜索相关记忆并将结果添加至对话上下文,每隔固定消息间隔再统一触发记忆写入操作。

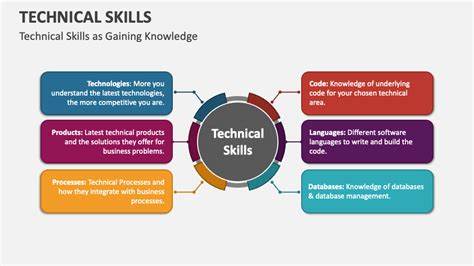

这一结构极大提高了行为的确定性和易预测性,减少了模型误操作,负载更加均衡也更易于调优。 “Add Autonomy Last”实现机制解析 理论上讲,“Add Autonomy Last”强调先用非LLM代码处理可预测、确定的业务逻辑,再将需要自然语言理解和生成的部分分配给模型。均衡方法具体包括:明确业务边界及岗位职责,清晰分割代码与模型的任务,例如由程序代码负责数据的读取、更新和事件调度,模型专注于语言生成和上下文分析。 该策略还注重自动化机制的设计。例如,记忆系统无需模型自行判断何时执行,统一由程序定时触发或基于统一规则操作。这样的封装降低了模型在流程管理的复杂度和错判概率。

同时,制定严格的调用协议和一致的接口规范保证模型输出的格式和行为可控。 此外,这种方法利于跨模型迁移。因为核心逻辑固定在代码中,替换为其他同类模型影响较小,减少了因模型特性差异而导致的行为波动。对开发者而言,调试和维护也因逻辑边界清晰而更加高效。 相较于“Autonomy First”,优势显著但并非适用于所有场景 不可否认,传统“Autonomy First”尤其在探索和原型设计阶段具有快速迭代和强大灵活性的优势。它适合那些任务定义不明确或强依赖模型创造力的用例。

但在系统进入稳定期及生产环境后,模型的过高自主性容易导致失控和维护困难。 “Add Autonomy Last”为构建可持续、可靠的生产级自动化系统提供了一条务实路径。它不追求赋予模型无边界自由,而是强调模型作为辅助发动机,而非主控核心。这种思维提升了应用的稳健性,降低了对深度提示工程的依赖。 未来展望:如何推动“Add Autonomy Last”成为智能系统设计主流 随着AI模型性能不断提升和应用场景日益复杂,“Add Autonomy Last”理念有望得到更多拥护。未来工具链中的开发框架和SDK或将提供更完善的“任务划分”与“自主权管理”机制,辅助开发者轻松实现代码模型协作。

同时,探索如何将自动化策略和模型能力动态调整结合,形成多层次自治框架,也成为潜在的研究方向。比如在核心流程中严格控制模型自主权,而在低风险的辅助功能里,让模型拥有更大自由度,实现兼顾灵活性与稳定性的最佳平衡。 总结来说,“Add Autonomy Last”以其合理分层、减少模型过度干预的设计思路,为基于LLM的智能自动化系统的未来发展铺就了一条稳健道路。它不仅提升了系统行为一致性和可维护性,也助力开发者更高效构建适应不同复杂度需求的解决方案。正如Elroy项目的成功示范那样,理性地延后赋予模型自主权,将成为智能自动化领域的宝贵经验和趋势。