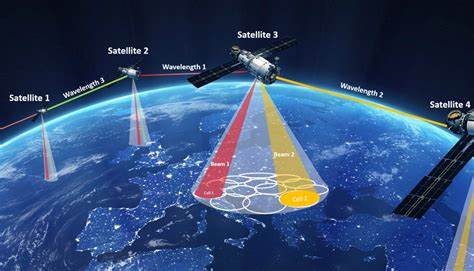

随着人工智能技术的迅猛发展,大型语言模型(LLM)在各行各业的应用变得愈发广泛。许多AI巨头纷纷宣称其模型支持百万级令牌的上下文容量,令业界为之一振,期待借此实现更复杂、更精确的语义理解和推理。然而,事实真的是如此美好吗?现实中,这些模型的准确性及推理能力在面对2千至4千令牌的上下文时已经有较佳表现,而超出该范围后,性能却面临显著下降。本文将围绕百万令牌上下文的现状,深入剖析背后原因,揭示长上下文处理带来的实际挑战,并探讨现实应用的可行方案。 大型语言模型之所以被寄予厚望,是因为它们能够同时处理大量文本信息,从而进行更复杂的语义推理、更精准的信息检索和生成释放。表面上来看,百万令牌上下文能够包含数量庞大的文档或对话内容,理应实现前所未有的长距离语义联系。

然而,根据2023年Liu等人的研究,当上下文长度突破数千令牌时,模型的表现开始急剧下降。2025年发布的NoLiMa基准测试更进一步验证了这一点,它指出虽然模型还可以处理较长文本的简单精确检索,比如查找完全匹配的字符串,但面对需要抽象推理的任务时,准确率显著下滑。举例来说,要求模型找到“哪些角色曾经去过德累斯顿”,即使“Semper歌剧院”这一事实被模型内置知识所掌握,但在冗长文本环境下,模型难以基于此推断出正确回答。这类“一跳”推理能力,在上下文增长时就已明显减弱。 为何长上下文对模型是个难题?本质原因可归结为模型核心机制中的“注意力机制”。注意力头通过向量投影判断某词与其它词的关联程度,而这本质上是一个模糊近似过程。

在较短文本(如数百至数千令牌)中,模型有较小的信号至噪声比,能清晰识别关键信息;但当文本扩展至上万令牌后,大量干扰信号会淹没真正的相关信号。类似于在一堆麦秆中找针,随着麦秆数量激增,找到那枚针的难度陡增。此外,注意力输出还经过softmax函数处理,在大量噪声环境下,softmax容易“模糊”原本应突出的高价值信号,导致模型关注点散乱。 除了机制本身的限制,模型训练阶段对上下文长度的局限同样制约了长上下文能力。许多现有模型主要以数千令牌上下文训练,直接扩展模型结构与训练策略以支持百万令牌步骤仍面临巨大计算与存储压力。与此同时,伪阳性率(false positive rate)问题也日益凸显。

在中长文本检索中,模型误判无关信息为相关的频次增加,实际有效信息与噪声的比例严重失衡,令模型生成的不确定性和无用内容飙升,这不仅影响理解,也使得系统运行效率降低。 从工程实践角度看,长上下文处理带来的问题同样严峻。比如在大型代码自动生成或复杂文档处理时,过长上下文常导致模型变得难以控制,频繁输出无关或重复内容,甚至无法维持合理逻辑连续性。这极大地妨碍了这些应用的商业化和普适推广。 面对上述现实困境,业内专家建议采取更加灵活的方案。首先,尽可能将任务拆解为若干短上下文片段,通过多次调用模型分别处理,再将结果整合。

虽然这种方法牺牲了直接整体理解的便利,但能显著提高准确性和响应可控性。其次,采用检索增强技术(retriever)、重排序器(reranker)和抽取式问答等辅助手段,有效缩减输入文本的规模与复杂度,保证模型专注于最相关的信息片段。此外,最前沿的研究也在尝试通过稀疏注意力机制、层次化编码以及参数共享结构等创新,逐步突破长上下文处理瓶颈。 为何长上下文实际问题常被忽视?这背后涉及产业和学术界的动力结构。商业模型发布时往往优先强调最大输入令牌数以吸引客户和投资者关注,实际精度并未同步披露,造成用户误解。学术领域则存在研究“易出成果”问题,简单题型的性能优化更易发表,难度高的长上下文推理挑战反而鲜有人问津。

而更为根本的是,习惯于已有范式的研究生态往往排斥提出重大质疑的新观点,导致长上下文能力上的“硬伤”难以得到充分重视和突破。 综合来看,尽管百万令牌上下文作为模型卖点吸引眼球,但其在语义理解和推理方面的实际表现尚未达到理想水平。未来要实现真正意义上的长文本深度智能处理,不仅需要算法创新,还需从系统架构、训练策略和应用设计等多维度协同发力。用户和开发者应理性看待大上下文规模的能力宣传,结合具体业务需求合理利用现有工具,同时关注新兴研究成果,期待长上下文技术不断成熟,推动人工智能进入更高阶的智能应用阶段。