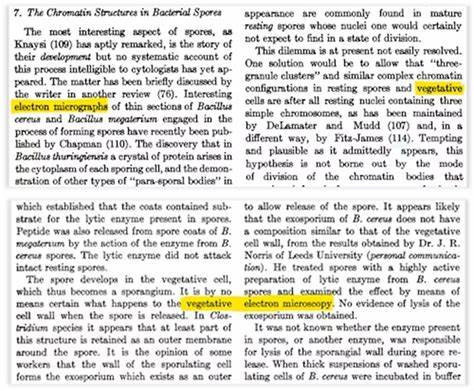

在当今人工智能高速发展的时代,基于海量数据训练的语言模型(LLM)越来越多地被应用于科研写作、内容生成及智能助理等领域。然而,令人意想不到的是,AI有时会输出一些听起来很专业却实则毫无科学依据的名词与概念,比如近年来引发关注的“植物电子显微镜”(vegetative electron microscopy)。这一完全不存在的术语竟然在不少科研论文和AI生成文本里屡次出现,这一现象令人深思:AI的“知识”到底从何而来?又该如何避免这种“数字化化石”对科学研究带来的潜在风险? “植物电子显微镜”这一无稽之谈最早由一位俄罗斯化学家发现于一篇已被撤回的论文中,随后引发软件工程师亚历山大·马加济诺夫的深入调查。经分析,他发现该术语极有可能源自上世纪50年代两篇论文在数字化扫描过程中的排版错误。具体来说,两列文字被错误地拼接,导致“vegetative”和“electron microscopy”合并成一个无意义的短语。 此类错误本身虽属偶发,但数字化文本往往被纳入互联网数据库,进而被集成进训练大型语言模型的数据集中。

因语言模型依赖于对出现概率最高的词汇组合进行预测,这一错位的搭配便被“学会”并反复输出,仿佛它是一个真实存在的科学名词。从而导致AI在提供科研参考或写作辅助时,误将虚假信息“传染”给更多研究者。 昆士兰科技大学(QUT)的研究团队利用多轮AI模型测试,证实了“植物电子显微镜”作为一种“数字化化石”确实存在于GPT-3.0的训练数据中。这类隐秘存在的数据瑕疵提醒我们,AI模型虽然看似智能,但其实不过是基于统计概率的语言预测机制,缺乏真正的理解力和常识判断。 “数字化化石”是QUT团队提出的一个全新概念,指那些因历史错误、排版污染或恶意数据而留存在训练语料库中的异常文本片段。它们像化石一样被嵌入在语言模型的“知识”中,成为未来文本生成中的隐患。

随着更多来自互联网、维基百科、论坛帖子乃至AI自身生成的文本被重新用作训练数据,这类“数字化化石”将不断积累并可能演变成更复杂的错误。 以往AI输出的荒谬建议,如让用户在披萨上涂抹胶水或鼓励“每天吃一块石头”,都可以追溯到某些训练数据中的恶作剧或胡言乱语。语言模型无法分辨内容的合理性与否,它们只是为了生成上下文合理的文字串而努力,因此过度依赖大量未经严格筛选的数据集可能导致更多“数字化化石”被当作知识传播。 这一现象不仅是学术研究的笑话,也可能带来实际风险。以网络安全为例,如果AI生成的代码中掺入了源自“数字化化石”的漏洞或无害但迷惑的代码片段,这些瑕疵代码可能被人恶意利用,造成系统安全隐患。漏洞若未被人工审查及时发现,便会在AI辅助编码的工具中反复传播,进一步放大危害。

针对这一问题,研究人员呼吁提升训练数据的透明度与审核机制。虽然大型AI公司通常为了保护商业机密不愿披露训练细节,但共享更多训练数据来源及筛选策略,有助于社区发现并纠正数据中的瑕疵。QUT团队通过将历史文献片段输入不同版本的语言模型,并观察何时开始输出错误短语,成功定位了“植物电子显微镜”被引入的时间节点,这为诊断类似“数字化化石”提供了方法论。 然而,依靠事后检测来修补错误显然无法消除所有潜在风险。随着越来越多AI生成的文本被反复用作新模型的训练数据,数字化化石释出的毒瘤效应可能愈演愈烈。究其根本,增强AI训练数据的质量控制、设计具备错误识别与自我纠错能力的模型架构至关重要。

面向未来,AI技术的发展必须结合人类专家的知识审核,不能纯粹依赖自动化的海量数据采集。建立多层次、可追溯的数据治理体系,阻止数据污染成为训练语料的源头,是维护AI输出可靠性的关键步骤。在 AI 越来越多地参与科学研究、教育和决策的语境下,确保模型结果的准确性和合法性势在必行。 总的来说,“植物电子显微镜”这一看似无伤大雅的“科学术语”错误,却暴露了大型语言模型训练中深层次的数据治理挑战。它提醒我们,AI虽强大,但仍是一面映照人类认知局限与技术不足的镜子。未来,要想真正发挥AI的潜力并降低风险,技术开发者、科研人员与监管机构必须紧密协作,致力于构建透明、可控且高质量的AI训练生态系统。

如此方能避免荒诞的虚假信息不断被复制和放大,保障人工智能为人类社会带来更多正面价值。