近年来,人工智能技术,特别是大型语言模型(LLM),正在快速改变各行各业的工作方式。从软件开发到内容生成,语言模型的应用愈发广泛。许多人意识到将这类强大的模型本地运行带来的优势,无需依赖云服务,降低延迟,保护隐私,同时还能获得更好的使用体验。利用开源技术在个人电脑上部署和运行大型语言模型,已成为一个新兴且值得关注的方向。 对于苹果Mac用户来说,尤其是搭载了M系列处理器的设备,尝试在本地运行大型语言模型的条件更加成熟。得益于苹果在硬件性能和MLX框架方面的优化,机器学习模型在Apple Silicon芯片上运行速度更快,效率更高。

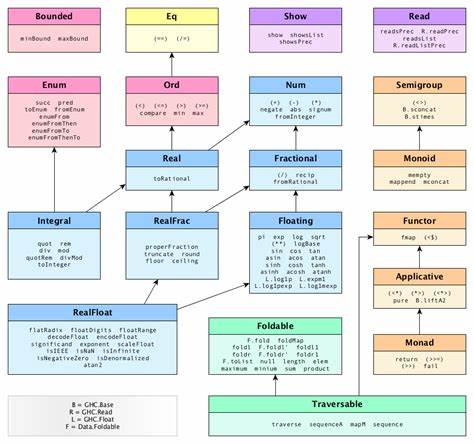

利用这些软硬件优势,用户可以不用高成本的服务器即可完成复杂的AI计算任务,实现真正意义上的个人AI。 在开始搭建本地环境之前,首先需要了解并安装一些关键工具。例如,uv是一个高性能的Python包和项目管理器,其用Rust语言编写,因其速度和简洁性被广泛推荐。安装uv非常方便,只需一条简短的命令即可完成,这为后续安装和管理AI相关的Python库打下坚实基础。 安装好uv后,接下来可以通过它来安装Simon Willison开发的llm命令行工具包,这个工具让用户可以更便捷地调用和管理大型语言模型。值得注意的是,选择与系统兼容的Python版本尤为重要,例如在一些插件依赖方面,目前3.12版本支持较好,而最新的3.13可能还存在兼容性问题。

成功安装llm后,Mac平台用户还应安装llm-mlx插件,该插件基于苹果的MLX框架,专门为Apple Silicon做了针对性优化,使得语言模型能够以更高效的方式运行。 如果使用的是Windows设备,则可以跳过MLX相关步骤,转而使用Ollama等工具进行模型下载和管理,同时安装对应的llm-llama插件以兼容系统环境。不同操作系统之间虽然有些细节差异,但整体流程相似,用户只需根据自身设备选择合适的方案即可。 模型的下载同样非常简便。llm命令行提供了便捷的下载接口,例如可以从mlx-community社区获取到诸如Llama-3.2-3B-Instruct-4bit等优化版本。这些模型经过量化和调优,既保证了推理的准确度,也极大降低了硬件需求,尤其适合本地设备的运行。

部分模型体积大,需要占用较多的磁盘空间和内存资源,用户应提前做好规划。 安装完成之后,通过简单的命令,用户可以立即体验AI带来的乐趣,比如让模型讲个笑话,模型会返回相应的回答。虽然AI的幽默感可能还略显“爸爸笑话”风格,但这样的交互体验足以展现其潜力和趣味。除了单次提问,llm还支持聊天模式,用户能够与模型保持连续的对话交互,直到选择退出。这种模式与在线聊天机器人类似,极大地提升了用户体验和实用性。 在不断探索本地运行语言模型的过程中,用户还可以尝试不同的模型版本,比较其性能和输出质量。

mlx-community社区提供了丰富多样的模型资源,如大小适中、适合桌面设备运行的Qwen3-4B-4bit模型等,用户根据需求灵活选择,有助于提升工作效率或丰富娱乐体验。 搭建本地大型语言模型不仅对普通科技爱好者具有吸引力,对于开发者和企业用户而言,更是探索AI产品原型和定制化服务的绝佳方式。用户可以将本地运行的AI集成到自己的应用中,实现嵌入式智能助理、自动化工具,甚至用于构建搜索增强生成(RAG)系统。 业内知名开发者和博主Simon Willison在其博客中分享了大量关于本地部署和AI工具链构建的宝贵经验,其深入剖析了如何结合Claude、Datasette和Val Town等技术框架,实现基于大型语言模型的高效工具开发。关注并学习这类前沿内容,将帮助用户快速提升技术储备,掌握最新的AI技术趋势。 遇到困难时,在线社区和开源项目文档也是极好的资源。

比如对于Python环境的配置、依赖库版本兼容以及模型优化技巧,都有丰富的讨论和指导。通过不断积累实践经验,用户可以逐步实现更加稳定和高效的本地AI运行环境,满足日益增长的个性化需求和数据安全考虑。 本地运行大型语言模型的兴起,标志着人工智能逐渐从大型云端平台走向个人电脑和边缘设备。这种趋势不仅推动了技术的普及和创新,更增强了用户对数据隐私的自主权。未来,随着硬件性能提升和模型优化技术不断进步,本地AI助手将成为每个人日常生活和工作的重要组成部分。 总之,搭建和运行本地大型语言模型已经不再是遥不可及的梦想。

只需掌握合理的工具链,选择合适的模型版本,并利用硬件的优势,任何人都可以实现自己的AI助手。持续关注相关开源社区和技术分享,将助力大家站在AI技术最前沿,开启属于自己的智能时代。