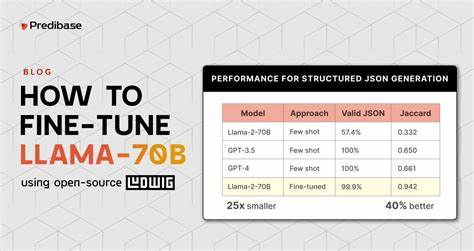

随着人工智能技术的不断进步,语音转录和文本分析领域也迎来了崭新的发展机遇。传统上,处理复杂的语音转录文本往往依赖于大型通用语言模型,这些模型虽然功能强大,但对硬件资源的要求极高,且在隐私保护和实时处理方面存在一定限制。近日,一项突破性的工作通过微调Llama 3.2 3B小型模型,实现了本地语音转录的自动清理和结构化分析,其表现甚至可媲美规模达到70B参数的大型模型。这一进展不仅彰显了小型专用模型的潜力,也为语音转录处理领域带来了新的思路。微调Llama 3.2 3B模型的核心目标是实现配合本地语音转录的高效整理,能以结构化JSON格式输出所需信息,包括标题、标签、实体、日期及后续行动项等。作者利用LoRA(低秩适配)技术在一张RTX 4090显卡上仅用时4小时完成训练,显著提升模型在专门任务上的表现,其整体评估得分由基础模型的5.35跃升至8.55,超越市面上多款参数量远超自身的12B至70B大型通用模型。

该模型的训练数据来源于作者自身语音备忘录应用中获得的真实转录文本。通过使用业界先进的"teacher"模型Kimi K2生成标准化的标注JSON输出,形成了高质量的"金标准"数据集。同时,作者利用脚本自动拓展生成超过4万条具有代表性的合成语音转录数据,使训练数据规模大幅增长且内容贴合实际应用场景。训练过程充分利用了Unsloth训练框架,特别在数据预处理上做了JSON键排序规范化,保证模型在生成时不受顺序问题干扰,最终采用LoRA技术完成参数调整,极大地缩短了训练时间并节约计算资源。训练参数方面,作者设置了128维的lora_r和lora_alpha,搭配0.05的dropout防止过拟合,并采用cosine学习率调度策略,整个模型训练仅进行了一轮(epoch=1),确保快速迭代和及时反馈。微调完成后,模型以HF预训练权重和LoRA适配器整合为单一GGUF格式模型,同时进行了4-bit的Q4_K_M量化,支持在本地轻量化推理环境LM Studio中高效运行,方便开发者及终端用户直接使用。

推理示例显示,该模型不仅能够准确提取关键日期、人物和组织实体,还可以自动归纳总结事件要点,生成简明的行动清单及相关问题,极大提高了语音备忘录后续处理的效率和准确度。更为重要的是,在针对100个验证样本的多项指标评测中,微调模型在完整性和事实准确率两个核心维度均取得显著提升,分别由4.12和5.24提升至7.62和8.57,表明模型有效降低了"胡编乱造"现象,确保输出内容切实可靠。作者还将其微调模型与行业内部分更大规模的全通用模型进行了评测对比。令人惊讶的是,这个3B参数量的专用模型以平均8.40分的成绩排名第二,甚至超过了多款14B至70B的模型,仅次于其老师模型Kimi K2和70B规模的Hermes模型。该结果客观验证了规模并非决定性因素,任务专用型微调模型在精细化领域应用中具备不可小觑的竞争力。这一发现对希望在本地环境实现高效语音数据处理的用户及开发团队具有重要示范意义。

传统依赖云端API的大型模型固然强大,但存在潜在的隐私风险和高昂的使用成本。微调小型模型则提供了一条可控、实用且省钱的替代路径,适合需要高度定制和紧密集成的应用场景。总结来看,这次基于Llama 3.2 3B模型的微调项目不仅推动了语音转录清理与分析技术的本地化发展,更在实际应用中证明了小而专的模型策略拥有可比肩甚至超越大规模通用模型的潜力。面向未来,随着微调技术和数据合成手段日益成熟,越来越多专业化小模型将应运而生,满足行业对高效、私密及准确文本处理的多样需求。如果您正在寻找一种既高效又具备本地部署可能的语音转录解决方案,不妨关注专门微调的轻量级模型,开启属于自己的智能文档处理新时代。 。