近年来,强化学习(Reinforcement Learning, RL)领域迅猛发展,特别是策略优化算法中的PPO(Proximal Policy Optimization)因其稳定性和高效性备受关注。传统的PPO智能体往往专注于一种策略优化路径,通过与环境交互不断改进策略以实现任务目标。然而,随着应用场景复杂性的增加,单一认知策略难以满足智能体在多样化环境下的应对需求。因此,研究者提出了在PPO智能体内部引入多认知功能切换机制的创新思路,从而极大提升智能体的灵活性和决策水平。理解这一机制的核心,需要从认知功能的定义出发。认知功能通常指智能体在感知、记忆、推理和决策等多个维度上的处理方式。

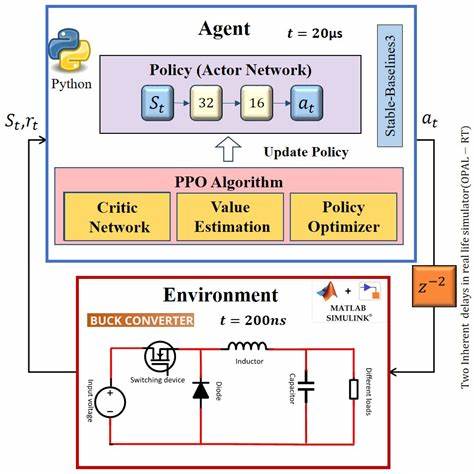

每一种认知功能对应不同的策略表现和信息处理方式。例如,有的认知功能可能偏重经验的快速复用以做出反应,有的则注重对环境状态的深入分析以预测未来走势。在PPO框架内,智能体能够依据当前环境状态与任务需求灵活切换不同认知功能,这种切换不仅提升了策略的多样性,也促进了策略的互补和优化。技术实现层面,PPO智能体通过设计一个上层的控制机制,动态判断当前环境状态和历史经验,从而选择最适合的认知功能模块执行动作决策。该控制机制通常借助元学习或策略集成技术,实现对多个子策略的协调管理。这种方法打破了传统单一策略固化的问题,使得智能体能够在面对复杂、不确定环境时表现出更多维度的适应性。

例如,在某些高动态且信息噪声较多的任务场景中,快速反应的认知功能可以迅速引导智能体避免风险;而在任务对长期规划和复杂推理要求较高时,另一个注重深度分析的认知功能则能够发挥关键作用。通过PPO算法的迭代优化过程,不同认知功能间的切换趋于平滑且高效,避免了频繁切换导致的决策混乱和资源浪费。实践应用层面,具备多认知功能切换的PPO智能体在机器人控制、多智能体协作、复杂游戏及无人驾驶等领域展现出显著优势。它们不仅能提升任务完成率,还能增强对环境变化的适应能力,有效降低训练难度和时间成本。同时,该机制为未来智能体扩展到更广泛认知模块提供了技术基础,使人工智能系统更加接近人类多样化思维方式。然而,多认知功能切换的PPO智能体也面临一定挑战。

首先是认知功能模块的设计与优化需要深厚的领域知识和强大的计算资源支持,其次切换机制的可靠性和稳定性仍需深入研究,确保在复杂环境下的长时稳定运行。此外,如何平衡多个认知功能之间的优先级和资源分配,防止某一认知功能长期占据主导成为瓶颈,也是当前亟待解决的问题。展望未来,将PPO与多认知功能相结合的智能体有望在人工智能领域开启全新篇章。通过不断完善认知功能模块和切换策略,智能体将更加智能、灵活,能够适应更加动态复杂的环境需求。与此同时,结合深度学习、元学习以及神经符号系统等多种技术,将使多认知功能PPO智能体的应用范围和性能持续突破。总结来说,PPO智能体通过切换多种认知功能,有效提升了在多样化环境中的适应性和任务处理能力。

这种模式不仅突破了传统策略单一的局限,也为实现更具人类智能特征的机器学习系统铺平了道路。随着技术的不断进步,未来基于多认知功能切换的PPO智能体将在智能机器人、自动驾驶、复杂系统优化等多个领域展现无限潜力,推动人工智能向更高水平迈进。 。