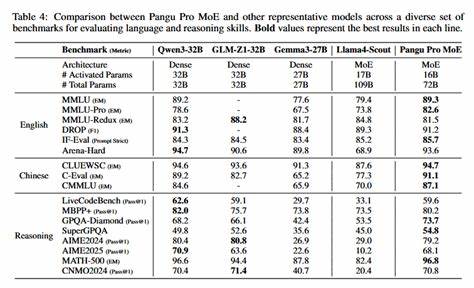

近年来,人工智能技术飞速发展,越来越多的企业纷纷投入资源打造属于自己的大型模型。华为作为中国科技领域的重要代表,其推出的盘古Pangu Pro MoE模型备受关注。业内普遍认为,盘古Pangu Pro MoE模型在设计与实现上,极有可能基于国内领先的Qwen模型进行迭代和创新。了解华为盘古Pangu Pro MoE模型的技术传承以及创新点,不仅有助于深入理解华为在AI领域的核心竞争力,也为整个行业的发展带来启示。 首先,盘古Pangu Pro MoE模型所在的MoE(Mixture of Experts)架构,是近年来深度学习模型领域中备受推崇的设计思路。MoE模型通过引入多专家机制,能够让模型在不同任务或场景下动态选择最合适的专家子网络,从而更高效地处理复杂信息和多样化需求。

同时,MoE架构的大规模参数分配能力,使得模型在保持性能的同时还能够降低计算消耗,这种设计理念与传统的单一大型模型相比,展现出更好的扩展性与灵活性。 Qwen模型作为中国领先的AI基础模型之一,以其强大的语言理解和生成能力闻名。华为采用Qwen作为盘古Pangu Pro MoE模型的技术基础,充分利用其训练经验和结构优势。Qwen模型多层次的参数调优机制、丰富的预训练数据集以及先进的优化算法,为盘古模型提供了坚实的技术支撑。基于Qwen模型的深厚基础,盘古Pangu Pro MoE实现了在自然语言处理、多模态理解等多个领域的精准表现。 华为盘古团队在将Qwen模型技术传承至Pangu Pro MoE中,重点突破了模型的规模扩展和数据多样性问题。

盘古模型引入了更大规模的专家子模型,并结合智能路由机制优化专家之间的调度效率,使模型能够针对具体任务选择适配度最高的专家,从而实现更精准的推理和更低的资源消耗。此外,华为通过自主研发的分布式训练框架,提高了训练效率和模型的可扩展性,为打造更多领域定制化模型奠定基础。 在实际应用层面,盘古Pangu Pro MoE模型凭借其强大的泛化能力和灵活性,已经开始在智能问答、语音识别、机器翻译、图像理解等多个方向展现优势。尤其是在企业服务、智慧城市、自动驾驶等场景下,盘古模型的多专家体系能够更好应对复杂、多变的环境需求,为用户提供更精准、高效的AI解决方案。未来,随着更多算法优化和训练数据的积累,盘古Pangu Pro MoE有望在提升多模态融合能力和跨语言理解方面实现更大突破。 技术迭代带动产品升级,华为对外也多次强调开源与合作的重要性。

盘古Pangu Pro MoE背靠Qwen模型技术积累,不仅是华为内部技术创新的体现,也为中国乃至全球的AI生态系统注入新动力。华为通过积极参与国际标准制定、推动开源社区建设等举措,努力营造协同创新环境,促进基础模型的持续升级与应用扩展。 总的来看,华为盘古Pangu Pro MoE模型作为当前国内最具代表性的MoE大模型之一,有着Qwen模型深厚的技术积淀和创新发展路径的继承。其多专家架构、多领域适配、智能调度机制及高效训练能力,极大地提升了模型实际应用价值和商业潜力。未来,随着人工智能持续加速渗透到各行各业,盘古Pangu Pro MoE模型将在推动产业智能升级和数字化转型中发挥关键作用,助力华为在全球AI竞赛中占据领先地位。