在当今数字化快速发展的时代,人工智能(AI)已经渗透到我们生活的方方面面。随着物联网(IoT)设备的普及,AI系统几乎控制了我们周围的环境。目前全球已有超过150亿个物联网设备连接,而这一数字预计在2030年前将翻倍。这样的演变无疑为我们的工作和生活带来了便利,但与此同时,它也带来了诸多挑战,尤其是在网络安全领域。 人工智能的发展为网络安全提供了新的可能性。AI可以通过分析海量数据、识别异常模式和自动化响应过程,显著提升网络防御能力。

AI能够学习和适应新出现的网络威胁,从而在保护数字环境方面发挥重要作用。比如,AI可以及时识别并应对潜在的网络攻击,减少人为干预的需求。然而,尽管AI拥有这些强大的功能,它绝不能完全取代网络安全专家的角色。 网络安全领域的复杂性和多样性意味着,仅依靠人工智能是远远不够的。首先,AI系统本身也可能成为恶意行为者的攻击目标。随着技术的进步,AI系统可能以意想不到的方式行动,有时甚至会泄露私人和敏感信息。

这就需要专业的网络安全专家进行监督,以确保AI系统的安全性和可靠性。 AI驱动的安全解决方案虽然能够提高检测效率,但也可能会产生大量虚假警报。这会对信息安全人员造成额外的负担,让他们在面对真正的威胁时可能出现遗漏。例如,系统可能会因为误判而触发无数警报,迫使安全团队耗费大量时间在不必要的调查上,这样反而会削弱他们对真正威胁的响应能力。因此,AI与人工监督之间的平衡显得尤为重要。 未来,AI系统的进一步发展将带来新的挑战。

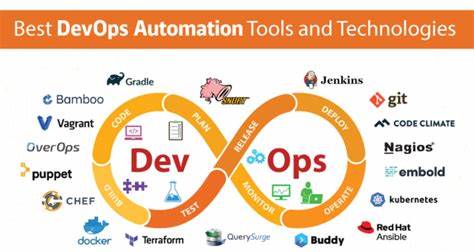

随着这些系统的相互连接,它们将形成一个更为庞大的智能网络,类似于一个巨大的生态系统。这种分散的AI网络会改变我们对安全的传统理解。当大规模的去中心化AI管理一切时,谁来控制这些AI系统显得至关重要。确保AI既被信任又值得信赖,将成为我们未来发展的关键。 为了应对这一挑战,政府和相关机构正在制定相应的政策。例如,欧盟在2024年通过的《人工智能法》正是这样的努力之一。

该法禁止某些高风险的AI应用,如某些生物识别和面部识别系统、社会评分机制,以及对个体进行操控或剥削的AI。这项立法要求对关键领域(如基础设施、教育和就业)中的高风险AI系统进行风险评估、透明度和人工监督,旨在平衡创新与安全的关系。 然而,许多企业担心这将可能抑制创新与竞争力,而社会团体也批评其未能充分解决道德问题。因此,在未来的发展过程中,需要在促进技术进步与确保使用安全之间寻求平衡。这就需要政策制定者和法律制定者具有深刻的理解,能够同时认识到AI的潜在利益和相当大的风险。 AI的快速发展也在改变我们对网络安全专家的需求。

未来的网络安全专家不仅仅需要具备传统的IT技能,还需了解AI的基本原理和应用。人类专家能够在复杂情况下做出判断,分析AI系统的行为,并在需要时对AI的决策进行纠正。如果我们过度依赖于AI,而忽视人类专家在判断、情境理解和道德考量上的重要性,可能会导致严重的后果。 在AI与网络安全的交集处,人才的培养显得尤为重要。教育机构、高校和企业应共同努力,培养能够驾驭这一新技术的人才。这不仅包括技术人员的培训,还需要加强伦理和法律方面的教育,使未来的工程师和科学家在推动技术发展的同时能懂得如何负责任地使用这些技术。

此外,企业应定期进行网络安全演练,模拟各种可能的网络攻击情景,以提高团队在真实事件中的反应能力。通过这些演练,员工能更好地理解AI系统的工作原理,也能增强人们对于AI系统检测到的警报的敏感度,优化人工智能与人类之间的协同工作。 总之,尽管人工智能在提升网络安全方面展现了巨大的潜力,但它绝不是万能的。人类专家的知识和经验依然无法被替代。未来的网络安全工作需要人工智能和人类专家之间进行深度的合作和融合,以应对日益复杂的网络威胁。在这一过程中,我们不仅要关注技术本身,还应重视技术的伦理框架与政策监管,确保在追求创新的同时不失去对安全和责任的把控。

。