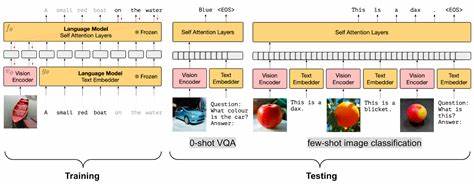

近年来,视觉语言模型(Vision Language Models,简称VLMs)因其多模态理解与推理能力在人工智能领域引发广泛关注。然而,尽管大型语言模型(LLMs)在诸如数学推理和代码生成等复杂任务中展现出卓越表现,能够完整通关真实世界视频游戏仍然是一项极具挑战性的目标。VideoGameBench作为一项研究预览,正是针对这一难题而设计的基准测试,它为视觉语言模型提供了评估其在多样化游戏环境下实时完成任务能力的统一平台。VideoGameBench以经典的Game Boy和MS-DOS平台的20款流行旧游戏为样本,涵盖了从3D射击到策略、平台跳跃、解谜等不同类型的游戏,旨在评估模型对复杂空间推理、长期规划与视觉理解的综合能力。该基准拒绝依赖辅助信息,如游戏内事件标注和文本解析,而仅以游戏原始画面作为观察输入,极大地贴近人类玩家的真实游戏体验。这种设计鼓励模型自主识别游戏中的动态变化和策略目标。

传统利用强化学习(RL)训练的游戏AI通常依赖海量探索数据和专家示范,专注于单一游戏的深度掌握。相比之下,VideoGameBench尝试借助视觉语言模型的通用推理优势,实现跨游戏多样性的适应能力。它旗下的VideoGameBench-Lite版本则通过暂停游戏环境等待模型决策,突破了当前VLM推理延迟带来的动作滞后难题,进一步支持深入分析模型思考过程。VideoGameBench的设计考虑到了多种操作机制、输入复杂度和视觉风格的差异,例如经典的《毁灭战士》《文明》《超级马里奥奥德赛》等游戏均被纳入测评体系,使得该平台兼具普适性和挑战性。研究初期的实验表明,尽管模型如GPT-4o、Claude Sonnet 3.7及Gemini系列展现部分局部技巧,但尚未完成任何游戏的完整通关,甚至连首个关卡都存在困难。这反映出现阶段视觉语言模型在实时感知、准确动作执行及游戏机制理解方面仍处于发展初期。

具体来说,模型在识别真实游戏动态时常误判静止或已击败的敌人状态,导致资源浪费和战略失误;同时,受限的响应速度使得关键操作无法及时调整,暴露出实际应用中的系统瓶颈。此外,对于鼠标和键盘操作的精细控制能力也是障碍。策略与动作的时效性缺失加剧了游戏体验的不连贯,使模型难以针对不断变化的游戏环境做出适当反应。VideoGameBench的开源框架还为开发者提供了友好的接口,通过对游戏控制器输入的统一抽象,使得在这一平台上快速集成新游戏成为可能。可配置的环境设定和行动序列支持灵活定制,从而拉近研究者与不同游戏类型间的差距。更重要的是,VideoGameBench的设计理念提倡开放协作,呼吁社区贡献更多游戏及模拟器的支持,共同推动视觉语言模型在实际游戏智能领域的进步。

过往强化学习体系在经典游戏中的成功路径,如《Atari》系列、《星际争霸2》以及《围棋》AI的突破,均依赖于对游戏状态的准确理解和对策略空间的深度搜索。VideoGameBench则代表了新兴多模态AI技术愿景的具体实践,即通过融合视觉感知与语言推理,实现无需游戏专家数据即可动态、灵活地应对复杂游戏环境的目标。当前模型表现虽有限,但也揭示出多模态认知架构的巨大潜力。通过诸如ReAct框架结合记忆机制的初步Agent,能够在部分游戏中实现简单的策略尝试和目标导向行动,表现了人工智能在模仿人类游戏理解上迈出的重要一步。未来,随着模型计算效率的提升、推理算法的优化以及跨模态学习的深化,视觉语言模型有望克服实时交互延迟、精准动作执行和复杂策略推导的瓶颈,逐渐实现对真实世界游戏的全面掌控。此外,VideoGameBench为研究人员提供了一个重要窗口,不仅能横向比较不同模型及代理的游戏表现,还能纵向追踪模型智能演化的轨迹,促进多领域交叉创新。

借助更丰富的游戏情境和强化学习结合,视觉语言模型或将成为新一代多任务智能体的典范,推动人工智能从理论走向更贴近人类认知的实践层面。综上所述,VideoGameBench不仅是视觉语言模型技术评估的重要里程碑,更是连接游戏AI与通用人工智能研究的桥梁。它用实际视频游戏这一生动多变的测试环境,挑战并激发了视觉语言模型在理解、计划、执行等多方面的能力极限。随着基础设施和算法的持续完善,未来视频游戏不仅是娱乐消遣场所,更将成为多模态智能体探索与进步的试验田,推动人工智能迈向更高效、更智能的新时代。