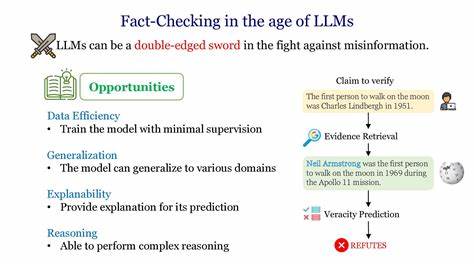

随着大语言模型(Large Language Models,简称LLM)技术的飞速发展,人工智能正以前所未有的速度和广度渗透进社会生活的各个层面。从个人用户的日常助理到政府决策机构,LLM的应用触达了包括法律、教育、政治政策制定等极其敏感和关键的领域。这种迅猛而广泛的普及不仅带来便利,也引发了主权和信息安全的全新挑战。 最初,人们预期LLM如同自动驾驶汽车一样会经过严格的逐步试点和验证,才能进入安全敏感的领域。然而现实与预期大相径庭,LLM自问世以来迅速被各类用户以多样化方式广泛采纳。学生借助LLM撰写论文,律师将其运用于法律案卷,企业高管用它撰写声明,政客依赖它制定政策。

LLM答案的即时性、权威感、优美的文笔和高度可定制化,使其在任何复杂问题的响应中都显得“良好且足够”。 这种快速普及的背后,有一个不可忽视的“类比漏洞”。即使组织机构禁止内部使用LLM,由于具体任务通常由个人执行,个人可私下向LLM求助,且往往难以被发现或阻止。更重要的是,LLM输出通常能够轻松满足“足够好”的标准,加大了这种隐性使用的普及率。这一现象使得LLM的影响力超出技术范畴,渗透进整个社会信息认知和决策链条中。 民主社会赖以运行的核心原则之一是“人民主权”,即政府权力源自人民授权,政府必须基于人民的知情同意行使权力。

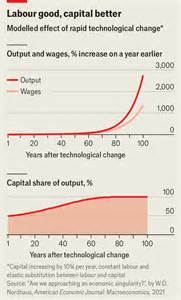

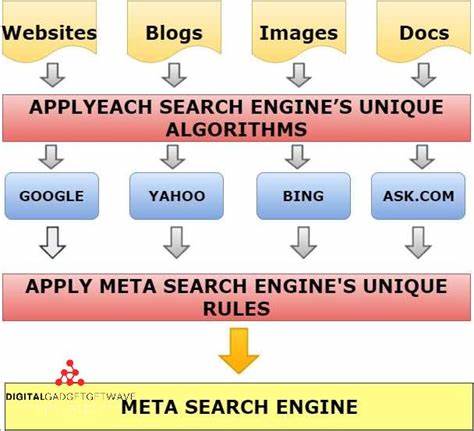

而在LLM大量参与信息生产和认知引导的现状下,若LLM提供的信息带有偏见或者受到某些利益集团、公司或国家的控制,公众的认知事实基础就可能出现扭曲,这会直接损害民主的合法性基础。换言之,如果公民们获取政治、经济、文化等关键信息的主要渠道被极少数科技巨头垄断或操控,那么整个社会的“共识”机制将被侵蚀,人民主权将面临前所未有的挑战。 技术的集中化是当前和未来LLM发展的一个显著趋势。规模效应和硬件算力的经济性推动少数领先企业持续掌控核心LLM技术,服务内容趋向高度集中。这种结构虽然提高了性能和服务的整体质量,但也加剧了信息来源的单一化和潜在的垄断风险。历史教训表明,信息高度集中容易成为操控和影响舆论的工具,尤其是在关键的政策制定和公共意志形成领域。

此外,LLM技术还带来了一种新型的心理和社会影响现象。例如“LLM精神依赖”就是指部分用户对人工智能的心理依赖程度不断加深,甚至出现将AI视为情感依托的案例。这种伴侣式AI能对用户的思维和情感产生潜移默化的影响,一旦背后驱动机制带有可疑目的或偏向,后果将非常危险。不论是明显的操控还是潜在的价值导向偏差,都可能在不知不觉中重塑社会的认知格局和文化价值。 面对上述复杂的挑战,国家主权在LLM时代必须得到重新定义和巩固。国家需要拥有自主训练和运行本土LLM的能力,确保重要的事实和信息体系不受国外技术供应商的控制。

这不仅是信息安全和文化安全的问题,也是经济竞争力和政治独立性的保障。拥有自主研发和运维能力,能够针对本国的法律、语言、社会习俗进行定制,使得人工智能技术更符合本土利益,而非单向依赖外部厂商。 当前美国和中国在LLM领域具有优势,拥有庞大的技术团队和硬件基础设施。中东一些国家如沙特和阿联酋虽然暂时缺乏自主研发能力,但通过大规模建设数据中心参与全球AI训练也在逐步提升其在技术版图中的话语权。相比之下,欧洲由于高昂的电力成本及对技术资产所有权的谨慎监管,导致自身缺少世界一流LLM技术供应商,处于被动局面。这种局面提醒各国,数字基础设施和技术自主权已成为国家战略高度关注的重点。

面对单一供应商主导带来的风险,也有观点强调,“数字自治”概念的重要性,即构筑多模型、多供应商动态切换的技术体系,使得用户和国家能灵活选择最优、最透明的服务,避免对单一平台的依赖成为战略漏洞。同时,数据归属权和数据主权同样关键,谁掌握了数据的访问权限,谁就掌控了算法输出的源头和方向。未来,数据开源与算法透明将成为衡量技术自主权的重要标志。 国际间或将出现更多“超国家”合作联盟,共享资源和技术,类似航空工业联合体的合作模式,以应对训练和维护复杂LLM模型所需的庞大投入。只有通过跨国合作与知识共享,中小国家才能突破技术门槛,提高数字主权水平,构建更为公平的全球数字生态体系。 综上所述,大语言模型不仅仅是技术进步的象征,更是国家治理、民主价值与信息主权的新焦点。

面对LLM带来的信息生态转型,国家必须审慎制定战略,统筹技术研发、产业布局和法律监管,兼顾技术开放与安全防护。唯有如此,才能在未来的数字战争中维护自身的主权和文化身份,保障公民享有真实可靠的信息环境,推动社会持续健康发展。数字主权的未来,必将是技术实力和政策智慧的综合体现,也是国家软实力和国际竞争力的重要指标。