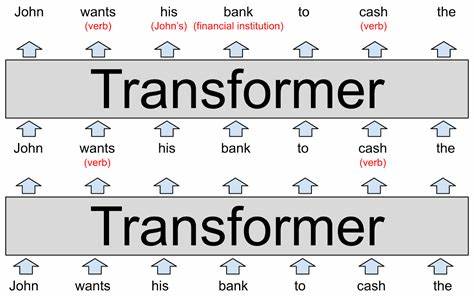

随着人工智能领域的飞速发展,基于变换器(Transformer)架构的大型语言模型(LLMs)在自然语言处理(NLP)任务中展现出卓越的性能和广泛的应用前景。然而,尽管这些模型功能强大,但如何对其行为进行细粒度控制,始终是研究人员和工程师面临的重大挑战。为了实现可控且安全的文本生成,学界逐渐探索出一系列对变换器模型进行"黑客式"操作的方法,主要集中在提示工程、激活状态干预和权重编辑三个核心层面。本文将深入解析这些技术手段的原理与应用,助力您理解如何灵活驾驭大型语言模型,提升任务效果及模型安全性。 首先,提示工程作为最直观的操控方式,已被广泛使用于调整模型输出方向和内容。通过精心设计的输入提示,用户可以诱导模型产生符合预期的文本,例如指定情感倾向、控制话题范围或引导模型生成特定格式的内容。

提示不仅影响模型的初始文本理解,还能在一定程度上塑造模型的生成过程,是无需对底层参数做出修改的轻量级干预策略。随着自动提示生成和优化算法的不断发展,提示工程在提升模型表现和增强交互体验方面展现出巨大潜力。 然而,纯粹依赖提示工程存在一定局限,比如受限于模型预训练范围,提示设计复杂且易受噪声影响。针对这些问题,研究人员开始探索激活状态干预技术,即在模型运行时直接操控网络中的中间激活值。通过修改关键层的激活状态,可以实现更精细、更即时的行为调整,比如修正错误的事实信息或引导模型避开敏感内容。激活干预通常结合反向传播技术,能够快速实现目标任务的定向控制,且对模型整体结构影响较小。

该方法的优势在于能够针对具体实例动态调整,提升生成文本的准确性和可靠性。 尽管激活干预灵活高效,但其副作用和稳健性问题也不容忽视。为实现更持久且系统性的变革,权重编辑成为了另一重要方向。权重编辑指的是对预训练模型中的参数进行针对性、极小幅度的调整,以永久性地改变模型行为。该方法通过形式化控制问题,寻求最小化干预的同时最大化目标行为的改变。权重编辑不仅可以修复模型中存在的错误认知,还可以注入新的知识或功能,从根本上提升模型对特定领域任务的适应能力。

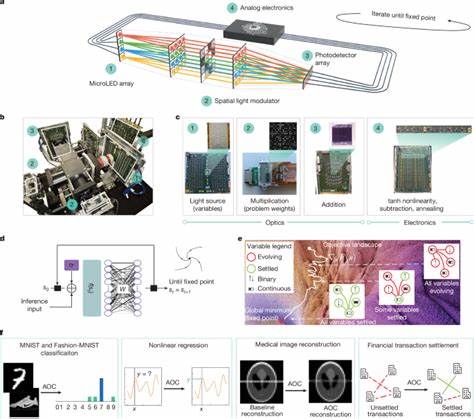

相比于全量微调,权重编辑更加高效且资源消耗较低,适用于快速部署和版本更新。 综合应用提示工程、激活状态干预与权重编辑,可以构建一个统一的操控框架,实现对大型语言模型多层面、多场景的精准控制。这个框架使得研究者能够根据实际需求灵活选择和组合对应策略,达到性能与可控性的平衡。尤其在复杂任务如情感调控、事实纠正以及道德规范引导等领域,多手段协同能显著提高文本生成的质量和安全性。值得关注的是,这些技术尽管带来便利,也存在潜在风险,包括模型被恶意操控、隐私泄露或生成有害内容,需要业界共同制定相关规范和防护机制。 理论分析表明,通过适度且有针对性的权重更新,变换器模型能够实现预期行为的调整,同时保持底层功能的稳定性和广泛适用性。

实验数据支持权重编辑技术在情感控制和事实编辑等任务上,成功率超过90%,且对基础性能的影响极小。与此同时,在实际应用过程中需权衡模型的泛化能力与特定任务的专用性,避免权重编辑导致的过拟合或偏差。此外,对激活干预的鲁棒性也需深入研究,以防对抗样本或异常输入带来的潜在安全威胁。 伦理层面上,操控大型语言模型的能力既是机遇也是挑战。有效的模型控制有助于强化内容安全和避免偏见,促进AI技术的正向发展。然而,若被不法分子利用,则可能造成误导性信息传播、隐私侵犯及社会信任危机。

为此,研发过程中必须引入严格的评估机制和伦理审查,确保技术应用符合社会规范和法律法规。未来,构建透明、可解释且安全的控制机制,将成为推动语言模型可持续发展的关键。 当前,围绕变换器 Hacks 的研究正在快速推进,从理论到实践均取得了显著成果。随着计算资源和算法的提升,结合强化学习与生成对抗网络等先进方法,实现更动态智能的模型控制将成为可能。同时,多模态融合与跨领域迁移学习为操控提供了更丰富的手段和应用场景。用户也将期望通过更便捷的接口对模型进行定制化,满足个性化需求。

总之,通过提示工程、激活状态干预与权重编辑三大技术路径,研究者已经逐步破解了大型变换器模型的"黑盒"特性,为实现人工智能文本生成的精准、可靠和安全控制奠定了坚实基础。未来随着技术的成熟与多方协作,我们有望见证更加智能、可控且具备高度适应性的语言模型在各行各业发挥重要价值,助推数字时代的智能革新。理解并合理运用这些"hack"策略,将是每一位从业者和研究者的重要技能与使命。 。