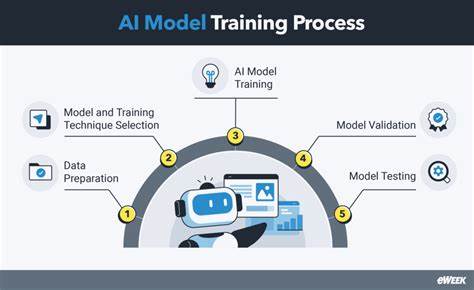

近年来,人工智能特别是大型语言模型(LLM)的发展引起了社会各界的广泛关注。几乎所有的主流观点都认为,当前强大的AI模型离不开海量的版权受保护内容作为训练基础。事实上,主流AI企业一直声称,没有这些版权材料,今天的先进AI工具根本无法存在。然而,最新的科研成果却挑战了这一固有认知。多家顶尖机构联合开展的研究表明,完全依靠公开领域和开源许可的数据,也可以训练出性能可观的AI模型,尽管这一过程辛苦且充满挑战。这一发现不仅有助于打破版权与AI训练之间的紧张关系,还将对未来的法律规范和产业实践产生持久影响。

此次合作涉及包括麻省理工学院、卡内基梅隆大学、多伦多大学等14个不同科研单位,以及非营利组织向量研究所(Vector Institute)和艾伦人工智能研究所(Allen Institute for AI)。研究团队构建了一套包含约8TB数据的伦理来源训练集,其中包括美国国会图书馆公开的13万册书籍。这些数据经过严格筛选,确保全部内容均为公共领域或符合开放许可标准。基于这套数据,研究团队训练出了一款参数量约为七十亿的语言模型。令人惊讶的是,该模型的表现水平与2023年Meta发布的Llama 2-7B模型相当。尽管并未直接对比最新的顶尖模型,但这一结果足以证明:无版权材料的数据集同样具备训练有效大型语言模型的潜力。

尽管研究结果令人振奋,但整个过程充满了繁琐与艰辛。研究团队反映,绝大部分原始数据并非机器可读格式,必须依靠人工逐一校对和注释,这无疑增加了大量人力成本和时间开销。此外,在数据采集过程中,法律合规审核极为复杂,团队需要详细识别不同网站和内容的版权状态,确保所有素材均符合公开许可规范,避免侵犯版权。这一点对于未来想要复制该方案的组织而言,是一大难题。虽然训练出的模型在性能上超过或者与同期主流模型相当,但依然存在瓶颈,尤其是在规模和多样性上远不能与那些使用大量商业版权材料的模型相媲美。因此,为什么AI巨头依然倾向于使用版权保护内容?原因主要在于便捷性与效益最大化。

拥有丰富且多样的文本资源,不仅能够增强模型的理解和生成能力,还大幅缩短训练周期和开发成本,这在商业竞争日益激烈的背景下极具吸引力。显然,仅靠公开领域内容满足顶尖AI模型需求,目前来看还较为困难。不过,这项研究的意义不仅是技术上的突破,更是对现有产业说辞的有力反驳。此前,OpenAI向英国议会委员会公开表示,没有版权材料的训练模型基本上不可行。Anthropic一位专家证人更直言,若AI公司必须为训练数据购买许可,LLM甚至可能无法诞生。通过实践证明另一条路径存在,这在未来的版权诉讼、政策制定和伦理讨论中无疑将成为重要论据。

对于行业整体而言,该研究提醒我们对AI训练数据来源与使用伦理需有更审慎的思考。如何在尊重知识产权的基础上,实现模型训练的可持续发展和技术创新,是未来推动AI普惠应用的关键课题。同时,推动开放内容生态建设,比如公共领域数字化、开放许可推广以及增强数据可读性,也同样值得关注。事实上,AI训练不再必须强依赖版权内容,也为中小型研究机构和创业企业提供了新的可能。减少对付费版权内容的依赖,能够降低准入门槛和成本,推动竞争多元化,避免行业垄断,并在一定程度上缓解版权纠纷和诉讼风险。对整体科技创新生态而言也更具包容性。

不过,要想全面实现这一愿景,仍需大量投入基础设施建设与人工支持。自动化数据处理技术、智能合规审核系统和高效的公开资源整理策略都是必不可少的环节。此种模式下,AI模型可能在某些应用场景会逊色于行业领跑者,但其伦理规范和法律合规优势无疑更突出。在未来,法律监管部门极有可能将类似研究成果作为制定新规的参考,推动版块划分更加清晰明晰,构建更加公平合理的AI产业生态。而在用户角度,越来越多人开始关注数据隐私与版权保护,期待AI能在不侵犯个人和知识产权的前提下,提供优质的智能服务。与此同时,学术界也将继续深挖非版权材料在多模态、多语种模型训练中的潜力,进一步提升伦理AI的适用范围和智能水平。

理论上,训练数据忽视版权标签,将促进更透明、更可追踪的AI研发过程,有助于构建公众信任和社会认可。综上所述,虽然依靠公开领域与开源许可内容训练AI模型仍存在诸多挑战,但其实践价值和社会意义不可小觑。未来技术进步和协同合作有望降低人力与法律障碍,实现更高效且更合规的模型训练流程。行业玩家应正视这一趋势,积极探索多元化数据策略,推动AI技术健康演进。社会对知识产权保护与创新促进之间的平衡视角,也必将在持续讨论中日趋成熟。可以预见,AI训练将迈向一个新的阶段,版权限制不再是必不可少的桎梏,而成为推动创新与伦理并行的驱动力。

。