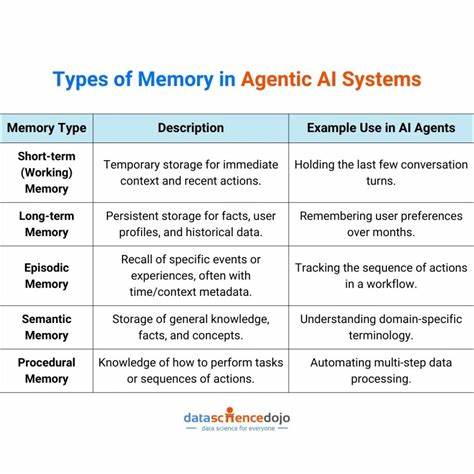

在人工智能迅速发展的今天,大型语言模型(LLM)正从传统的无状态文本生成器,向具备学习、回忆与推理能力的智能体转变。而智能体记忆,作为支持这一转变的关键技术,成为热门且备受关注的研究领域。智能体记忆不仅能够存储丰富的用户历史交互数据,还能通过语义搜索和行为规则学习,实现更加个性化和上下文相关的反馈,极大提升了智能代理的实用价值和用户体验。 智能体记忆的核心在于如何将海量信息结构化地编码为向量,并结合元数据构建高效的检索系统。这种向量化的记忆存储方式,允许模型快速定位与当前查询语境高度相关的过去体验,从而避免重复生成或信息遗漏,同时拓展了模型的信息覆盖面。通过语义搜索技术,智能代理能够超越关键词匹配,实现基于语意相似度的精准内容召回,真正做到知其然且知其所以然。

行为规则学习则是智能体记忆中另一重要组成部分,系统会追踪用户的交互模式,动态提炼和更新个性化规则。这些规则帮助模型适应用户的偏好和需求变化,自动调整回答策略,比如在技术支持场景下优先提供详细代码示例,或在性能优化问题中重点加入关键性能指标的解释。基于规则的行为调节不仅提高了响应的专业度,也增强了用户的信任感和粘性。 从架构角度看,构建生产级的智能体记忆系统必须统筹考虑响应时延、检索准确率和系统资源利用率。设计通常划分为实时查询、每日更新和每周维护三个层面。实时查询负责快速提取属性、执行语义搜索、生成动态系统提示并调用LLM推理,确保大部分请求在四秒内响应。

每日任务专注于新记忆链接和规则挖掘,以保证记忆图谱的连贯与行为模型的及时更新。每周则执行压缩、修剪和索引重建,平衡存储效率与系统稳定性,防止存储膨胀和性能下降。 优化技术贯穿了整个系统设计。预测性记忆预取策略根据历史查询模式提前加载潜在相关信息,有效降低冷启动查询的延迟。语义缓存则利用高速缓存储存近期检索的向量,显著减少数据库调用频次和检索延时,提升整体运行效率。元数据过滤通过类别、用户标识和时间戳等字段缩小搜索范围,减轻向量搜索的计算压力。

加权插入机制则根据记忆的新鲜度和用户反馈动态调整记忆的重要性分值,保证检索结果既新颖又具备高相关性,极大增强了智能体记忆的实用性能。 在具体应用时,系统通过结构化的属性提取将用户输入转换成多维标签,如类别、关键词、意图和复杂度等,作为过滤和召回的基础。随后,系统检索向量数据库中与查询最相关的记忆碎片,并结合行为规则形成上下文丰富的提示消息。令模型不仅能够"回忆"过去的经验,还能遵循个性化规则调整输出风格,产生更切合实际需求的建议或解决方案。 记忆生成环节同样经过严格设计。系统会汇总用户查询、模型响应、相关记忆片段及活跃规则,调用LLM按照预定义的JSON模式自动创建新记忆条目。

为了确保记忆内容的客观、准确,系统设置多重校验机制,包括格式约束、用户反馈融合及独立评估模型审核,极力防止信息虚构和记忆质量下降。此外,通过模型轮换和人工抽查等手段避免模型偏差和记忆模式的过度收敛,保障迭代更新的稳定性和健康性。 长期维护层面,记忆的多层压缩策略使得较新的记忆保持高精度存储,而随着时间递增,采用半精度、8位量化乃至动态压缩技术逐步降低存储体积,最大化节约资源同时保持检索准确率。在链接新记忆和发现行为规则的过程中,系统构建出双向的记忆图谱,丰富了检索路径,支持多跳查询,强化了智能代理的逻辑推理能力和上下文理解能力。 当前的生产指标显示,经过上述设计与优化,智能体记忆系统能够在95百分位保持3.2秒左右的高响应速度,检索到90%以上的上下文相关记忆,实现近九成的缓存命中率,并将存储成本降低超过60%。这些数据不仅反映出系统的技术先进性,也代表了类似系统广泛应用于技术支持、智能助理和个性化推荐等领域的可行性与前景。

未来,智能体记忆的发展方向将向多模态扩展,不仅局限于文本,还将涵盖图片、代码截图和流程图等多样化信息,实现更丰富生动的记忆载体。同时,团队共享的协同记忆网络正成为研究热点,支持多个用户共同构建知识图,实现集体智慧的长期积累。智能驱动的记忆遗忘机制也将成为必备功能,自动识别和剔除过时信息,保留核心知识,实现高效的记忆整理与进化。 综上所述,智能体记忆作为提升大型语言模型从静态文本生成器向动态学习代理转型的关键技术,涵盖了从向量存储、行为规则学习到多层优化和长期维护的全生命周期设计。合理运用预测预取、语义缓存和加权插入等创新手段,不仅能显著提升模型响应速度和内容相关性,还能控制系统成本和规模扩展,满足真实世界复杂场景的需求。随着技术的不断进步和生态环境的成熟,智能体记忆将引领下一代AI智能体在理解、推理与个性化服务上的全面跃升,成为人工智能应用的新标杆。

。